國際版的Azure 已經可以正常支持Spark應用,但是當我們在使用中國版的Azure的時候,在Azure中國版官網裏面發現了有對Spark服務的介紹,而真正去使用的時候,卻發現無法創建。只有Storm,HBase和Hadoop。如圖:

那問題來了,中國版Azure的HDInsight是否支持Spark?

答案當然可以,不過需要自定義一下:

首先我們需要創建一個PAAS 層SQL Database 用來用以存儲Hive、Oozie的元數據。

創建基於PAAS 層的HADOOP 集羣:

HDInsight 3.1 clusters會安裝Spark 1.0.2

HDInsight 3.2 clusters會安裝Spark 1.2.0配置集羣節點和虛擬機:

配置訪問用戶,勾選配置Oozie雲存儲:

配置Oozie存儲SQL Database數據庫:

配置存儲:

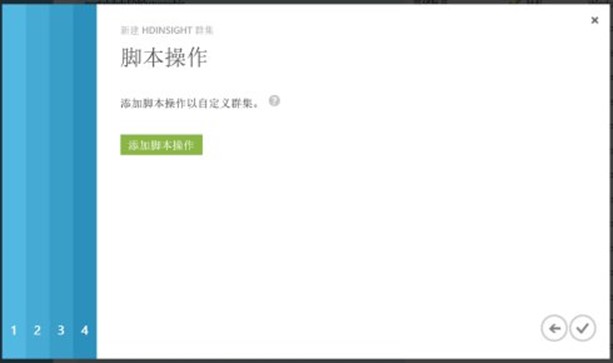

使用腳本安裝Spark:

插入Spark 配置腳步:

https://hdiconfigactions.blob.core.windows.net/sparkconfigactionv03/spark-installer-v03.ps1 。節點類型選擇"僅頭結點"

最後點擊"創建"按鈕即可。