1. oVirt+SSAN超融合概述

虛擬化技術在不斷發展中日趨成熟,隨之而來各種雲技術方興未艾,對存儲性能提出了更高的要求。傳統網絡存儲不僅因爲性能無法滿足不斷變化的虛擬化需求,而且是虛擬化環境中成本和管理複雜性的源頭,逐漸成爲牽絆虛擬化發展的某種瓶頸,超融合(HCI)技術的問世使得虛擬化環境下的存儲問題迎刃而解。

超融合技術是爲突破虛擬化環境下存儲性能瓶頸的制約,提出的一種軟件定義的分佈式存儲與虛擬化環境相融合的解決方案。超融合技術基於通用的x86平臺將存儲資源進行整合使存儲成本可控,採用分佈式架構有效避免了單點故障風險。分佈式存儲完全由軟件定義,靈活部署升級簡易,合理分配HDD與SSD資源提高性能突破I/O瓶頸。在滿足高度需求的同時降低經濟成本與使用難度,使得該技術在存儲界頗受歡迎。

超融合作爲新型的存儲方式,以簡約、穩定、可靠的特性成爲業界靚點,吸引較多廠商投入研發。除Nutanix先發制人在超融合領域處於領先地位外,不僅以EMC爲首的存儲廠商參與其中,以VMware爲代表的虛擬化廠商也競相研發,國內更有華爲等一系列公司推出自主研發的分佈式存儲產品,使得分佈式存儲技術成爲當下存儲行業發展的主流,超融合技術有望成爲下一代數據中心的未來。

1.1 HCI超融合方案

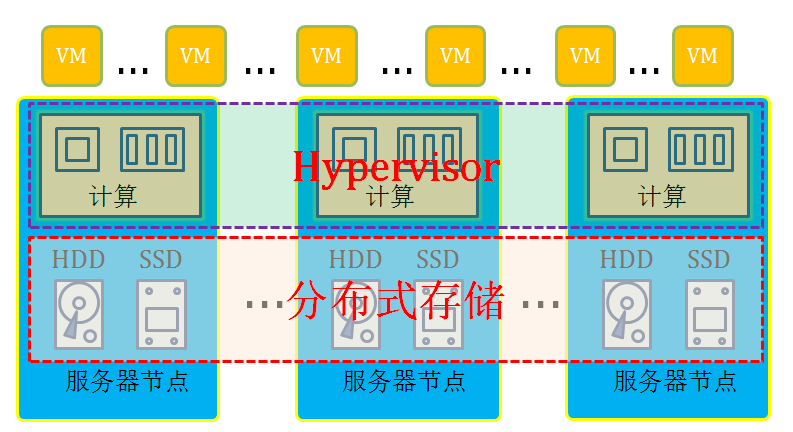

超融合架構(HCI)是指在同一套單元設備中不僅僅具備計算、網絡、存儲和服務器虛擬化等資源和技術,而且還包括備份軟件、快照技術、重複數據刪除、在線數據壓縮等元素,而多套單元設備可以通過網絡聚合起來,實現模塊化的無縫橫向擴展(scale-out),形成統一的資源池。超融合是將虛擬化計算和存儲資源融合到統一的系統管理平臺的解決方案。

超融合新穎之處在於底層採用分佈式存儲,分佈式存儲基於通用x86平臺將存儲資源進行整合,支持副本與糾刪碼方式保護數據,提高冗餘性,多服務器節點資源聚合,有效規避了傳統存儲單點故障的風險,且存儲性能隨節點增多而線性增加。分佈式存儲完全由軟件定義,合理配置SSD與HDD資源將I/O性能發揮到極致,有效解決了傳統存儲在虛擬化場景中性能不足的問題。採用Share-nothing設計架構,支持橫向擴展,容量不足時可以增加服務器節點彈性水平擴展,整個集羣無擴展瓶頸。此外,分佈式存儲還具備統一的管理平臺、交付簡易、維護簡單、無孤島效應、經濟成本低等優點。分佈式存儲主要有Nutanix、vSAN、FusionStorage、Ceph、GlusterFS、SSAN等產品。

oVirt虛擬化平臺+SSAN分佈式存儲是典型的超融合架構,物理服務器既是計算資源又是存儲資源,不僅極大程度提高資源利用率,降低成本,而且保證系統高性能穩定運行。可以自由選擇副本與糾刪碼任意的數據冗餘方式,在安全性上比傳統存儲更有保障,性能上有較大提升,完全能夠滿足傳統SAN存儲所不能達到的高IO性能需求。支持物理融合與超融合兩種部署模式,是實現軟件定義存儲技術的終極途徑,可以爲存儲帶來最優的效率、靈活性、規模、成本和數據保護。

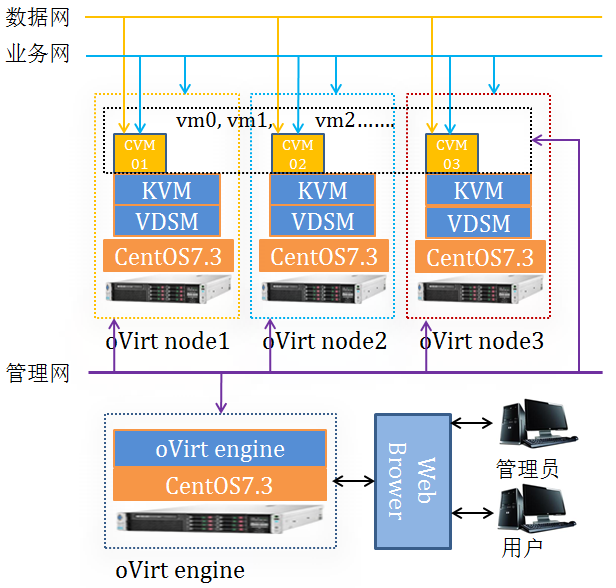

1.2 oVirt虛擬化管理平臺

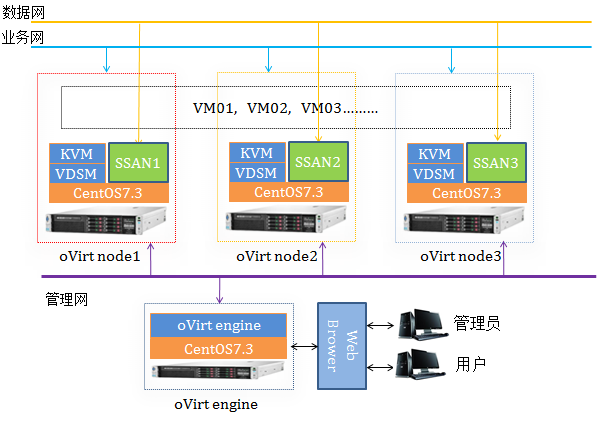

oVirt是基於KVM虛擬化組建私有云平臺的管理工具。oVirt以web界面的方式管理KVM虛擬化環境,主要由Engine和Node兩部分組成,Engine是oVirt中的管理節點,提供web界面與用戶交互,使Node節點管理可視化。Node是oVirt中的計算節點,底層專注KVM虛擬化,併爲虛擬機運行提供計算資源。oVirt是數據中心虛擬化管理平臺解決方案,數據中心是邏輯的概念,按照主數據存儲的組織方式劃分,以便快速構建私有云。oVirt主要應用於桌面雲和服務器虛擬化,因此對存儲性能要求較高。

oVirt Engine負責整個系統的管理維護是整個oVirt管理平臺的核心部件,Engine節點內置數據庫記錄整個系統中所有的虛擬機配置、節點狀態、系統環境、存儲器等信息。實現管理的邏輯、狀態及策略,良好的web界面客戶端,使系統管理員通過網頁進行管理系統的任何操作。oVirt Node只負責提供計算資源及功能實現,不記錄任何信息,僅僅負責實現虛擬機器與設備的創建與修改,資源的共享與保護。Node節點可以由普通Linux操作系統安裝VDSM組件構成,也可以是專爲Node定製的Linux操作系統。VDSM是維繫Node節點與Engine關係的紐帶,負責節點的自啓動與註冊及對網絡、存儲、主機、虛擬機的管理,支持對虛擬機的外部干涉、內存與存儲的合併與超支等功能。Node節點系統重啓後內容消失,從而保證了Node的無狀態性。

oVirt管理平臺具有以下特點:

(1)高可用性。集羣無潛在的單點故障,任何Node 節點崩潰會由其他節點取代而繼續提供服務,不影響集羣功能。Engine異常時Node依然能正常工作,虛擬機繼續進行。

(2)高伸縮性。添加 Node 和 SAN時,VDSM服務會自動完成,幾乎不需要手動設置。

(3)集羣安全性。VDSM 對正在操作的磁盤鏡像進行排它性保護。

(4)備份與恢復。磁盤鏡像間有相互關聯的特性記錄可進行引用、備份操作。

(5)性能優化。利用多線程與多進程減少操作堵塞狀況。

1.3 SSAN分佈式塊存儲

TaoCloud SSAN是典型的ServerSAN產品,遵循軟件定義存儲理念,可從X86服務器硬件平臺的本地存儲資源中創建基於服務器的SAN,以便按需提供具有彈性的、可擴展的分佈式存儲容量和性能。SSAN採用去中心化的全對等Share-nothing架構,融入Scale-out分佈式塊存儲技術、支持在線動態擴展磁盤或者節點時,系統自動執行數據均衡。SSAN支持集羣管理、重複數據刪除、數據壓縮及校驗,具有強一致性確保多副本數據相同。藉助SSD、10GbE網絡等高速硬件,通過軟件的方式實現存儲池化、快照、克隆、分層、精簡配置等企業級的數據功能。支持iSCSI、QEMU、Cinder多種訪問接口,在桌面雲、虛擬化、數據庫、替換傳統SAN/IPSAN存儲等場景應用較多。

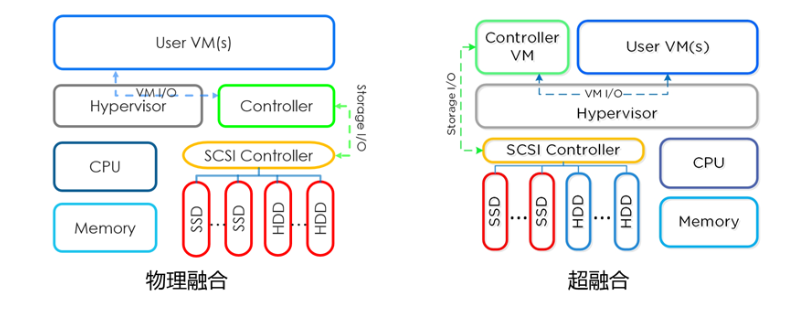

SSAN支持物理融合和超融合兩種部署模式,物理融合中將SSAN直接部署在底層物理服務器中運行,與虛擬化共用服務器計算資源,併爲虛擬化環境提供分佈式存儲服務。超融合部署時將SSAN部署在每臺服務器上運行的CVM虛擬機中,物理服務器作爲計算節點的同時也是存儲節點,通過標準iSCSI接口實現高效的I/O數據訪問。

TaoCloud SSAN具備分佈式存儲的以下特徵:

(1)彈性存儲,支持在線擴容,無擴展瓶頸;

(2)集羣配置,無單點故障風險;;

(3)單卷最大256TB,卷級冗餘策略,支持副本和糾刪碼;

(4)iSCSI標準接口,支持多路徑及各類VDI平臺,容易對接各種應用系統;

(5)SSD+HDD混合模式,利用原有磁盤資源,並對讀寫加速。

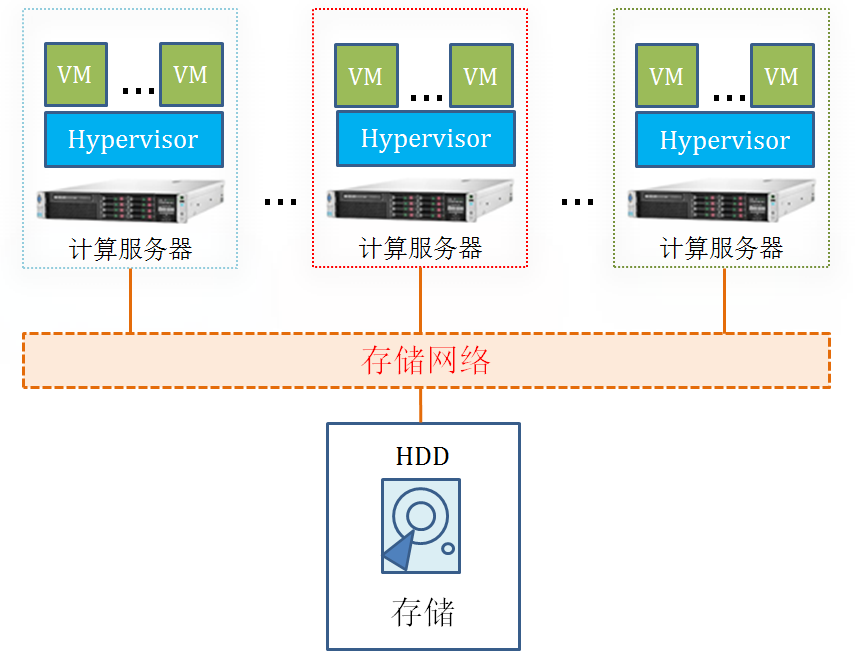

1.4 傳統存儲的問題

傳統網絡存儲被定義爲一種特殊的專用數據存儲服務器,包括存儲器件和內嵌系統軟件,可提供跨平臺文件共享功能,主要有DAS、NAS、SAN三種存儲方式。傳統存儲允許用戶在網絡上存取數據,能夠集中管理和處理網絡上所有數據,應用廣泛,在處理一般業務時,具有可靠、穩定、安全、快速等優點。但傳統存儲自身也存在問題令人擔憂,最主要的是單點故障,基於集中式存儲架構,存儲服務器一旦發生故障,將造成數據不可訪問,風險較大。在虛擬化場景中,無法發揮SSD性能,I/O易成瓶頸,無法滿足需求。此外,傳統存儲還存在控制器數量有限、無法擴展、管理運維複雜、異構硬件、成本高、升級困難、孤島效應、數據備份操作複雜等缺陷。

新興超融合技術有效解決了傳統存儲中遇到的以上問題,在I/O性能上取得突破的同時降低存儲使用成本與管理複雜度,使得存儲容量擴展、產品升級變得簡單易行,消滅傳統存儲孤島效應後增加了數據備份功能。

2. 超融合與物理融合

2.1 超融合方式

超融合是在傳統存儲性能瓶頸與市場剛性需求下催生的一種新技術,該技術解決了較多業界難題,補齊了傳統存儲性能先天不足與單點故障的短板,較物理融合又有計算資源需求低、資源消耗可控、服務隔離等優勢。超融合並非只爲突出某一特性,而是針對功能、性能、擴展性、維護等多種問題綜合分析的最佳解決方案。

性能剛需

oVirt+SSAN超融合解決方案有效滿足了oVirt虛擬化環境對存儲高併發、高I/O性能的需求,比物理融合具有更好的性能和更低的成本。oVirt開源IaaS平臺多用於桌面雲和服務器虛擬化。服務器虛擬化與雲桌面是典型的多客戶端、高併發應用,隨着虛擬機數量的增多,對存儲的容量和性能呈明顯的上升趨勢。啓動風暴以及集中病毒掃描和關機風暴,對存儲I/O提出了更高的彈性要求,以滿足峯值性能需求。如果沒有數據高可用支持,實現桌面業務連續性會很困難或者代價太高。桌面部署時,會要求快速生成新的大量的桌面鏡像,需要高效的快照、克隆技術。

功能齊全

HCI分佈式存儲是實現模板數據、鏡像數據、配置數據、業務數據的統一存儲,幾乎支持傳統存儲的所有功能。採用三副本或糾刪碼的冗餘存儲方式,極大限度的降低了存單點故障的風險。SSD+HDD的磁盤緩存模式,不僅充分發揮了SSD的磁盤性能,而且能繼續使用原有的HDD,不會造成原有磁盤資源的浪費,又突破了高併發需求的I/O瓶頸,以及高效的ROW快照及克隆功能可支持快速、批量的創建桌面。運行的虛擬機可以在線遷移,支持FT功能,具有高可用特性。LUN上支持創建、克隆、刪除虛擬機磁盤,並能將LUN直接作爲虛擬機系統盤使用。

隨時擴展

Scale-out架構的彈性存儲支持在線擴容,補齊了存儲控制器數量有限,無法擴展的功能短板。需要擴展容量時可以直接在線添加物理磁盤,添加後只需簡單的操作使系統識別磁盤後使用。在線增加節點時只需在現有集羣基礎上直接增加存儲節點,將新加節點創建OSD劃分給存儲池,系統自動進行負載均衡操作。磁盤擴容與節點擴容的所有操作都不需要中斷任何服務,完全可以在分佈式存儲進行數據訪問的任意時刻進行。

維護簡單

超融合分佈式存儲是軟件定義存儲,圖形化管理界面的簡單操作可以執行配置、使用、維護、升級等所有任務,不需要專業極強的技術人員維護,短時間內即可完成更新升級,解決了異構硬件成本高、升級困難的技術難題。

部署靈活

SSAN支持物理融合和超融合部署方式,但更推薦超融合部署,方案中採用也是SSAN+oVirt超融合部署。用戶通過oVirt Engine提供的web管理界面在每臺KVM虛擬化的Node節點上創建CVM虛擬機,每臺物理服務器既是oVirt計算節點,同時也是SSAN存儲節點,提高了服務器物理資源利用效率,避免不必要的浪費,進而降低了成本。超融合部署使得SSAN存儲資源與VDI主機計算資源融合,可以更好發揮本地存儲優先訪問策略優勢,進一步提升I/O效率,在高性能需求上有所突破。虛擬化環境對虛擬機固有快照及備份操作能夠使節點出現異常後短時間內恢復正常,相比物理融合故障恢復操作簡單快捷,更能保證業務恢復的及時性。

採用超融合部署方式既穩定高效,又靈活部署、簡單易用,降低了運維難度和使用成本。超融合部署具有以下特點:

(1)服務隔離。分佈式存儲服務部署在虛擬機中與虛擬化服務分開隔離,同時運行而不相互影響,確保安全、穩定、可靠。

(2)資源可控。分配虛擬機節點指定資源,將資源限制在合理範圍內,服務異常時資源消耗受限,不會影響其他服務的正常運行。

(3)節點備份。利用虛擬化平臺的克隆備份與快照備份相結合的備份方式對CVM虛擬機節點進行定時備份,防止節點服務異常時導致分佈式存儲系統崩潰。

(4)故障易恢復。節點服務異常時,利用快照備份技術進行恢復,簡易快捷,保證分佈式存儲系統故障恢復的及時性。

2.2 物理融合方式

SSAN分佈式存儲同時支持物理融合的部署方式,物理融合即分佈式存儲服務與虛擬化軟件同時部署在物理服務器上,分佈式存儲服務可直接管理磁盤資源而不必做磁盤穿透。在相同數量的物理服務器上虛擬化服務構成虛擬化集羣,分佈式存儲服務組建存儲集羣,聚合所有的數據盤資源,將所有數據盤整合到存儲池中後進行虛擬磁盤分配,可以自由選擇副本或糾刪碼的數據冗餘方式保護數據,通過iscsi網絡共享。

存儲通過iSCSI連接到計算節點。物理融合中SSAN服務對於物理資源的佔有率較高,使得物理資源的計算性能略有提升,但資源緊張時會與虛擬化環境爭奪資源,而超融合部署方式中CVM虛擬機提供的計算資源完全能夠滿足SSAN服務的性能需求。且能夠將資源限制在可控範圍內,使存儲與虛擬化環境隔離,各自運行互不干擾。因此,物理融合的部署方式稍遜色超融合部署。

三節點是保證分佈式存儲與虛擬化所有功能實現的集羣起步節點數量,oVirt-Engine需要部署在單獨的物理服務器上,因此按照物理融合部署方式需要4臺物理服務器,3臺用於部署SSAN與oVirt-Node節點,1臺作爲oVirt-Engine管理節點。管理網可用1G網絡,用於管理所有服務器及虛擬機,業務網與數據網推薦採用10G網絡,數據網用於SSAN節點內部數據傳輸,確保3節點數據具有強一致性,業務網用於連接SSAN節點與所有SSAN客戶端節點,供客戶端訪問數據。此種物理部署方式下分佈式存儲服務容易與虛擬化環境競爭資源,兩者之間相互干擾會影響到性能平衡性和系統QoS服務質量,因此通常需要採用CGroup/LXC等技術對物理資源進行隔離和合理分配。

2.3 兩種融合對比

按照是否完全以虛擬化爲中心,把融合方式分爲物理融合和超融合兩種。對於這兩種部署方式應從存儲性能、經濟成本等多方面分析對比。從分佈式存儲角度來講,物理融合與超融合不相上下,都符合分佈式存儲的原則和理論,且相比來說性能區別不大,伯仲之間。物理融合不需要做磁盤透傳,分佈式存儲直接接管物理資源,具有部署簡單方便等優勢。不需要單獨劃分虛擬機,在虛擬化管理界面中的誤操作不會對分佈式存儲造成影響,分佈式存儲不依賴於虛擬化環境,虛擬化崩潰不影響分佈式存儲繼續運行。

雖然物理融合有較多的優勢,卻始終不如超融合那樣廣受歡迎,主要由於其自身存在硬傷。首先,物理融合不能進行節點系統快照備份,一旦存儲服務出現問題,恢復困難。其次,將分佈式存儲服務與虛擬化服務同時部署在底層操作系統,會使兩種服務競爭計算資源,且資源使用不可控,資源競爭容易導致存儲或虛擬化環境穩定性問題。不僅如此,一旦存儲出現問題需要重啓主機時必然影響虛擬化環境繼續提供服務,可能影響虛擬化環境運行業務甚至整個集羣,牽一髮而動全身,增加額外風險。

超融合技術的設計架構從原理上避免了以上問題,在實際使用中證明了相對於物理融合的優越性。虛擬化技術發展多年趨於成熟,已廣泛應用於各種生產環境運行業務,其穩定性和可靠性早已無需多言,完全能夠達到同物理機相同的水準。通過劃分CVM虛擬機運行分佈式存儲服務以達到超融合的目的,合理配置存儲服務使用資源,服務異常時能夠將資源消耗限制在指定的範圍內,不會影響其他服務的正常運行,更不會對虛擬化環境造成干擾,解決了物理融合環境中服務競爭計算資源與資源消耗不可控的問題。虛擬化環境中可以對虛擬機進行快照備份與克隆備份,一旦CVM節點故障可以及時進行恢復操作,確保分佈式存儲服務故障恢復的及時性。

物理融合與超融合部署的根本區別在存儲控制端的不同,超融合中將Hypervisor中的虛擬機作爲存儲控制端,計算和存儲部署在同一物理節點上,相當於多個組件集中部署在一個系統中,同時提供計算和存儲能力。物理融合直接將物理服務器作爲計算節點的同時提供存儲控制端服務,計算和存儲同時部署在底層操作系統,存儲通過iSCSI連接到計算節點,計算和存儲是同時運行在操作系統的兩種服務,理論上互不影響,但實踐證明處理不當很容易相互干擾,影響服務穩定性。超融合架構與物理融合不同在於是否完全以虛擬化計算爲中心,計算和存儲緊密相關,存儲由虛擬機而非物理機服務來控制並將分散的存儲資源形成統一的存儲池,而後再提供給Hypervisor用於創建應用虛擬機。

超融合架構方案中,每臺物理服務器單節點同時具備計算與存儲雙節點功能。每個計算節點配置一臺虛擬機作爲控制器(CVM),並將物理主機上的磁盤和網卡透傳給CVM,在所有CVM上部署SSAN形成統一的存儲資源池,所有應用虛擬機均創建在存儲池中。超融合架構實現了計算、存儲、網絡等資源的統一管理和調度,具有更彈性的橫向擴展能力,極大簡化了複雜IT系統的設計,可以更好地提高資源利用效率,降低成本。

超融合相比物理融合方案更具備如下優勢:

(1)完全軟件定義。獨立於硬件,採用商業通用標準硬件平臺,完全採用軟件實現計算、存儲、網絡等功能。

(2)完全虛擬化。以虛擬化計算爲中心,計算、存儲、網絡均由虛擬化引擎統一管理和調度,軟件定義存儲由虛擬機控制器CVM進行管理。

(3)完全分佈式。橫向擴展的分佈式系統,計算、存儲、網絡按需進行動態擴展,系統不存在任意單點故障,採用分佈式存儲。

(4)故障易恢復。利用虛擬機快照等方式進行備份,若CVM節點故障或異常,可短時間內恢復保證業務系統恢復的及時性。

綜上所述,超融合技術經濟成本與物理融合毫無差別,性能上區別不大,但都優於傳統集中式共享存儲,而在資源消耗可控與服務節點備份方面較物理融合有明顯優勢。因此,超融合技術是虛擬化環境中目前最好的選擇,正在成爲下一代數據中心的主流基礎架構。

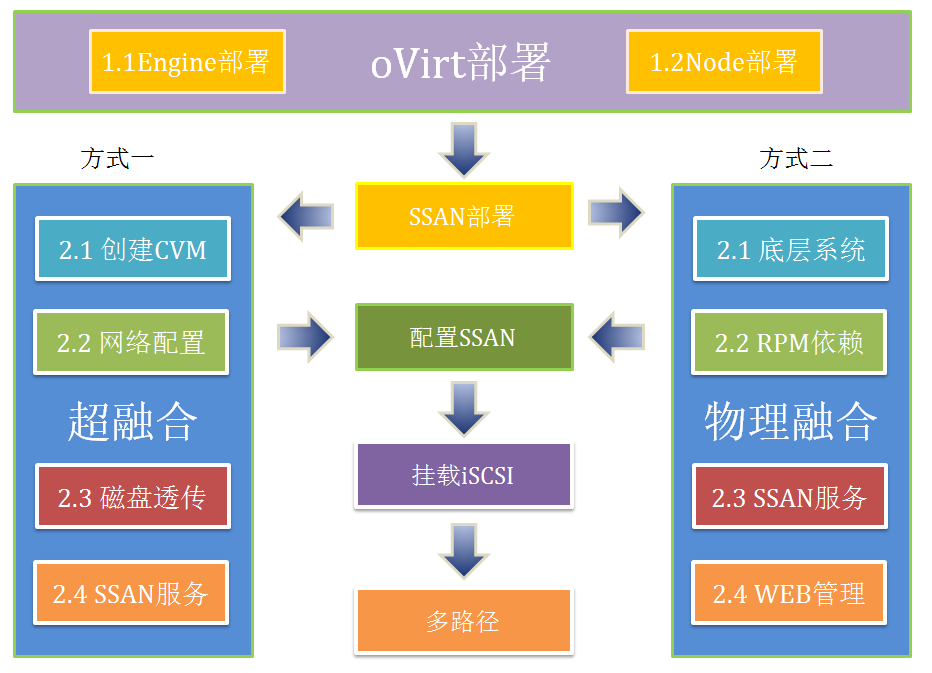

3. 超融合部署

3.1 oVirt部署

(1)部署底層系統

oVirt虛擬化所有服務都需要將Linux系統作爲底層運行環境。因此,將四臺物理服務器全部安裝CentOS7.3 minimal 64位操作系統。

(2)安裝管理節點

Engine作爲管理節點,是整個系統的核心部件,控制計算節點資源的使用,提供用戶訪問的web管理界面,Engine節點內置數據庫記錄整個系統中所有的虛擬機配置、節點、系統、存儲器狀態等信息。管理的邏輯、狀態及策略全部在 Engine 中設置與實現。

oVirt-Engine採用yum源的安裝方式,配置所有主機的oVirt yum源,執行如下命令:

sudo yum install http://mirror.isoc.org.il/pub/ovirt/yum-repo/ovirt-release41.rpm

Engine節點需要yum安裝oVirt-Engine,Node節點需要部署VDSM與KVM服務。配置好所有yum源後在管理節點安裝oVirt-Engine,執行如下命令:

sudo yum install ovirt-engine –y

(3)配置oVirt Engine

執行命令:

ovirt-engine setup

除部分需要填寫的名稱外,其餘全部爲默認,配置信息

(4)安裝計算節點

oVirt Node作爲虛擬化環境的計算節點,負責提供計算資源,搭建時需要在Linux操作系統部署VDSM和KVM服務。首先,需要確保Node節點能夠ping通外網,且Node節點yum源配置正確,之後執行命令setenforce 0 關閉所有Node節點的SELinux,回到Engine管理界面直接添加oVirt Node節點,即完成oVirt Node安裝。

(5)配置NFS存儲

oVirt集羣有本地存儲與共享存儲兩種方式,由於本地存儲集羣中只能添加單臺Node節點,所以爲了更好發揮集羣特性,採用NFS共享存儲方式,在每臺Node節點上配置單獨的NFS存儲用於安裝CVM虛擬機,執行以下命令:

cat /etc/exports #按照以下內容編輯exports文件 /export/ iso *(rw,sync,no_subtree_check,all_squash,anonuid=36,anongid=36) /export/ data *(rw,sync,no_subtree_check,all_squash,anonuid=36,anongid=36) systemctl start nfs.service #啓動nfs服務 systemctl enable nfs.service #設置nfs服務開機自啓動

3.2 SSAN部署

3.2.1 超融合

(1)創建CVM

在每臺Node節點分別創建CVM虛擬機,需要注意每個Node節點上運行的CVM虛擬機所使用的NFS存儲均由該主機提供,每臺CVM虛擬機用於運行SSAN服務。配置網絡時確保管理網用1G,數據網與業務網用10G。具體規格要求如表所示。

(2)物理磁盤透傳

超融合環境中爲更好的發揮存儲性能,需要將物理磁盤直接透傳給CVM虛擬機節點進行管理,磁盤透傳採用FC存儲類型方式,直接在Engine頁面進行操作,以保證虛擬機無縫處理磁盤塊級設備。在數據中心-磁盤菜單下,點擊【新建】-【直接LUN】-【存儲類型】中,選擇Fibre Channel類型,可以顯示物理服務器的所有磁盤信息,選擇要透傳給虛擬機的磁盤。

(3)安裝SSAN

在CVM虛擬機管理節點,首先解決RPM依賴關係,由於SSAN安裝採用腳本方式安裝,在各個節點依次執行安裝腳本並配置相應參數,在參數配置項中根據集羣信息實際內容填寫。

#./ssan_install.sh

WEB GUI是用戶對SSAN系統進行配置和管理的圖形界面,SSAN服務安裝好後選擇集羣中管理服務器安裝WEB服務。

#./ssanweb_install.sh

在瀏覽器輸入管理服務器ip地址,打開SSAN圖形管理界面按照以下流程配置。

(4)配置iSCSI共享存儲

SSAN主要用於給oVirt虛擬化環境提供iscsi共享存儲,以確保虛擬機能夠在線遷移、支持高可用,並且能快速批量創建。在oVirt環境中新建存儲域,添加SSAN提供的iscsi共享存儲,並使用該存儲驗證功能及性能。

(5)多路徑設置

客戶端通過掛載多個分佈式存儲節點ip,配置主備模式的多路徑。在主節點宕機的情況下依然能夠保證數據訪問高可用,不影響業務運行,併發揮本地存儲優先訪問策略,進一步提高存儲性能。

3.2.2 物理融合

物理融合中SSAN服務直接運行在底層操作系統。因此,要將SSAN分佈式存儲軟件包上傳至oVirt Node物理服務器,解決好RPM依賴包關係後執行安裝腳本進行安裝部署服務,配置WEB GUI。

#./ssan_install.sh #./ssanweb_install.sh

用web管理界面進行節點添加、磁盤初始化、創建存儲池、配置OSD、新建虛擬磁盤、匹配iscsi目標等相應配置,之後進入oVirt管理界面配置iscsi共享存儲與存儲多路徑。

3.2.3 差異分析

超融合與物理融合兩種部署方式的根本區別在於SSAN服務運行環境的不同。超融合部署時SSAN服務運行在單獨的CVM虛擬機環境中,需要創建CVM虛擬機,由此引起物理磁盤透傳、網卡透傳等操作。物理融合時SSAN服務運行在物理服務器底層Linux操作系統,只需將SSAN軟件包上傳至服務器系統直接部署,進行相應的配置,不需要其他任何操作。

部署方式的差異將直接導致分佈式存儲控制端不同,物理服務器作爲計算資源的同時提供存儲服務。超融合中劃分單獨CVM虛擬機作爲存儲控制器,管理服務器內部磁盤資源,分佈式存儲服務依賴於虛擬化環境運行。在CVM虛擬機中運行分佈式存儲服務,使存儲服務與虛擬化服務相互隔離、各自運行、互不影響,且能夠完全控制分佈式存儲服務資源消耗,根據需求合理規劃物理服務器資源,有效避免了服務異常時互相爭奪資源的窘況。

物理融合中虛擬化服務與分佈式存儲服務同時運行在底層Linux操作系統,在底層系統部署虛擬化服務的同時直接部署分佈式存儲服務,減少了超融合部署中創建CVM虛擬機、物理磁盤透傳、網卡透傳、CVM網絡規劃配置等步驟,實施過程更加簡單方便。但無法避免架構設計存在的固有缺陷。分佈式存儲服務與虛擬化服務在底層操作系統同時運行,兩種服務容易競爭計算資源,資源消耗無法控制,資源競爭易導致虛擬化環境或分佈式存儲服務的系統穩定性和性能抖動。物理融合中分佈式存儲控制端節點不支持快照備份,一旦存儲服務出現問題,恢復極其困難。

綜合資源消耗可控性、服務運行穩定性、環境隔離與干擾性、業務恢復及時性等多方面因素,超融合部署方式較物理融合有顯著優勢,是現有情況下發揮存儲性能、提高資源利用率、完全軟件定義存儲、遵循完全分佈式原則的最佳解決方案。

4. 最佳實踐

SSAN是軟件定義分佈式塊存儲,具有彈性在線擴展特性,支持最大節點數量爲1024以上,集羣最大192PB存儲容量,小規模集羣部署中推薦3節點起配置,根據實際需求發展在線擴容。理論上存儲性能隨着節點數量增加而近線性增長,企業模式部署推薦最佳配置單一集羣規模控制在128節點以內,這個配置能夠滿足絕大多數企業需求,且存儲效率和性能達到最優配置。

物理服務器推薦E52630v2CPU或更高,64GB內存配置,配置SSD緩存時SSD緩存容量大小爲HDD容量的20%。物理服務器至少配備3塊網卡,管理網絡使用1G,數據網絡和業務網絡採用10G。CVM虛擬機節點建議配置4vCPU、8G內存、20G系統盤用於生產環境,測試環境中可以配置2vCPU、4G內存、20G系統盤,安裝CentOS6.7 minimal操作系統作爲SSAN服務運行環境。

5. 小結

超融合作爲新興的IT基礎架構解決方案,在性能提升、功能實現等方面較物理融合有明顯優勢。超融合能夠提高資源利用率,在物理主機中部署低配置虛擬機耗費資源較少,發揮了成本優勢;本地優先訪問策略提升數據傳輸速率,發揮了性能優勢;CVM虛擬機節點能夠隨時做快照與備份,更能夠保證業務中斷後恢復的及時性。

oVirt+SSAN作爲超融合架構中的典型方案架構,頗具代表性的展示了虛擬化與分佈式存儲組建超融合環境的優勢。突破傳統存儲性能需求瓶頸,解決物理融合計算資源消耗不可控的問題,支持副本與糾刪碼兩種冗餘方式保證數據安全,遵循完全由軟件定義、數據中心完全虛擬化、存儲完全分佈式的設計原則,具有故障易恢復的特點。該超融合方案部署方便,運維簡單,降低經濟成本與人力資源消耗,非常適用於桌面雲、服務器虛擬化、私有云等應用場景。

關於更多技術文章,歡迎關注大道科技!