一、前言

openstack當下已成爲各大公有云廠商的首選,作者也在一個公有云廠商做外協(對,就是那個出摺疊屏手機的廠商),他家的網絡設備默認是做白名單(deny any),只允許指定放通的流量經過,生產環境中出於網絡安全的因素也不允許permit any any,本文就詳細說明他家的openstack公有云場放通哪些網絡平面及爲什麼要放通這些平面。我們假設每個服務器有4張網卡,管理和業務流量分開,eth0/eth1走管理流量,eth4/eth5走業務流量進行說明。

二、openstack的構成

openstack是一個雲操作系統,大體可分爲:控制節點,計算節點、網絡節點、存儲結點,生產環境中爲了避免網絡節點成爲瓶頸都會開啓dvr功能(即東西走向的流量不會再經過網絡節點,南北走向的流量也只當vm在沒有fip的情況下才會走網絡節點),上述架構可以簡化爲下圖所示:

三、vm的創建過程

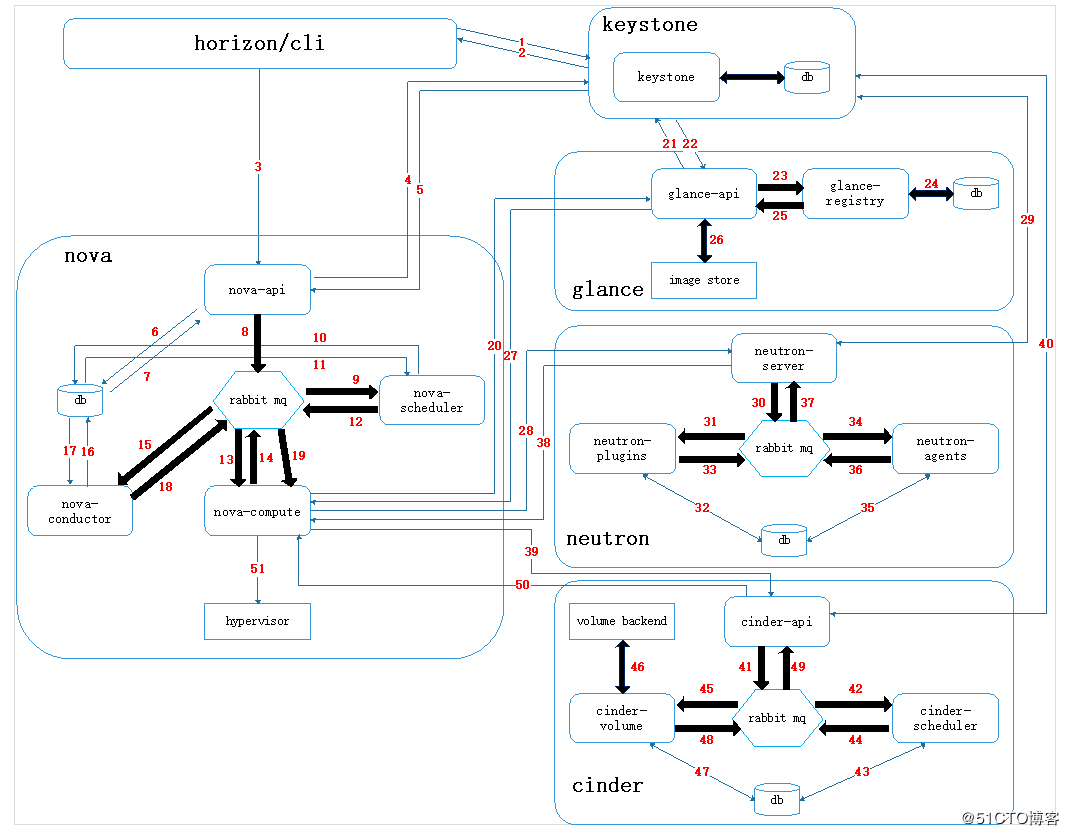

要了解放通vlan的準則,首先要了解一個vm在openstack中是如何生成的,每一個vm稱爲一個實例,每一個實例好比一臺電腦,一個電腦要能正常工作,除了有計算資源外還需要有操作系統、網絡、硬盤,這些功能在openstack中對應的通過nova、glance、neutron和cinder組建實現。下圖是簡化後的vm創建流程,詳細流程可以參考作者其他博文。簡化後虛擬機的創建流程爲:

- 客戶端通過keystone認證後,發起vm創建請求;

- nova-api接收到請求後,通過scheduler組件選擇一個承載vm的宿主機;

- nova-compute組件提供vm所需要的計算功能,同時向glance、neutron、cinder組件的api發起請求,請求鏡像、網絡和存儲資源。至此,一個電腦所需的組件就已經具備齊全;

- nova-conpute通過libvert聯繫提供hypervisor的計算節點主機(kvm、xen,vmware等)。

四、放通vlan說明

1.管理節點

管理節點使用eth0/eth1作爲管理接口,生產場景中操作系統由pxe進行安裝,安裝後的主機通過管理平面進行通信,同時nova-conpute需要通過各組件的api請求資源,並對後端存儲進行管理,所以需要放通的vlan爲:

==eth0/eth1==

pvid:

- pxe #安裝操作系統;

vlan:

- om #主機間管理平面通信;

- api #nova-conpute向其他組件發起請求;

- storage #管理節點管理後端存儲;

- vtep #他家的產品中需要創建2個管理虛擬機對物理主機和虛擬機進行管理,所以還需要放通vtep平面。

| 端口 | 放通vlan |

|---|---|

| eth0/eth1 | pvid:pxe vlan:om/api/vtep/storage |

2.計算節點

計算節點在上圖中表示爲hypervisor,是實際提供計算能力的主機,eth0/eth1作爲管理口,eth4/eth5作爲業務口,放通的vlan爲:

==eth0/eth1==

pvid:

- pxe #安裝操作系統;

vlan:

- om #主機間管理平面通信;

- storage #vm實際存儲在後端存儲中,需要計算節點能夠訪問存儲節點。

==eth4/eth5==

vlan:

- vtep #計算節點之間建立的vxlan隧道,用於不同宿主機上vm間的通信;

- fip #爲計算節點內部的vm提供dnat功能,可以讓用戶通過internet訪問(eip轉換成fip)。

| 端口 | 放通vlan |

|---|---|

| eth0/eth1 | pvid:pxe vlan:om/storage |

| eth4/eth5 | vlan:vtep/fip |

3.存儲節點

存儲節點使用eth0/eth1作爲管理業務口,放通的vlan爲:

==eth0/eth1==

pvid:

- om #安裝操作系統及管理流量,此處沒有爲pxe單獨劃分一個vlan,pxe使用的是om平面的vlan;

vlan:

- storage #存儲節點的業務平面。

| 端口 | 放通vlan |

|---|---|

| eth0/eth1 | pvid:om vlan:storage |

以上就是openstack公有云場景下需要放通的網絡平面。