作者 | 阿里雲容器平臺高級技術專家 曾凡鬆(逐靈)

本文主要介紹阿里巴巴在大規模生產環境中落地 Kubernetes 的過程中,在集羣規模上遇到的典型問題以及對應的解決方案,內容包含對 etcd、kube-apiserver、kube-controller 的若干性能及穩定性增強,這些關鍵的增強是阿里巴巴內部上萬節點的 Kubernetes 集羣能夠平穩支撐 2019 年天貓 618 大促的關鍵所在。

背景

從阿里巴巴最早期的 AI 系統(2013)開始,集羣管理系統經歷了多輪的架構演進,到 2018 年全面的應用 Kubernetes ,這期間的故事是非常精彩的,有機會可以單獨給大家做一個分享。這裏忽略系統演進的過程,不去討論爲什麼 Kubernetes 能夠在社區和公司內部全面的勝出,而是將焦點關注到應用 Kubernetes 中會遇到什麼樣的問題,以及我們做了哪些關鍵的優化。

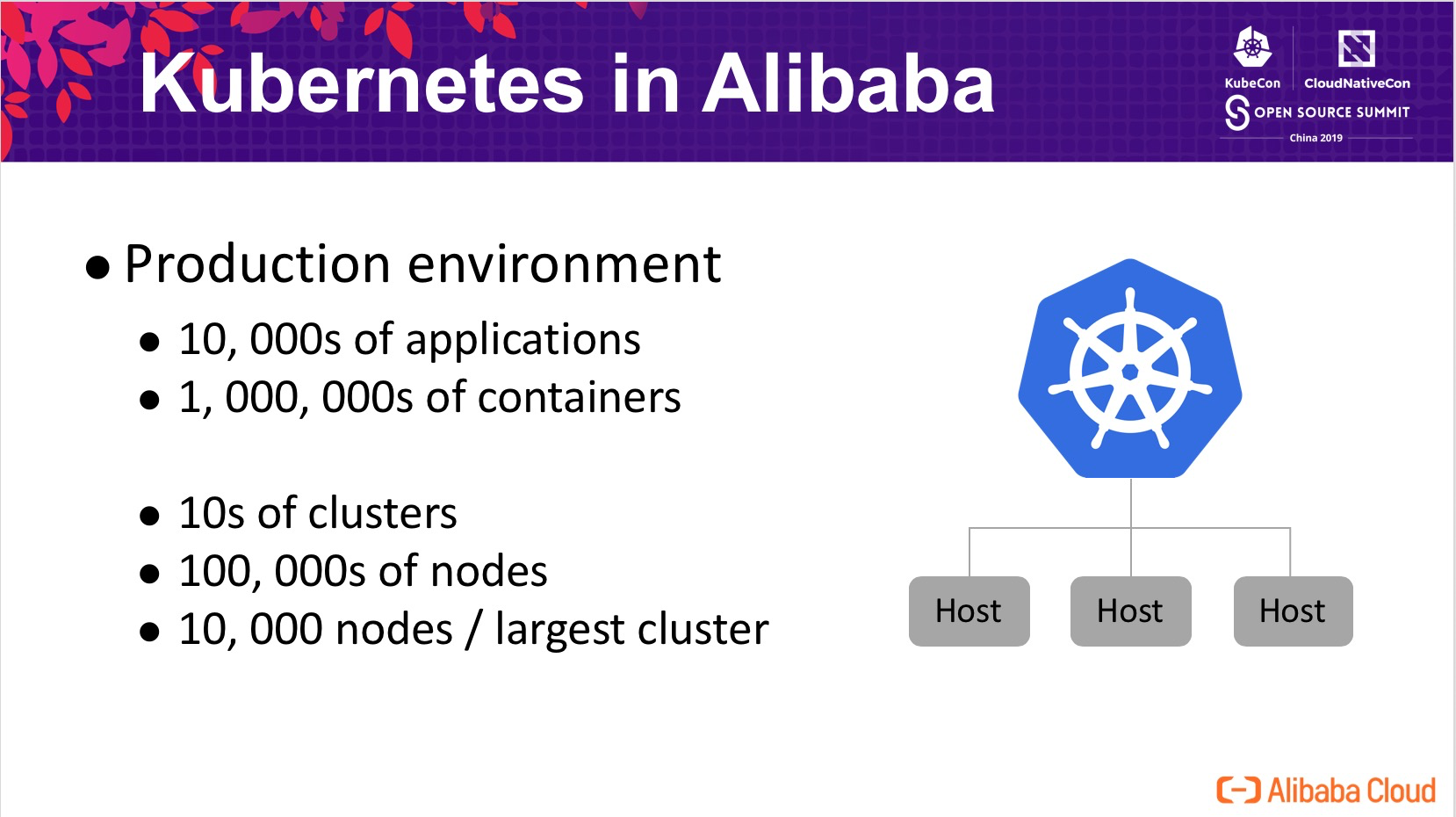

在阿里巴巴的生產環境中,容器化的應用超過了 10k 個,全網的容器在百萬的級別,運行在十幾萬臺宿主機上。支撐阿里巴巴核心電商業務的集羣有十幾個,最大的集羣有幾萬的節點。在落地 Kubernetes 的過程中,在規模上面臨了很大的挑戰,比如如何將 Kubernetes 應用到超大規模的生產級別。

羅馬不是一天就建成的,爲了瞭解 Kubernetes 的性能瓶頸,我們結合阿里的生產集羣現狀,估算了在 10k 個節點的集羣中,預計會達到的規模:

- 20w pods

- 100w objects

我們基於 Kubemark 搭建了大規模集羣模擬的平臺,通過一個容器啓動多個(50個)Kubemark 進程的方式,使用了 200 個 4c 的容器模擬了 10k 節點的 kubelet。在模擬集羣中運行常見的負載時,我們發現一些基本的操作比如 Pod 調度延遲非常高,達到了驚人的 10s 這一級別,並且集羣處在非常不穩定的狀態。

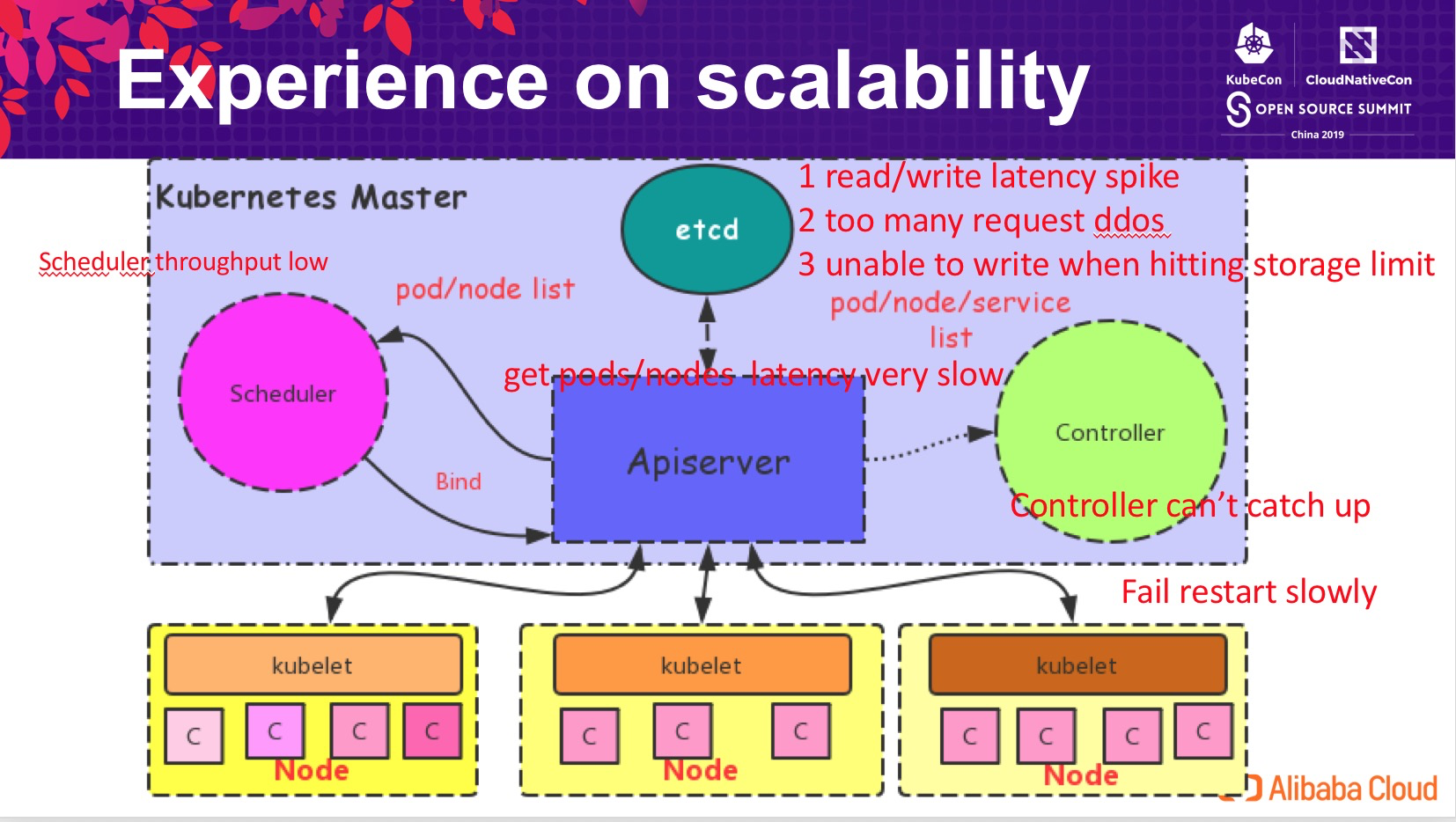

當 Kubernetes 集羣規模達到 10k 節點時,系統的各個組件均出現相應的性能問題,比如:

- etcd 中出現了大量的讀寫延遲,並且產生了拒絕服務的情形,同時因其空間的限制也無法承載 Kubernetes 存儲大量的對象;

- API Server 查詢 pods/nodes 延遲非常的高,併發查詢請求可能地址後端 etcd oom;

- Controller 不能及時從 API Server 感知到在最新的變化,處理的延時較高;當發生異常重啓時,服務的恢復時間需要幾分鐘;

- Scheduler 延遲高、吞吐低,無法適應阿里業務日常運維的需求,更無法支持大促態的極端場景。

etcd improvements

爲了解決這些問題,阿里雲容器平臺在各方面都做了很大的努力,改進 Kubernetes 在大規模場景下的性能。

首先是 etcd 層面,作爲 Kubernetes 存儲對象的數據庫,其對 Kubernetes 集羣的性能影響至關重要。

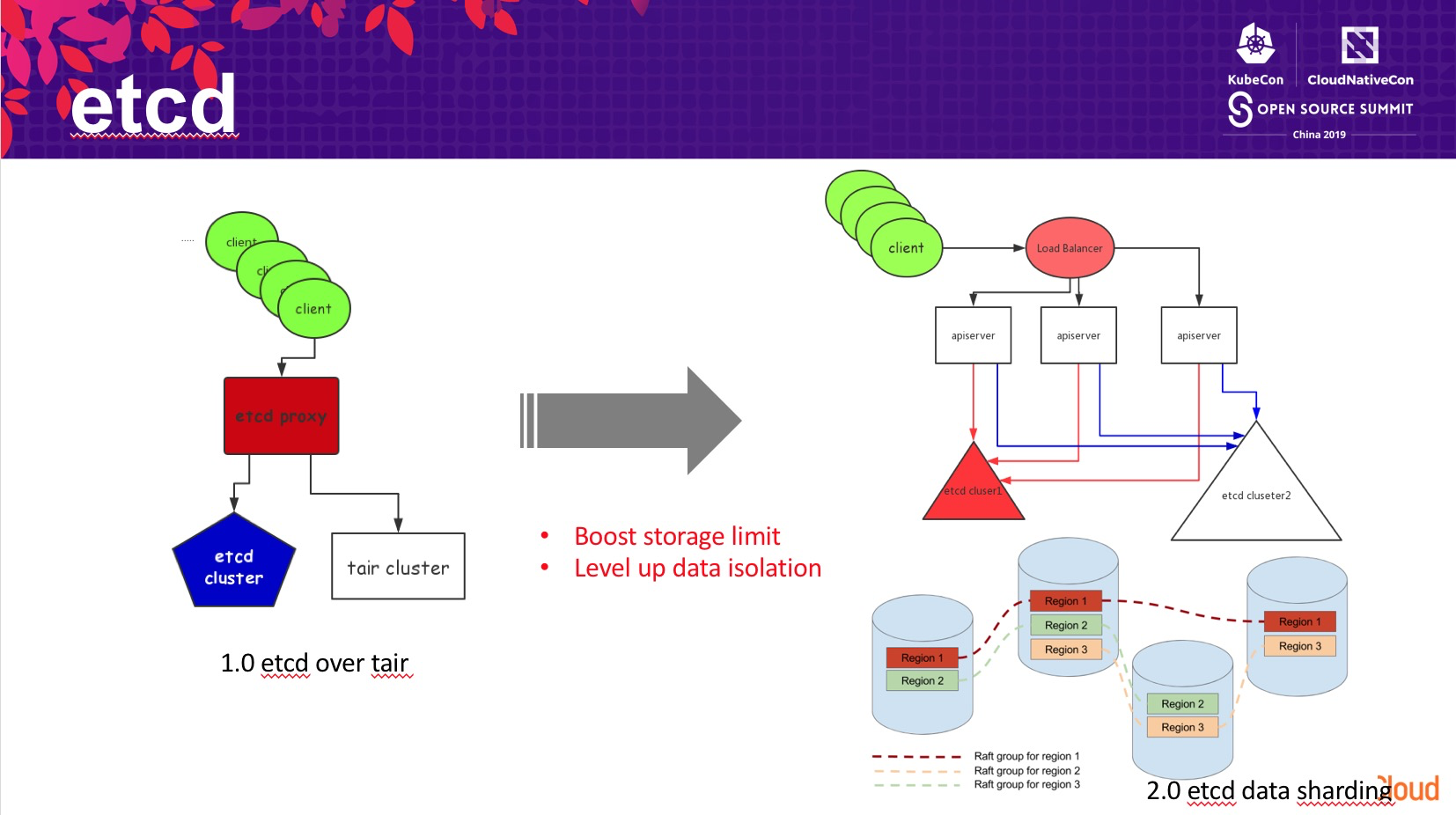

-

第一版本的改進,我們通過將 etcd 的數據轉存到 tair 集羣中,提高了 etcd 存儲的數據總量。但這個方式有一個顯著的弊端是額外增加的 tair 集羣,增加的運維複雜性對集羣中的數據安全性帶來了很大的挑戰,同時其數據一致性模型也並非基於 raft 複製組,犧牲了數據的安全性。

-

第二版本的改進,我們通過將 API Server 中不同類型的對象存儲到不同的 etcd 集羣中。從 etcd 內部看,也就對應了不同的數據目錄,通過將不同目錄的數據路由到不同的後端 etcd 中,從而降低了單個 etcd 集羣中存儲的數據總量,提高了擴展性。

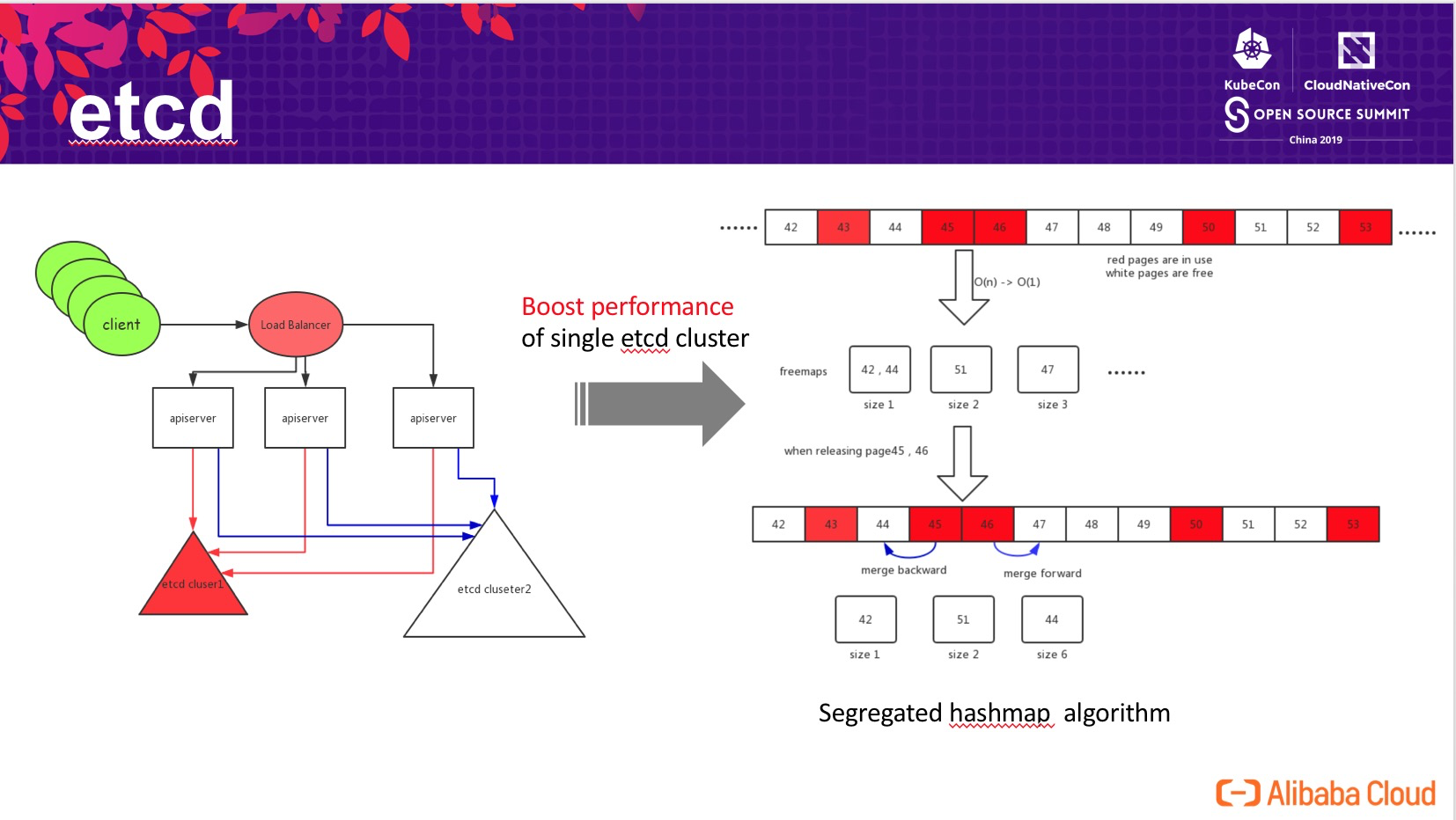

- 第三版本的改進,我們深入研究了 etcd 內部的實現原理,並發現了影響 etcd 擴展性的一個關鍵問題在底層 bbolt db 的 page 頁面分配算法上:隨着 etcd 中存儲的數據量的增長,bbolt db 中線性查找“連續長度爲 n 的 page 存儲頁面”的性能顯著下降。

爲了解決該問題,我們設計了基於 segregrated hashmap 的空閒頁面管理算法,hashmap 以連續 page 大小爲 key, 連續頁面起始 page id 爲 value。通過查這個 segregrated hashmap 實現 O(1) 的空閒 page 查找,極大地提高了性能。在釋放塊時,新算法嘗試和地址相鄰的 page 合併,並更新 segregrated hashmap。更詳細的算法分析可以見已發表在 CNCF 博客的博文:

https://www.cncf.io/blog/2019/05/09/performance-optimization-of-etcd-in-web-scale-data-scenario/

通過這個算法改進,我們可以將 etcd 的存儲空間從推薦的 2GB 擴展到 100GB,極大的提高了 etcd 存儲數據的規模,並且讀寫無顯著延遲增長。除此之外,我們也和谷歌工程師協作開發了 etcd raft learner(類 zookeeper observer)/fully concurrent read 等特性,在數據的安全性和讀寫性能上進行增強。這些改進已貢獻開源,將在社區 etcd 3.4 版本中發佈。

API Server improvements

Efficient node heartbeats

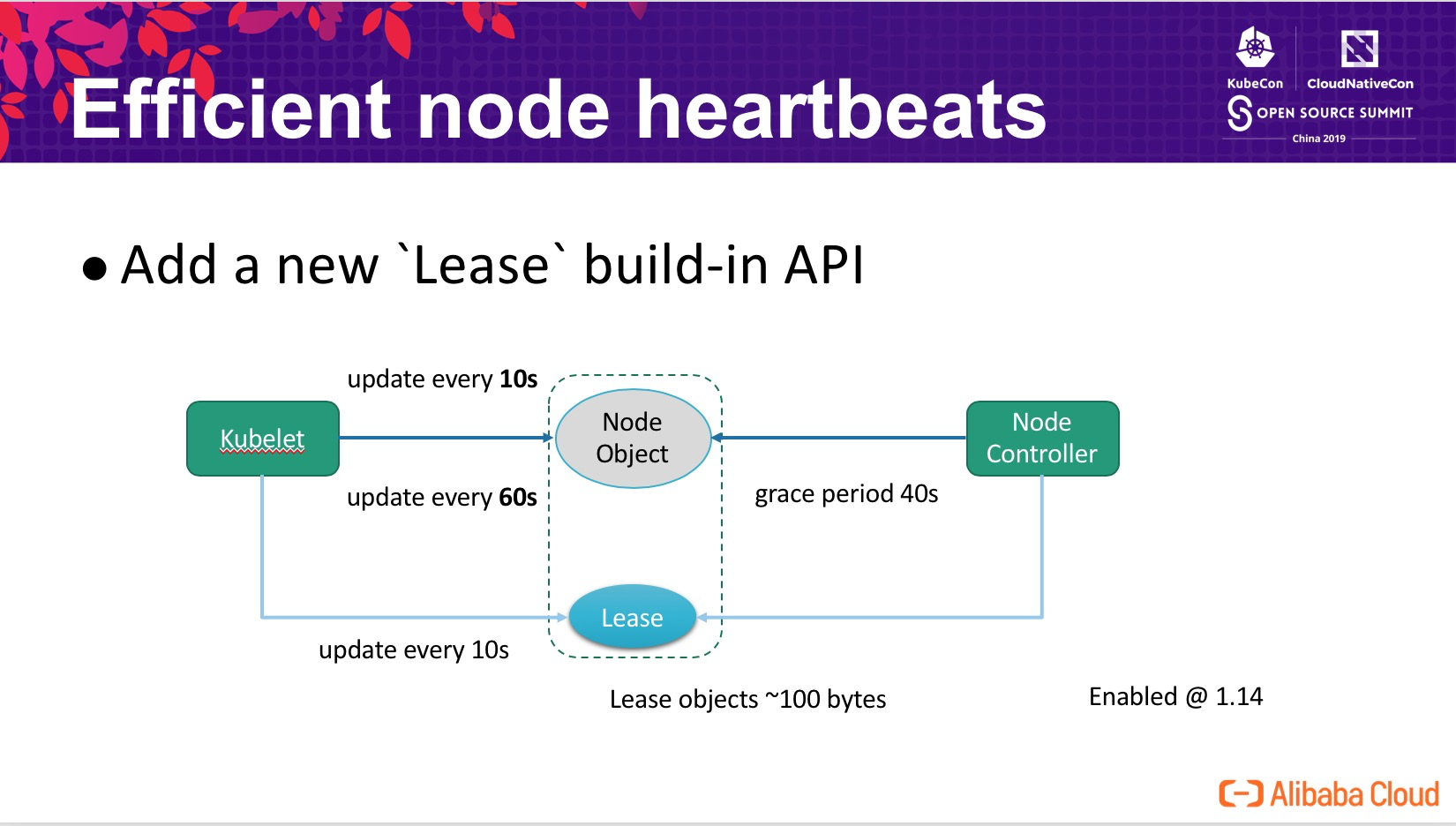

在 Kubernetes 集羣中,影響其擴展到更大規模的一個核心問題是如何有效的處理節點的心跳。在一個典型的生產環境中 (non-trival),kubelet 每 10s 彙報一次心跳,每次心跳請求的內容達到 15kb(包含節點上數十計的鏡像,和若干的卷信息),這會帶來兩大問題:

- 心跳請求觸發 etcd 中 node 對象的更新,在 10k nodes 的集羣中,這些更新將產生近 1GB/min 的 transaction logs(etcd 會記錄變更歷史);

- API Server 很高的 CPU 消耗,node 節點非常龐大,序列化/反序列化開銷很大,處理心跳請求的 CPU 開銷超過 API Server CPU 時間佔用的 80%。

爲了解決這個問題,Kubernetes 引入了一個新的 build-in Lease API ,將與心跳密切相關的信息從 node 對象中剝離出來,也就是上圖中的 Lease 。原本 kubelet 每 10s 更新一次 node 對象升級爲:

- 每 10s 更新一次 Lease 對象,表明該節點的存活狀態,Node Controller 根據該 Lease 對象的狀態來判斷節點是否存活;

- 處於兼容性的考慮,降低爲每 60s 更新一次 node 對象,使得 Eviction_ _Manager 等可以繼續按照原有的邏輯工作。

因爲 Lease 對象非常小,因此其更新的代價遠小於更新 node 對象。kubernetes 通過這個機制,顯著的降低了 API Server 的 CPU 開銷,同時也大幅減小了 etcd 中大量的 transaction logs,成功將其規模從 1000 擴展到了幾千個節點的規模,該功能在社區 Kubernetes-1.14 中已經默認啓用。

API Server load balancing

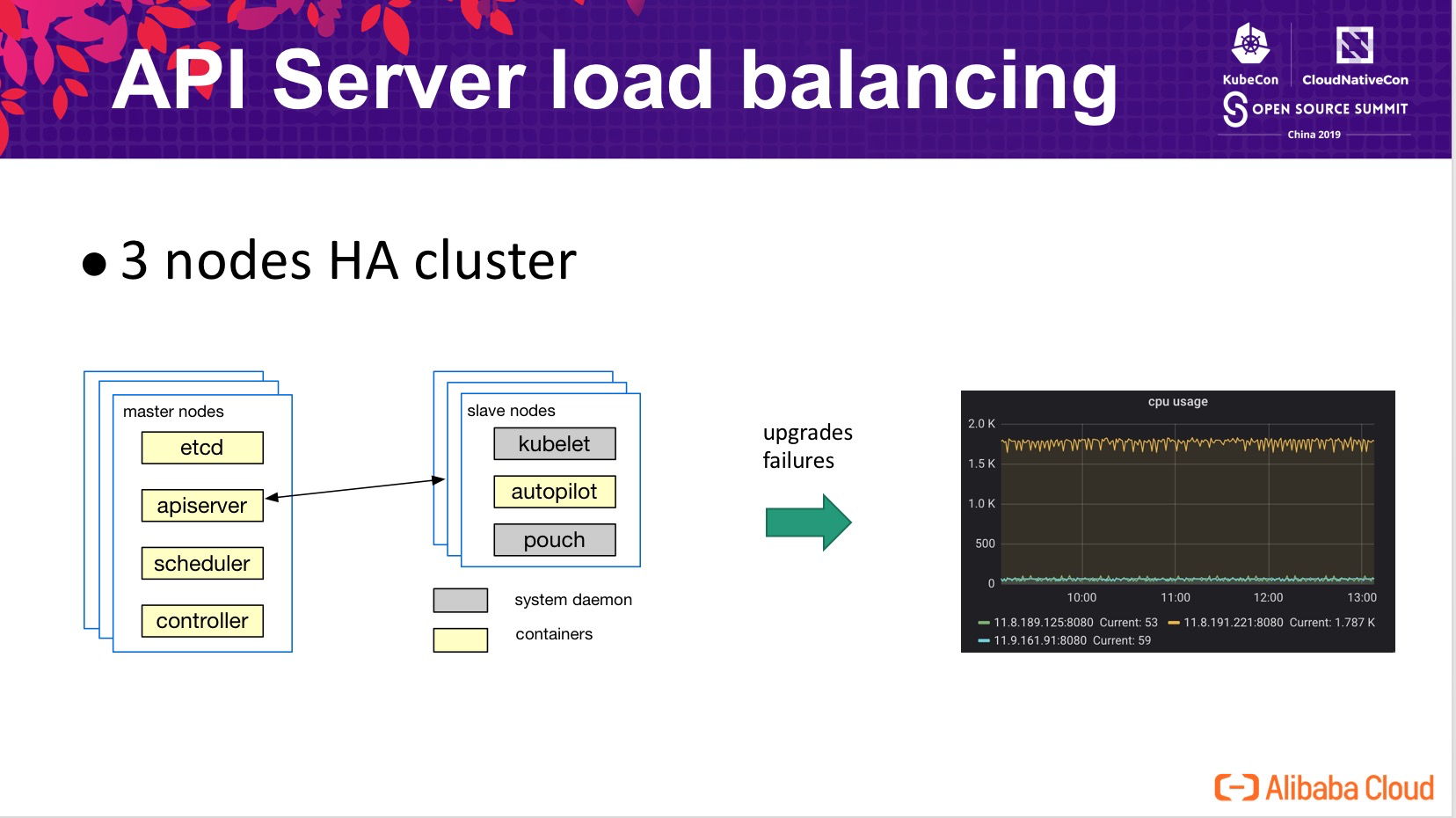

在生產集羣中,出於性能和可用性的考慮,通常會部署多個節點組成高可用 Kubernetes 集羣。但在高可用集羣實際的運行中,可能會出現多個 API Server 之間的負載不均衡,尤其是在集羣升級或部分節點發生故障重啓的時候。這給集羣的穩定性帶來了很大的壓力,原本計劃通過高可用的方式分攤 API Server 面臨的壓力,但在極端情況下所有壓力又回到了一個節點,導致系統響應時間變長,甚至擊垮該節點繼而導致雪崩。

下圖爲壓測集羣中模擬的一個 case,在三個節點的集羣,API Server 升級後所有的壓力均打到了其中一個 API Server 上,其 CPU 開銷遠高於其他兩個節點。

解決負載均衡問題,一個自然的思路就是增加 load balancer。前文的描述中提到,集羣中主要的負載是處理節點的心跳,那我們就在 API Server 與 kubelet 中間增加 lb,有兩個典型的思路:

- API Server 測增加 lb,所有的 kubelets 連接 lb,典型的雲廠商交付的 Kubernetes 集羣,就是這一模式;

- kubelet 測增加 lb,由 lb 來選擇 API Server。

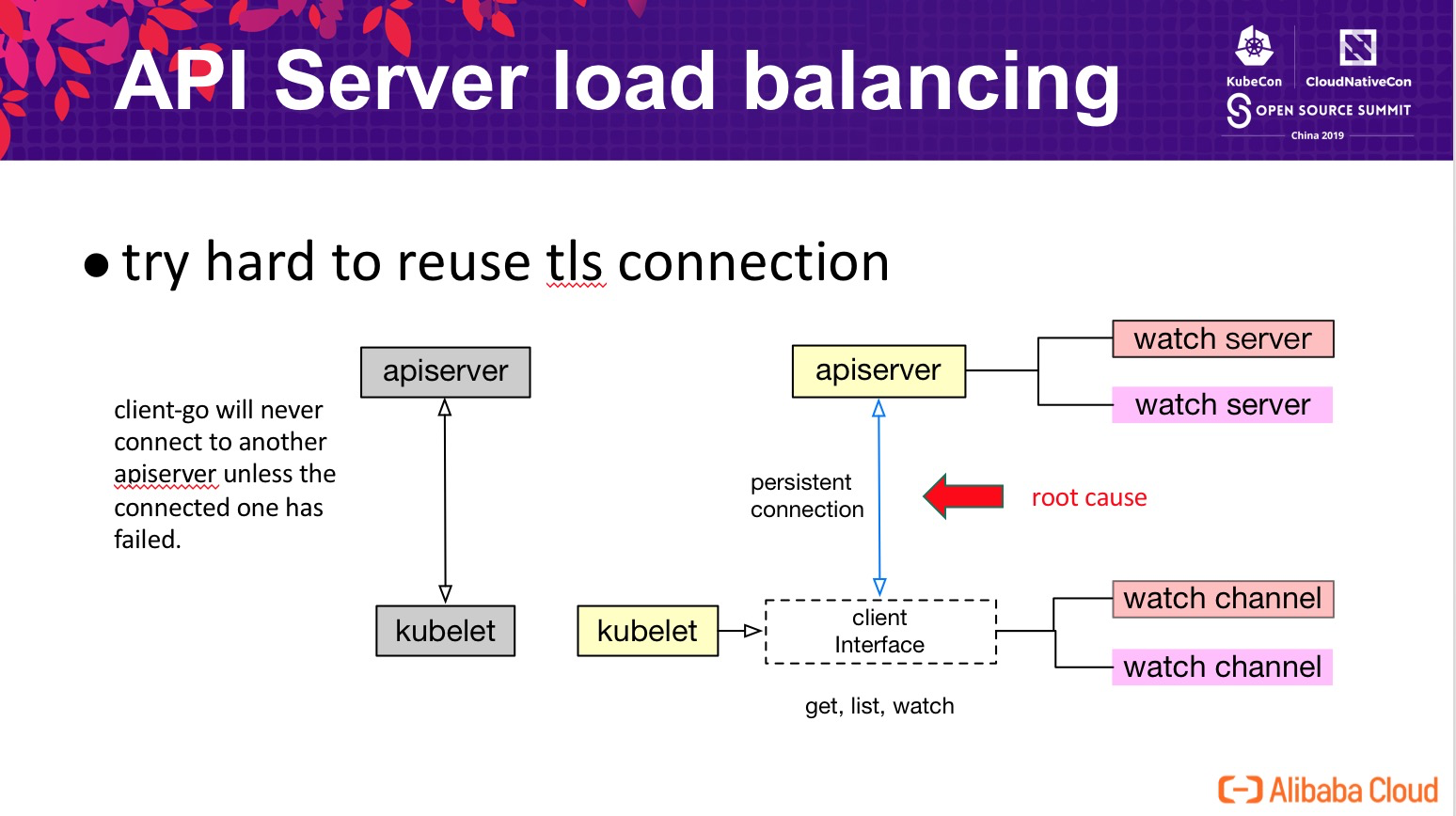

通過壓測環境驗證發現,增加 lb 並不能很好的解決上面提到的問題,我們必須要深入理解 Kubernetes 內部的通信機制。深入到 Kubernetes 中研究發現,爲了解決 tls 連接認證的開銷,Kubernetes 客戶端做了很多的努力確保“儘量複用同樣的 tls 連接”,大多數情況下客戶端 watcher 均工作在下層的同一個 tls 連接上,僅當這個連接發生異常時,纔可能會觸發重連繼而發生 API Server 的切換。其結果就是我們看到的,當 kubelet 連接到其中一個 API Server 後,基本上是不會發生負載切換。爲了解決這個問題,我們進行了三個方面的優化:

- API Server:認爲客戶端是不可信的,需要保護自己不被過載的請求擊潰。當自身負載超過一個閾值時,發送

409 - too many requests提醒客戶端退避;當自身負載超過一個更高的閾值時,通過關閉客戶端連接拒絕請求; - Client:在一個時間段內頻繁的收到

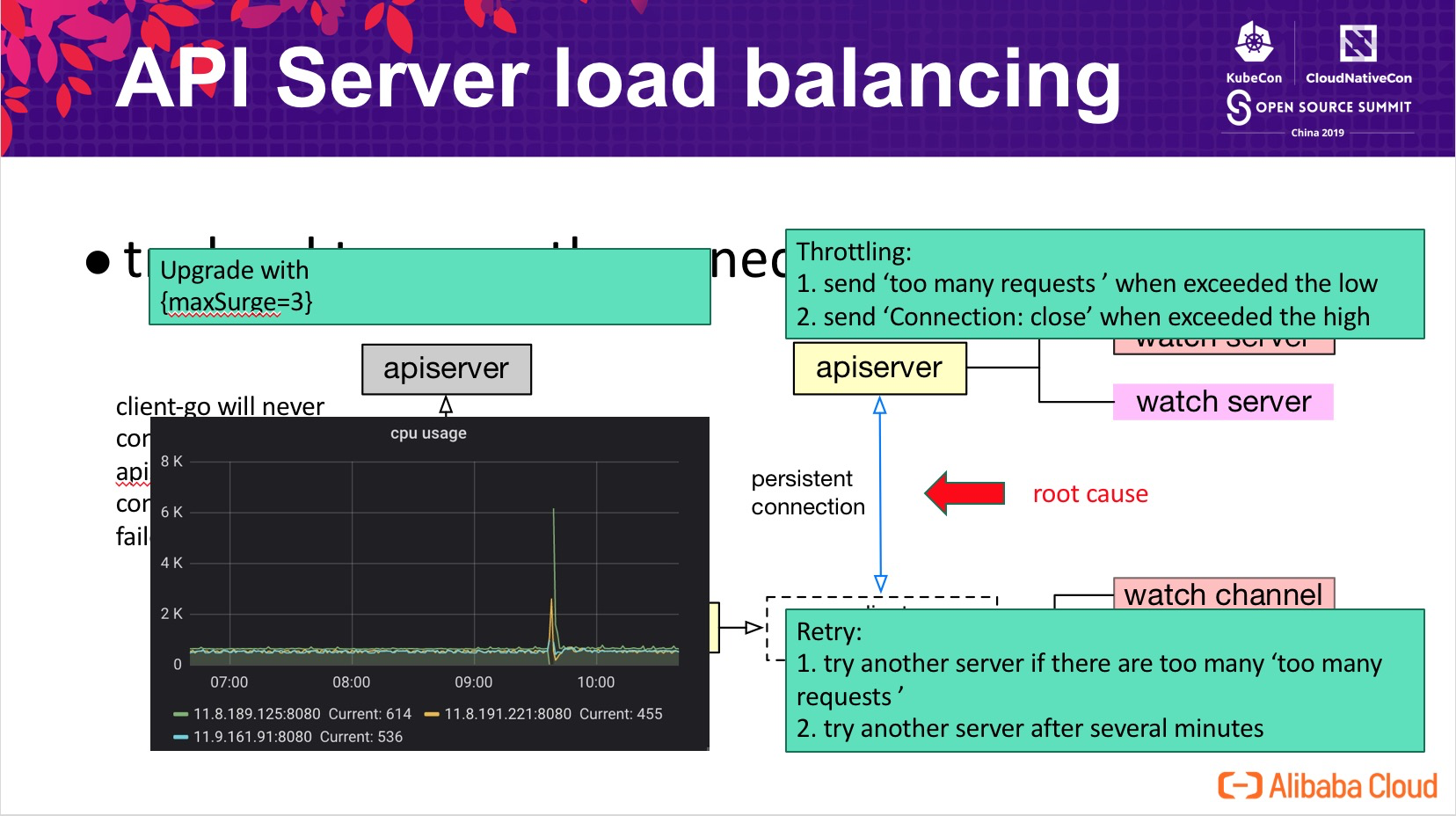

409時,嘗試重建連接切換 API Server;定期地重建連接切換 API Server 完成洗牌; - 運維層面,我們通過設置 maxSurge=3 的方式升級 API Server,避免升級過程帶來的性能抖動。

如上圖左下角監控圖所示,增強後的版本可以做到 API Server 負載基本均衡,同時在顯示重啓兩個節點(圖中抖動)時,能夠快速的自動恢復到均衡狀態。

List-Watch & Cacher

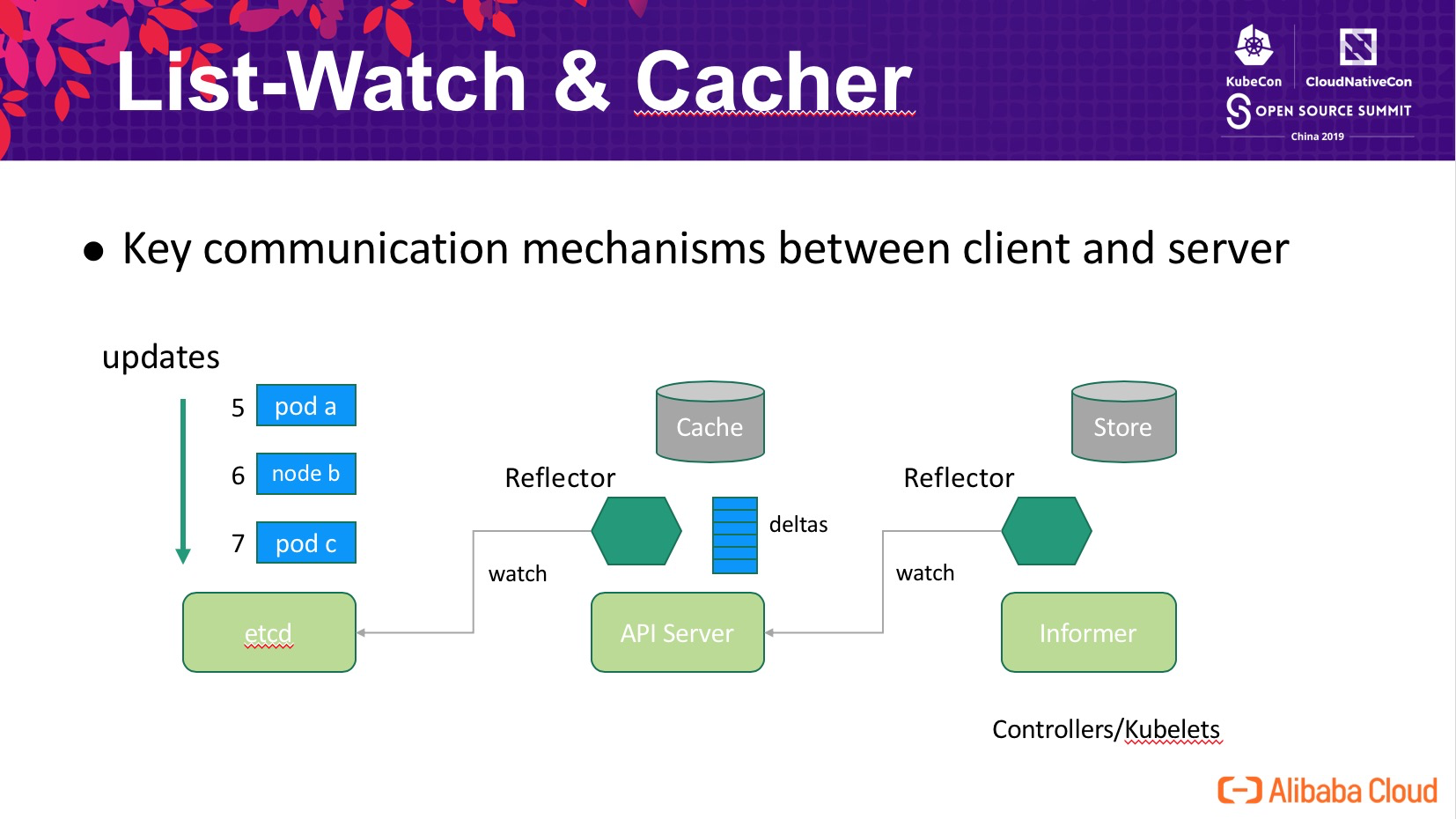

List-Watch 是 Kubernetes 中 Server 與 Client 通信最核心一個機制,etcd 中所有對象及其更新的信息,API Server 內部通過 Reflector 去 watch etcd 的數據變化並存儲到內存中,controller/kubelets 中的客戶端也通過類似的機制去訂閱數據的變化。

在 List-Watch 機制中面臨的一個核心問題是,當 Client 與 Server 之間的通信斷開時,如何確保重連期間的數據不丟,這在 Kubernetes 中通過了一個全局遞增的版本號 resourceVersion 來實現。如下圖所示 Reflector 中保存這當前已經同步到的數據版本,重連時 Reflector 告知 Server 自己當前的版本(5),Server 根據內存中記錄的最近變更歷史計算客戶端需要的數據起始位置(7)。

這一切看起來十分簡單可靠,但是...

在 API Server 內部,每個類型的對象會存儲在一個叫做 storage 的對象中,比如會有:

- Pod Storage

- Node Storage

- Configmap Storage

- ...

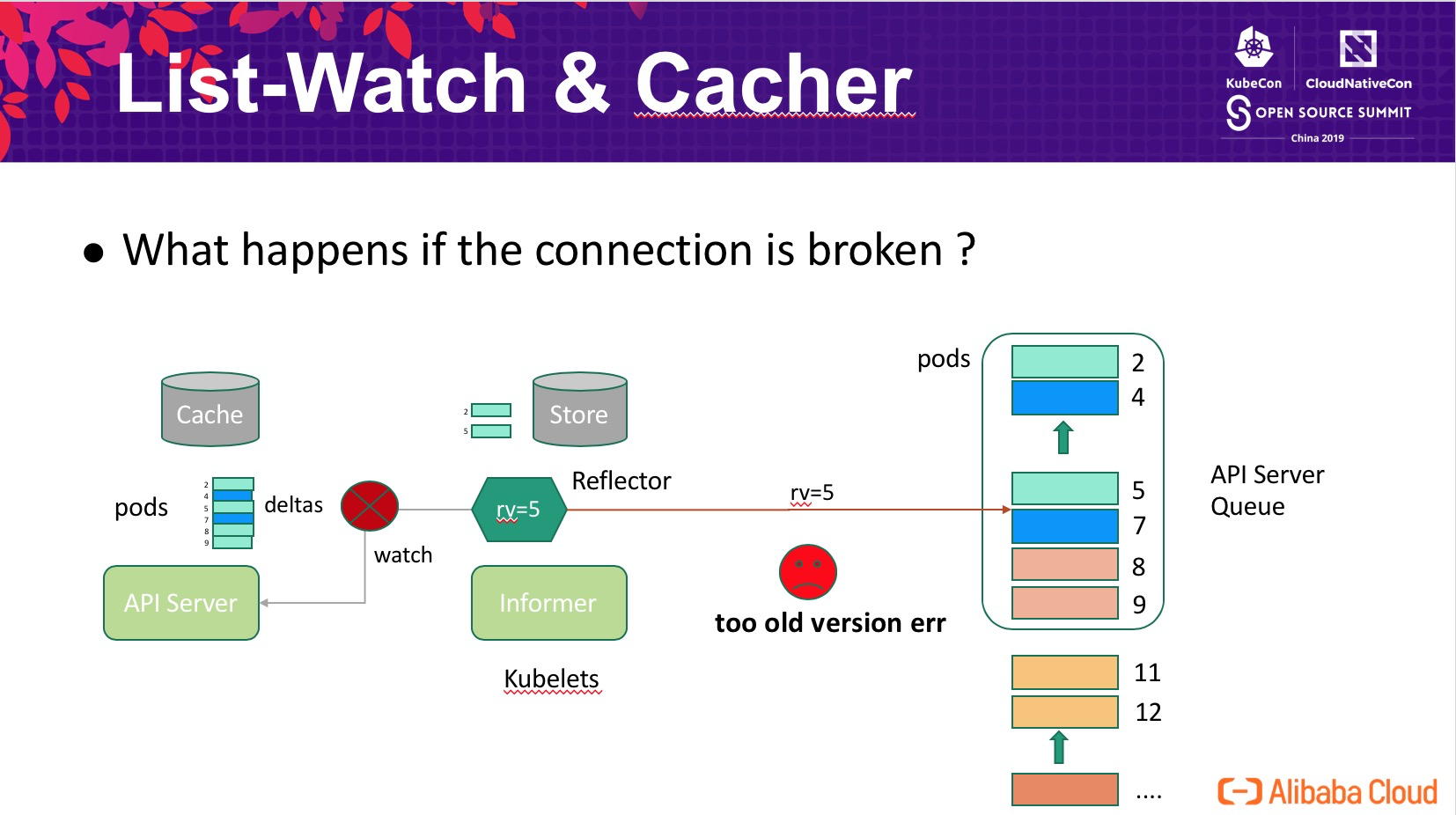

每個類型的 storage 會有一個有限的隊列,存儲對象最近的變更,用於支持 watcher 一定的滯後(重試等場景)。一般來說,所有類型的類型共享一個遞增版本號空間(1, 2, 3, ..., n),也就是如上圖所示,pod 對象的版本號僅保證遞增不保證連續。Client 使用 List-Watch 機制同步數據時,可能僅關注 pods 中的一部分,最典型的 kubelet 僅關注和自己節點相關的 pods,如上圖所示,某個 kubelet 僅關注綠色的 pods (2, 5)。

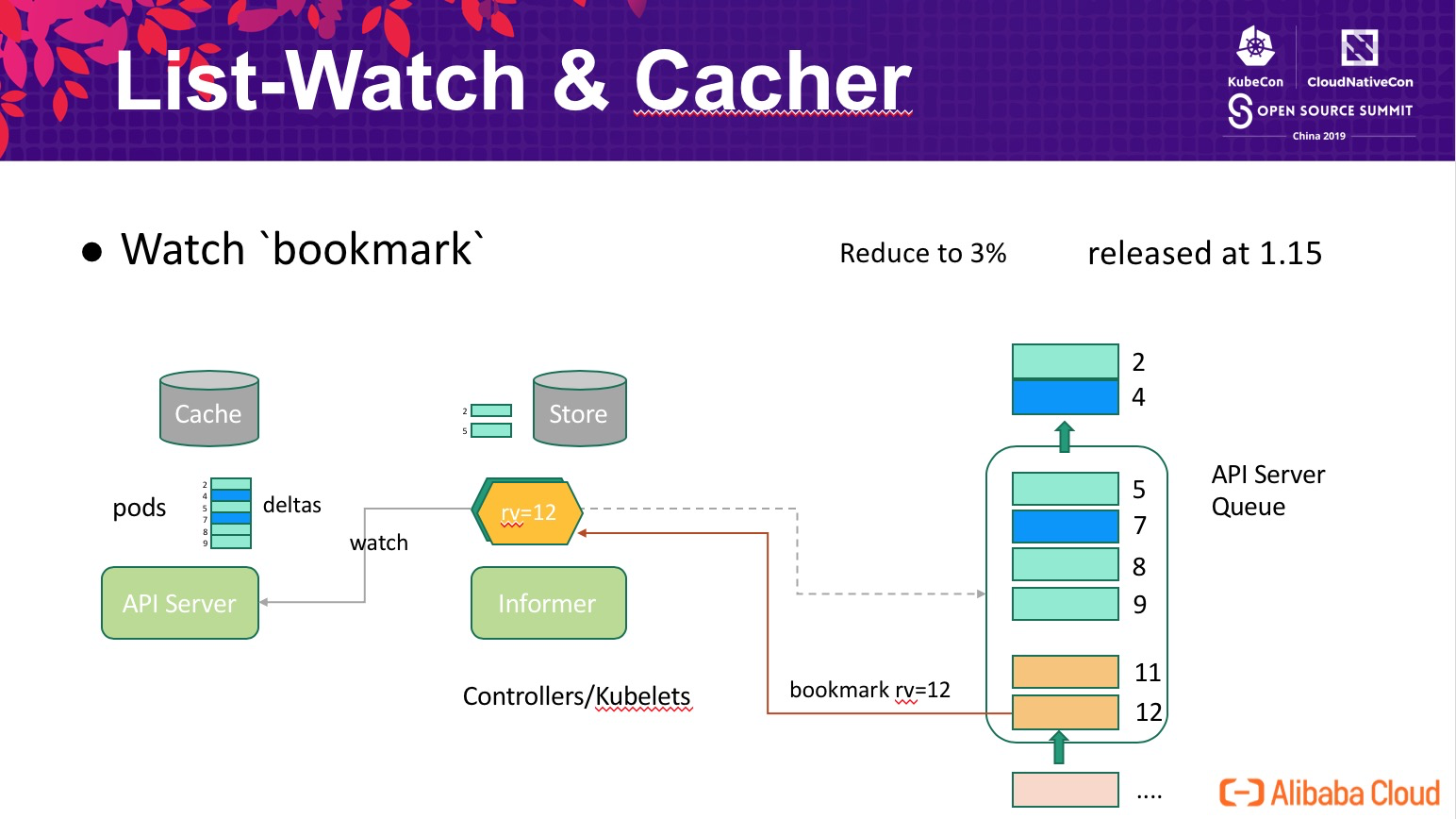

因爲 storage 隊列是有限的(FIFO),當 pods 的更新時隊列,舊的變更就會從隊列中淘汰。如上圖所示,當隊列中的更新與某個 Client 無關時,Client 進度仍然保持在 rv=5,如果 Client 在 5 被淘汰後重連,這時候 API Server 無法判斷 5 與當前隊列最小值(7)之間是否存在客戶端需要感知的變更,因此返回 Client too old version err 觸發 Client 重新 list 所有的數據。爲了解決這個問題,Kubernetes 引入 Watch bookmark 機制:

bookmark 的核心思想概括起來就是在 Client 與 Server 之間保持一個“心跳”,即使隊列中無 Client 需要感知的更新,Reflector 內部的版本號也需要及時的更新。如上圖所示,Server 會在合適的適合推送當前最新的 rv=12 版本號給 Client,使得 Client 版本號跟上 Server 的進展。bookmark 可以將 API Server 重啓時需要重新同步的事件降低爲原來的 3%(性能提高了幾十倍),該功能有阿里雲容器平臺開發,已經發布到社區 Kubernetes-1.15 版本中。

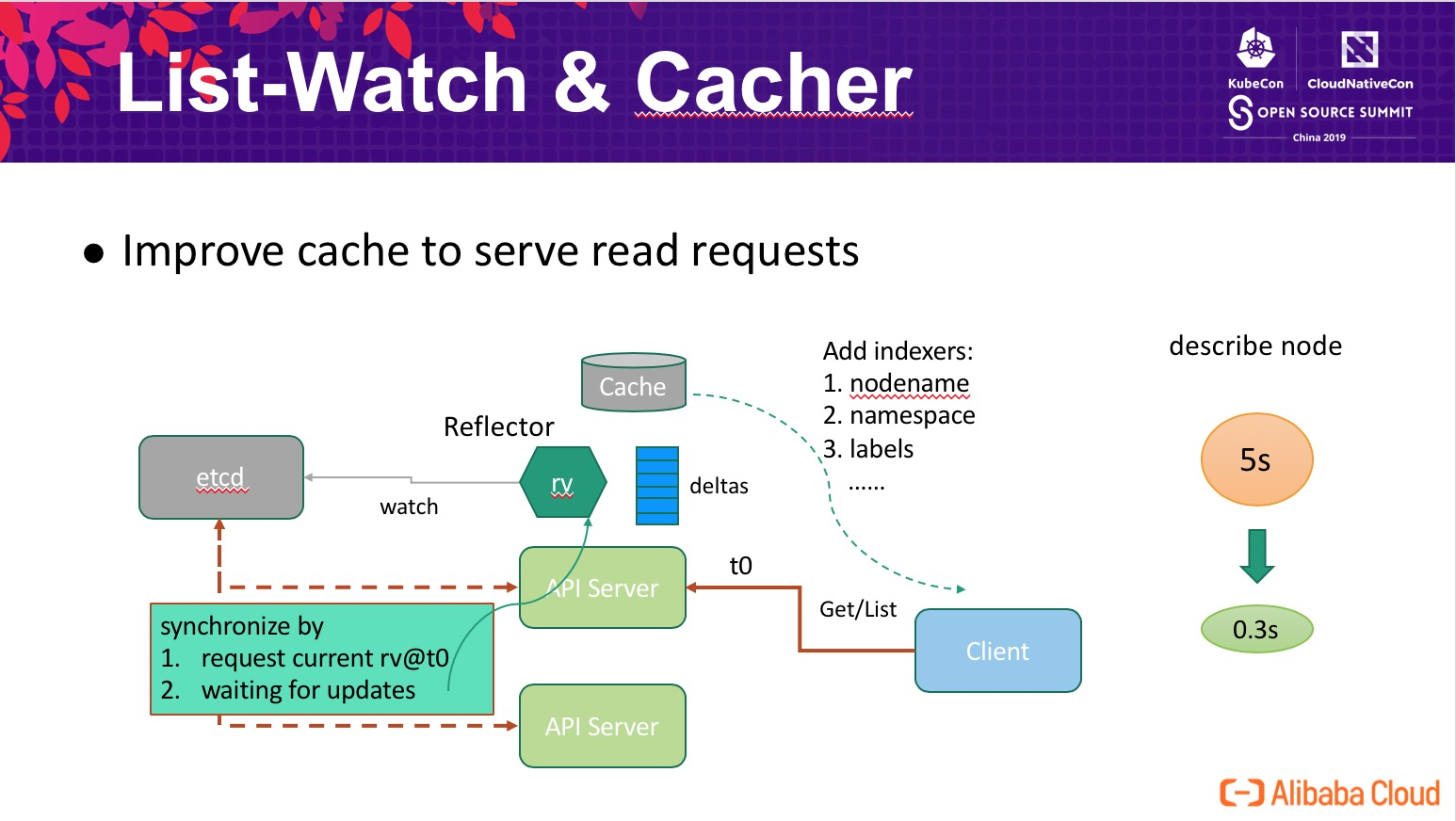

Cacher & Indexing

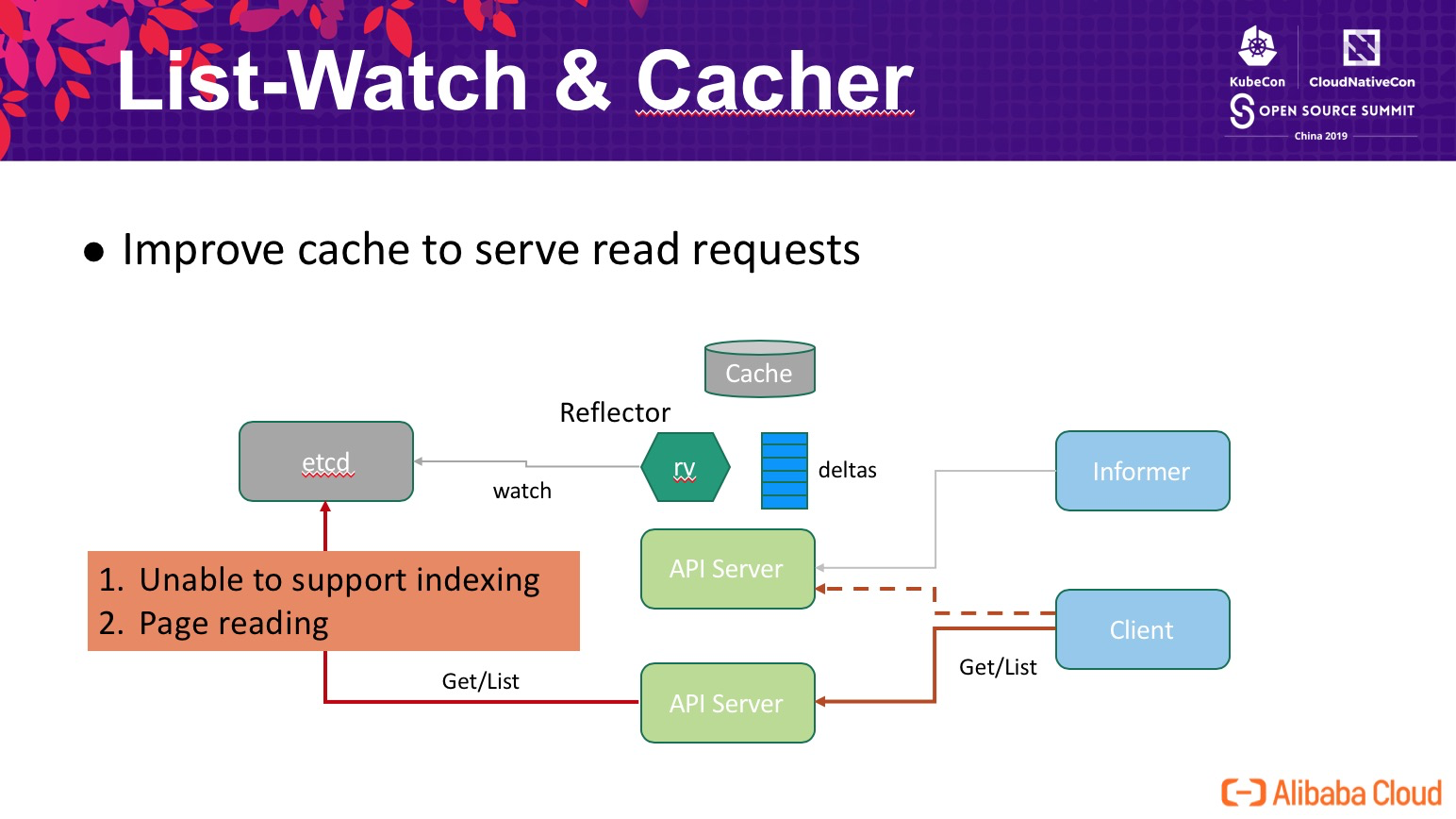

除 List-Watch 之外,另外一種客戶端的訪問模式是直接查詢 API Server,如下圖所示。爲了保證客戶端在多個 API Server 節點間讀到一致的數據,API Server 會通過獲取 etcd 中的數據來支持 Client 的查詢請求。從性能角度看,這帶來了幾個問題:

- 無法支持索引,查詢節點的 pod 需要先獲取集羣中所有的 pod,這個開銷是巨大的;

- 因爲 etcd 的 request-response 模型,單次請求查詢過大的數據會消耗大量的內存,通常情況下 API Server 與 etcd 之間的查詢會限制請求的數據量,並通過分頁的方式來完成大量的數據查詢,分頁帶來的多次的 round trip 顯著降低了性能;

- 爲了確保一致性,API Server 查詢 etcd 均採用了

Quorum read,這個查詢開銷是集羣級別,無法擴展的。

爲了解決這個問題,我們設計了 API Server 與 etcd 的數據協同機制,確保 Client 能夠通過 API Server 的 cache 獲取到一致的數據,其原理如下圖所示,整體工作流程如下:

- t0 時刻 Client 查詢 API Server;

- API Server 請求 etcd 獲取當前的數據版本 rv@t0;

- API Server 請求進度的更新,並等待 Reflector 數據版本達到 rv@t0;

- 通過 cache 響應用戶的請求。

這個方式並未打破 Client 的一致性模型(感興趣的可以自己論證一下),同時通過 cache 響應用戶請求時我們可以靈活的增強查詢能力,比如支持 namespace nodename/labels 索引。該增強大幅提高了 API Server 的讀請求處理能力,在萬臺規模集羣中典型的 describe node 的時間從原來的 5s 降低到 0.3s(觸發了 node name 索引),其他如 get nodes 等查詢操作的效率也獲得了成倍的增長。

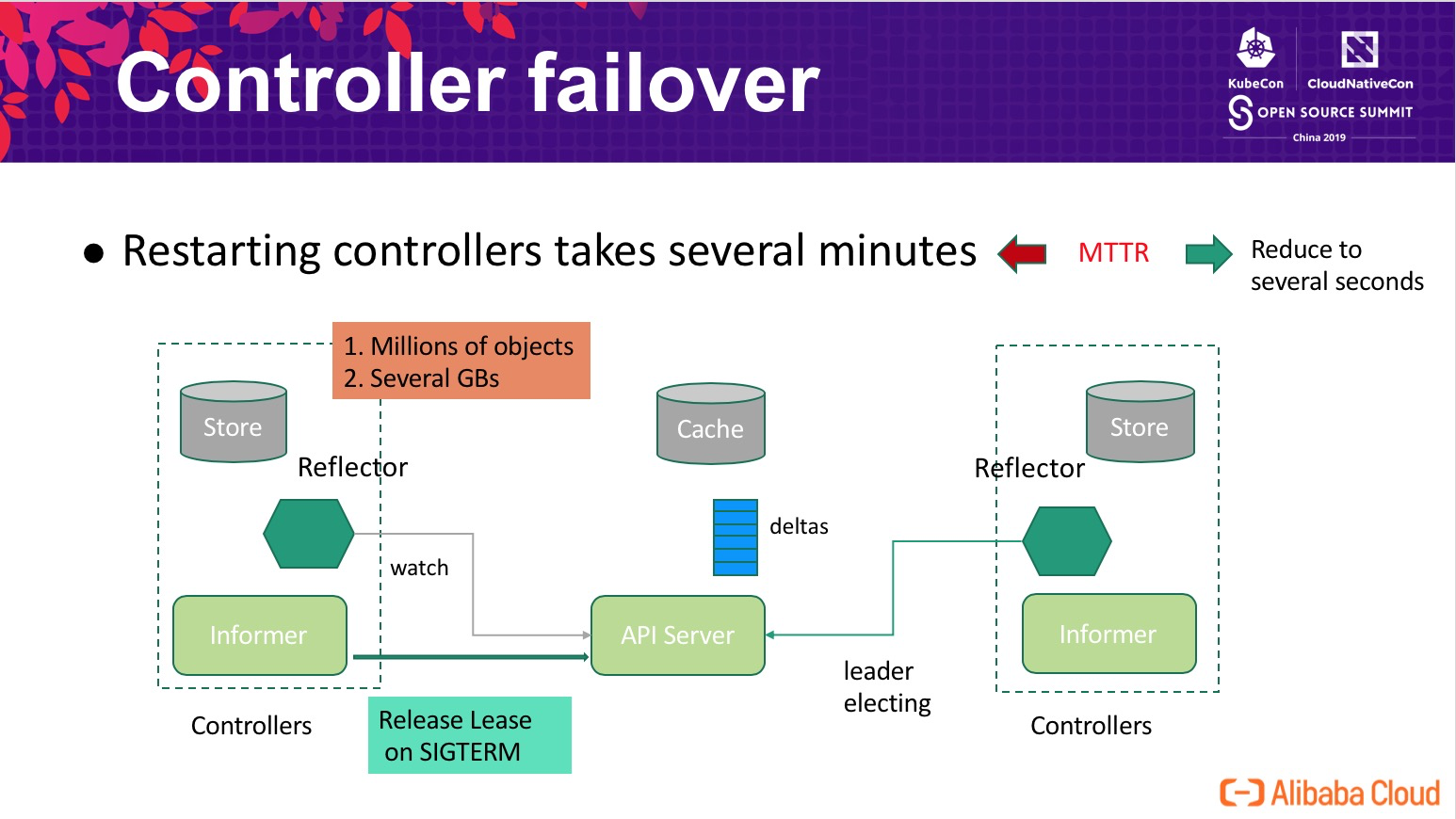

Controller failover

在 10k node 的生產集羣中,Controller 中存儲着近百萬的對象,從 API Server 獲取這些對象並反序列化的開銷是無法忽略的,重啓 Controller 恢復時可能需要花費幾分鐘才能完成這項工作,這對於阿里巴巴規模的企業來說是不可接受的。爲了減小組件升級對系統可用性的影響,我們需要儘量的減小 controller 單次升級對系統的中斷時間,這裏通過如下圖所示的方案來解決這個問題:

- 預啓動備 controller informer ,提前加載 controller 需要的數據;

- 主 controller 升級時,會主動釋放 Leader Lease,觸發備立即接管工作。

通過這個方案,我們將 controller 中斷時間降低到秒級別(升級時 < 2s),即使在異常宕機時,備僅需等待 leader lease 的過期(默認 15s),無需要花費幾分鐘重新同步數據。通過這個增強,顯著的降低了 controller MTTR,同時降低了 controller 恢復時對 API Server 的性能衝擊。該方案同樣適用於 scheduler。

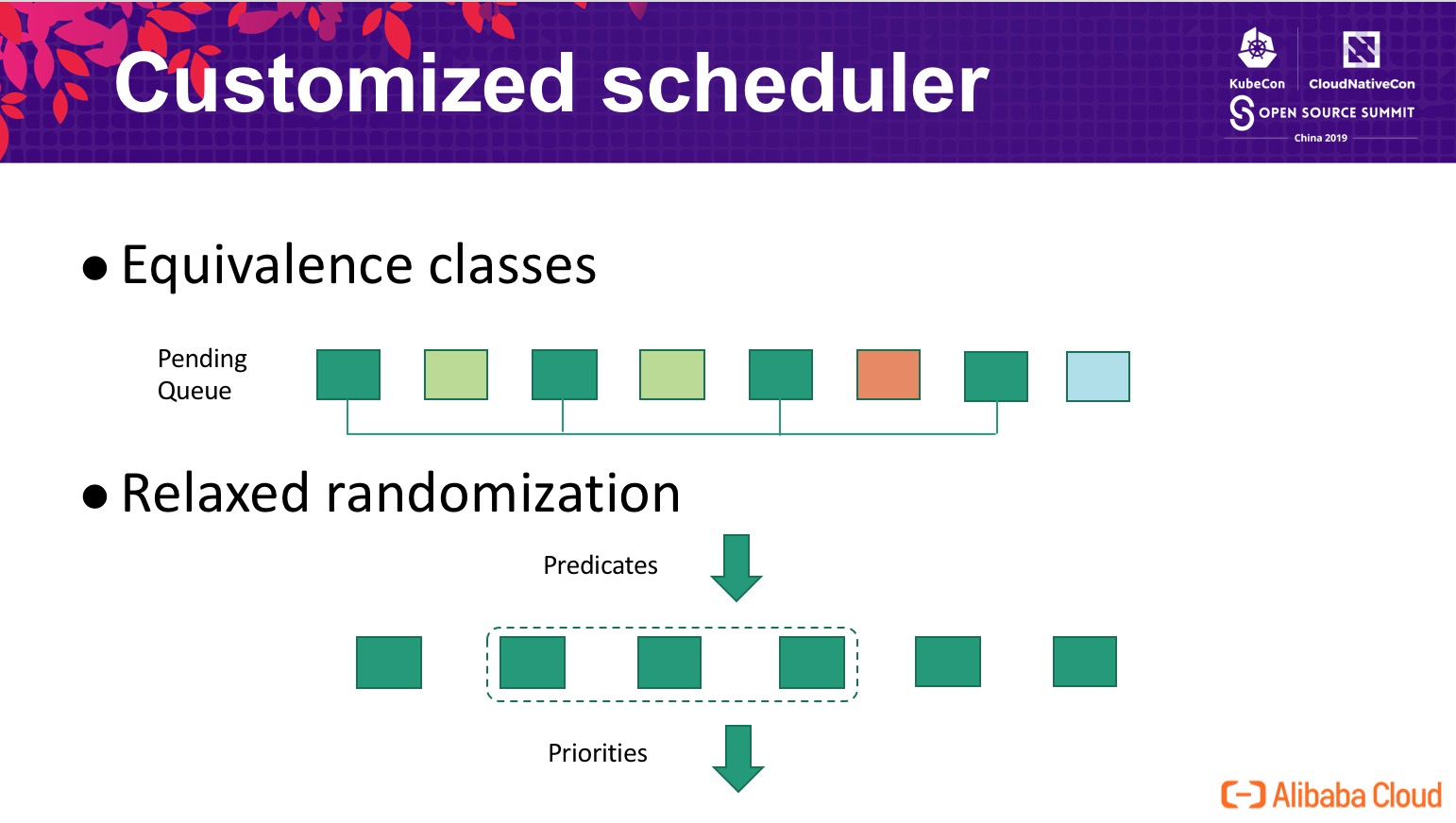

Customized scheduler

由於歷史原因,阿里巴巴的調度器採用了自研的架構,因時間的關係本次分享並未展開調度器部分的增強。這裏僅分享兩個基本的思路,如下圖所示:

- Equivalence classes:典型的用戶擴容請求爲一次擴容多個容器,因此我們通過將 pending 隊列中的請求劃分等價類的方式,實現批處理,顯著的降低 Predicates/Priorities 的次數;

- Relaxed randomization:對於單次的調度請求,當集羣中的候選節點非常多時,我們並不需要評估集羣中全部節點,在挑選到足夠的節點後即可進入調度的後續處理(通過犧牲求解的精確性來提高調度性能)。

總結

阿里巴巴通過一系列的增強與優化,成功將 Kubernetes 應用到生產環境並達到了單集羣 10000 節點的超大規模,具體包括:

- 通過將索引和數據分離、數據 shard 等方式提高 etcd 存儲容量,並最終通過改進 etcd 底層 bbolt db 存儲引擎的塊分配算法,大幅提高了 etcd 在存儲大數據量場景下的性能,通過單 etcd 集羣支持大規模 Kubernetes 集羣,大幅簡化了整個系統架構的複雜性;

- 通過落地 Kubernetes 輕量級心跳、改進 HA 集羣下多個 API Server 節點的負載均衡、ListWatch 機制中增加 bookmark、通過索引與 Cache 的方式改進了 Kubernetes 大規模集羣中最頭疼的 List 性能瓶頸,使得穩定的運行萬節點集羣成爲可能;

- 通過熱備的方式大幅縮短了 controller/scheduler 在主備切換時的服務中斷時間,提高了整個集羣的可用性;

- 阿里巴巴自研調度器在性能優化上最有效的兩個思路:等價類處理以及隨機鬆弛算法。

通過這一系列功能增強,阿里巴巴成功將內部最核心的業務運行在上萬節點的 Kubernetes 集羣之上,並經歷了 2019 年天貓 618 大促的考驗。

作者簡介:

曾凡鬆(花名:逐靈),阿里云云原生應用平臺高級技術專家。

有豐富的分佈式系統設計研發經驗。在集羣資源調度這一領域,曾負責的自研調度系統管理了數十萬規模的節點,在集羣資源調度、容器資源隔離、不同工作負載混部等方面有豐富的實踐經驗。當前主要負責 Kubernetes 在阿里內部的規模化落地,將 Kubernetes 應用於阿里內部的最核心電商業務,提高了應用發佈效率及集羣資源利用率,並穩定支撐了 2018 雙十一 及 2019 618 大促。

“ 阿里巴巴雲原生微信公衆號(ID:Alicloudnative)關注微服務、Serverless、容器、Service Mesh 等技術領域、聚焦雲原生流行技術趨勢、雲原生大規模的落地實踐,做最懂雲原生開發者的技術公衆號。”