KVM遷移

靜態遷移(冷遷移)

對於靜態遷移,你可以在宿主機上保存一個完整的客戶機鏡像快照,然後在宿主機中關閉或

者暫停該客戶機,然後將該客戶機的鏡像文件複製到另一臺宿主機中,使用在源主機中啓動該客戶

機時的命令來啓動複製過來的鏡像。

動態遷移(熱遷移)

如果源宿主機和目的宿主機共享存儲系統,則只需要通過網絡發送客戶機的 vCPU 執行狀

態、內存中的內容、虛機設備的狀態到目的主機上。否則,還需要將客戶機的磁盤存儲發到目的主

機上。共享存儲系統指的是源和目的虛機的鏡像文件目錄是在一個共享的存儲上的。

在基於共享存儲系統時,KVM 動態遷移的具體過程爲:

1、遷移開始時,客戶機依然在宿主機上運行,與此同時,客戶機的內存頁被傳輸到目的主機上。

2、QEMU/KVM 會監控並記錄下遷移過程中所有已被傳輸的內存頁的任何修改,並在所有內存頁都傳

輸完成後即開始傳輸在前面過程中內存頁的更改內容。

3、QEMU/KVM 會估計遷移過程中的傳輸速度,當剩餘的內存數據量能夠在一個可以設定的時間週期

(默認 30 毫秒)內傳輸完成時,QEMU/KVM 會關閉源宿主機上的客戶機,再將剩餘的數據量傳輸

到目的主機上,最後傳輸過來的內存內容在目的宿主機上恢復客戶機的運行狀態。

4、至此,KVM 的動態遷移操作就完成了。遷移後的客戶機儘可能與遷移前一致,除非目的主機上

缺少一些配置,比如網橋等。

注意,當客戶機中內存使用率非常大而且修改頻繁時,內存中數據不斷被修改的速度大於KVM能夠

傳輸的內存速度時,動態遷移的過程是完成不了的,這時候只能靜態遷移。

關於實時遷移的效率,業界不少人提出了改進的建議,比如通過使用內存壓縮技術,減少需要傳輸

的內存的大小

遷移注意事項:

1、最好遷移的服務器cpu品牌一樣

2、64位只能在64位宿主機間遷移,32位可以遷移32位和64位宿主機

3、宿主機中的虛擬機名字不能衝突

4、目的宿主機和源宿主機軟件配置儘可能的相同,如 有相同的橋接網卡,資源池等。

5、兩臺遷移的主機 cat /proc/cpuinfo |grep nx 的設置是相同的NX,全名爲“No eXecute”,即“禁止運行”,是應用在CPU的一種技術,用作把存儲器區域分隔爲只供存儲處理器指令集,或只供數據使用。任何使用NX技術的存儲器,代表僅供數據使用,因此處理器的指令集並不能在這些區域存儲。這種技術可防止大多數的緩衝溢出*,即一些惡意程序,把自身的惡意指令集放在其他程序的數據存儲區並運行,從而把整臺計算機控制。

靜態遷移**

1.拷貝鏡像文件和虛擬機配置文件2.重新定義此虛擬機

動態遷移:

1.創建共享存儲

2.兩臺機器掛載共享存儲(手工掛載;使用資源池)

3.啓動動態遷移

4.創建遷移後的虛擬機配置文件

5.重新定義虛擬機

1.冷遷移(靜態遷移)

test01 test02

192.168.1.12 192.168.1.13

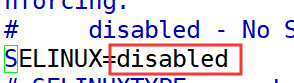

(1)兩臺虛擬機防火牆全部關閉,禁用selinux

[root@localhost ~]# systemctl stop firewalld

//關閉防火牆

[root@localhost ~]# vim /etc/selinux/config

//修改selinux狀態,需重啓linux生效

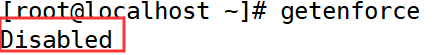

[root@localhost ~]# getenforce

Disabled //查看selinux狀態

//遷移和克隆差不多,都需要對磁盤文件和xml配置文件進行操作

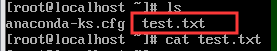

先做在虛擬機做一個測試文件一個

[root@kvm01 ~]# virsh start test01

域 test01 已開始 //先打開虛擬機

[root@localhost ~] vi xgp

Xgp666

然後虛擬機關機

Kvm01

[root@kvm01 ~]# scp /etc/libvirt/qemu/test01.xml [email protected]:/etc/libvirt/qemu/

//複製配置文件

[root@kvm01 ~]# scp /kvm-vm/centos.raw [email protected]:/kvm-vm/

Kvm02

[root@kvm02 ~]# cd /etc/libvirt/qemu/

//進入虛擬機配置文件路徑

[root@kvm02 qemu]# virsh define test01.xml

定義域 test01(從 test01.xml)

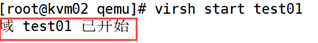

[root@kvm02 qemu]# virsh start test01

//開啓test01

驗證一下虛擬機裏是否有剛剛在kvm01創建的文件

熱遷移(動態遷移)

test01 test02 nfx

192.168.1.12 192.168.1.13 192.168.1.80

1)在nfs服務器上的操作

[root@localhost ~]# yum -y install nfs-utils

//安裝nfs工具

[root@localhost ~]# mkdir /kvmshare

//創建一個共享目錄

[root@localhost ~]# vim /etc/exports

//允許用戶名單和權限

/kvmshare *(rw,sync,no_root_squash)//可讀寫,同步到磁盤,相當於使用root權限(如果沒有這條需要有777權限)

開啓各項服務

[root@localhost ~]# systemctl start rpcbind

[root@localhost ~]# systemctl enable rpcbind

[root@localhost ~]# systemctl start nfs-server

[root@localhost ~]# systemctl enable nfs-server

[root@localhost ~]# systemctl stop firewalld

//關閉防火牆

[root@localhost ~]# setenforce 0

//禁用selinux兩臺kvm測試能否訪問到nfs

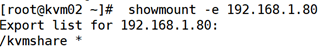

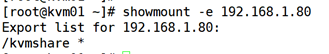

[root@kvm01 ~]# showmount -e 192.168.1.80

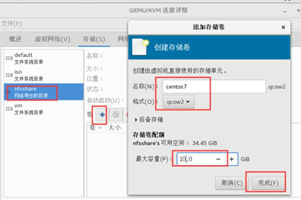

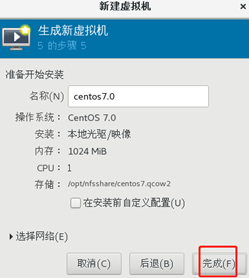

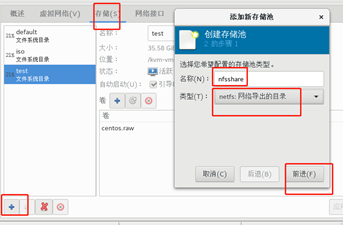

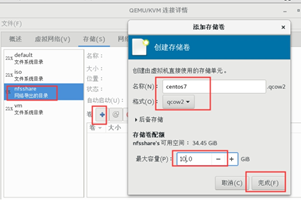

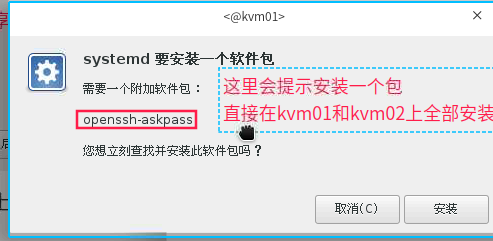

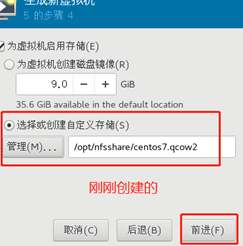

[root@kvm02 ~]# showmount -e 192.168.1.802)kvm01上基於NFS服務創建虛擬機

驗證:

1.12:

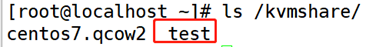

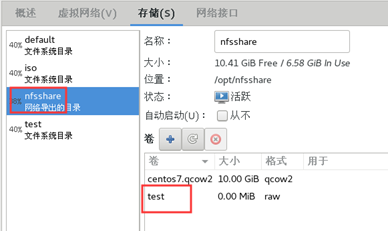

[root@localhost ~]# touch /opt/nfsshare/test

//創建一個文件

1.80:

[root@localhost ~]# ls /kvmshare/

centos7.qcow2 test //查看一下

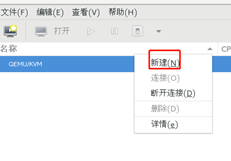

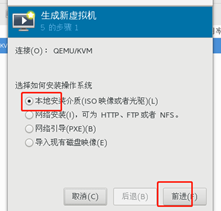

//存儲池和存儲卷完成之後,直接創建虛擬機

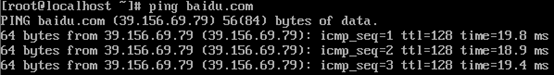

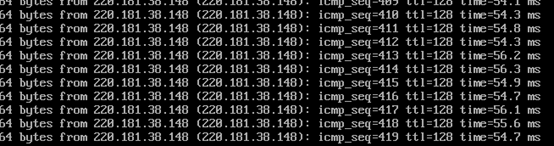

配置虛擬機使用bridge橋接網路,使其能夠ping的通外網。並且在這裏我們執行一個ping百度的命令,並讓他保持一直是ping着的狀態,用來模擬遷移到kvm02上服務不中斷。

Kvm01

然後最小化安裝一個linux

然後給這個linux設置橋接網絡

1)關閉虛擬機

[root@localhost kvm-vm]# virsh destroy centos7.0

域 test02 被刪除

2)創建虛擬橋接網考br0

[root@localhost kvm-vm]# systemctl stop NetworkManage

//關閉network管理工具關閉

[root@localhost kvm-vm]# virsh iface-bridge ens33 br0

//他會提示失敗,沒關係最後啓用就行了

使用附加設備 br0 生成橋接 ens33 失敗

已啓動橋接接口 br03)修改kvm虛擬機域的xml配置文件(定位到interface)

[root@localhost network-scripts]# virsh edit centos7.0

編輯了域 centos7.0 XML 配置。

<interface type='bridge'> #修改network

<mac address='52:54:00:75:f0:8f'/> #刪除

<source bridge='br0'/> #修改4)開啓虛擬機域,配置IP,驗證 是否能夠聯通外網

[root@localhost network-scripts]# virsh start centos7.0

域 centos7.0 已開始

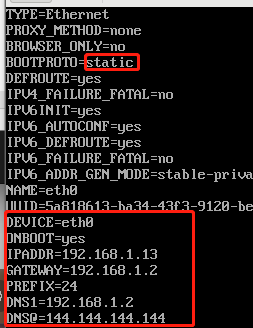

centos7.0虛擬機設置

vi /etc/sysconfig/network-scripts/ifcfg-eth0

systemctl restart network

測試ping baidu.com

配置虛擬機使用bridge橋接網絡,使其可ping通外網

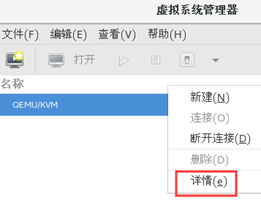

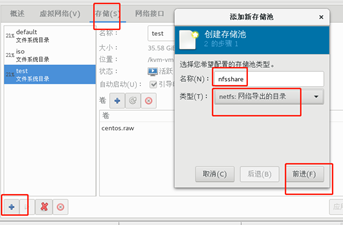

Kvm02操作,創建存儲池和kvm01一樣

這裏創建完成之後,會看到之前在kvm01.上創建的test文件和centos.qcow2

的存儲卷。

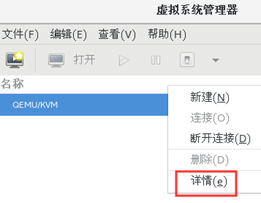

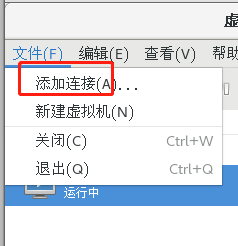

在KVM01上鍊接kvm02

//因爲kvm01上用的是bridge br0網卡,所以Kvm02 也來一個橋接網絡

1)創建虛擬橋接網考br0

[root@localhost kvm-vm]# systemctl stop NetworkManage

//關閉network管理工具關閉

[root@localhost kvm-vm]# virsh iface-bridge ens33 br0

//他會提示失敗,沒關係最後啓用就行了

使用附加設備 br0 生成橋接 ens33 失敗

已啓動橋接接口 br0

[root@kvm02 ~]# brctl show #查看一下

bridge name bridge id STP enabled interfaces

br0 8000.000c29ccc9f4 yes ens33

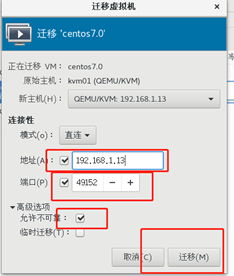

virbr0 8000.5254008b52f8 yes virbr0-nic在kvm01上遷移centos7.0

遷移之前在centos7.0裏ping baidu.com

遷移完了之後在kvm上查看一下是否還在ping

遷移完畢

常見錯誤:

1、遷移時遇到的錯誤描述:

virsh migrate centos live qemu+ssh://192.168.30.132/system

error: unable to connect to server at 'KVM2:49152': No route to host

原因:你的免密登錄沒有成功

解決方法:重新做免密登錄即可

2、遷移時的存儲錯誤:# virsh migrate centos live qemu+ssh://192.168.30.132/system

error: Failed to open file '/mnt/CentOS6.8.qcow2': Input/output error

原因:存儲沒有掛載成功

解決方法:mount o remount /dev/sdb /mnt

3、遷移時FQDN錯誤:

virsh migrate centos live qemu+ssh://192.168.30.132/system

error: internal error hostname on destination resolved to localhost, but migration requires

an FQDN

原因:兩臺宿主機無法解析主機名

解決方法:重新配置主機名和ip的解析

4、遷移時語法錯誤:

virsh migrate centos live qemu+ssh://192.168.30.132:/system

error: internal error Unable to parse URI qemu+ssh://192.168.30.132:/system

原因:qemu+ssh語法寫錯了

解 決 方 法 : 正 確 的 應 該 是 : virsh migrate centos live

qemu+ssh://192.168.30.132/system

firewall-cmd --add-port=49152/tcp

KVM性能優化

1、KVM爲什麼要調優

性能的損耗是關鍵。KVM採用全虛擬化技術,全虛擬化要有一個軟件來模擬硬件層,故有一

定的損耗,特別是I/O,因此需要優化。KVM性能優化主要在CPU、內存、I/O這幾方面。當然

對於這幾方面的優化,也是要分場景的,不同的場景其優化方向也是不同的。

2、KVM優化思路及步驟

KVM的性能已經很不錯了,但還有一些微調措施可以進一步提高KVM性能。

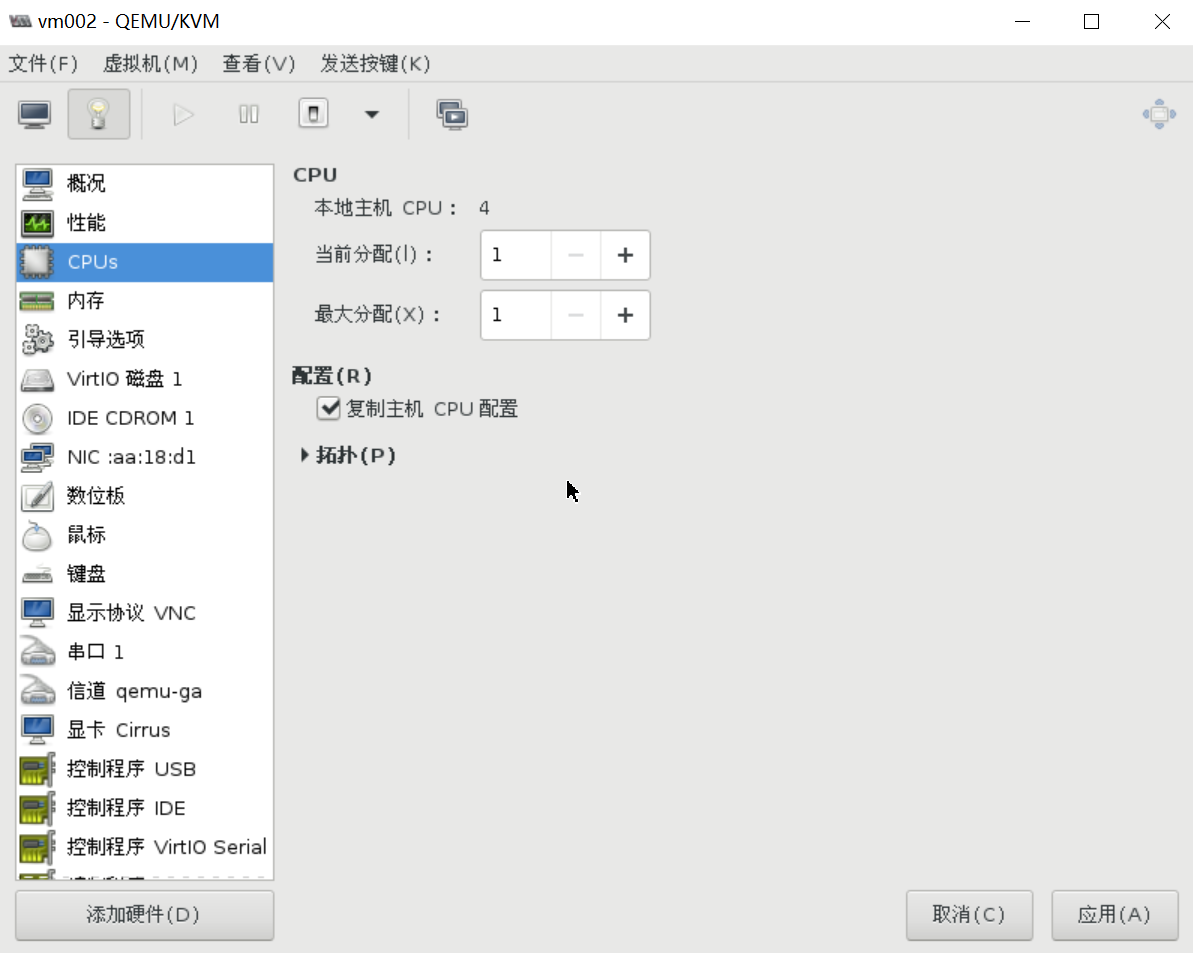

1)CPU優化

要考慮CPU的數量問題,所有guestcpu的總數目不要超過物理機CPU的總數目。如果超

過,則將對性能帶來嚴重影響,建議選擇複製主機CPU配置,如圖所示:

KSM(kernel samepage merging,相同頁合併)

內存分配的最小單位是page(頁面),默認大小是4KB。可以將host主機內容相同的內存

合併,以節省內存的使用,特別是在虛擬機操作系統都一樣的情況下,肯定會有很多內容相

同的內存值,開啓了KSM,則會將這些內存合併爲一個,當然這個過程會有性能損耗,所以

開啓與否,需要考慮使用場景。

而KSM對KVM環境有很重要的意義,當KVM上運行許多相同系統的客戶機時,客戶機之間

將有許多內存頁是完全相同的,特別是只讀的內核代碼頁完全可以在客戶機之間共享,從而

減少客戶機佔用的內存資源,能同時運行更多的客戶機。

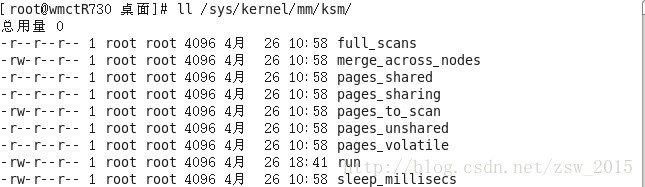

通過/sys/kernel/mm/ksm目錄下的文件可查看內存頁共享的情況:

KSM主要有兩個服務:ksm和ksmtuned。

ksm的配置文件:/sys/kernel/mm/ksm/*1

full_scans:已經對所有可合併的內存區域掃描過的次數。

pages_shared:正在使用中的共享內存頁數量

pages_sharing:有多少內存頁正在使用被合併的共享頁,不包括合併內存頁本

身。這是實際節省的內存頁數量。

pages_to_scan:在ksmd進程休眠之前會去掃描的內存頁的數量。

pages_unshared:無重複內容而不可以被合併的內存頁數量。

pages_volatile:因爲內容很容易變化而不被合併的內存頁數量。

run:控制ksmd是否運行。0:停止運行但是保存合併的內存頁;1:馬上運行

ksmd;2:停止運行,並且分立已經合併的所有內存頁。

sleep_millisecs:ksmd進程的休眠時間。

其中pages_to_scan、sleep_millisecs、run三個文件是可讀寫的,其他文件是

只讀的。

2、配置和使用ksmtuned

配置文件:/etc/ksmtuned.conf

ksmtuned會一直保持循環執行,以調節ksm服務運行。

pages_shared文件記錄了KSM共享的總頁面數;

pages_sharing文件中記錄了當前共享的頁面數。

每個頁面的大小爲4KB,可計算出共享內存爲:4 * 頁面數 = 內存大小(KB)。

查看是否開啓KSM,0是不開啓,1是開啓

[root@kvm001 ksm]# pwd

/sys/kernel/mm/ksm

[root@kvm001 ksm]# cat run

0

臨時開啓KSM,只能使用重定向,不支持用VI編輯器,可以在/etc/rc.local中添加

echo 1 > /sys/kernel/mm/ksm/run 讓KSM開機自動運行[root@kvm001 ksm]# echo 1 > run

[root@kvm001 ksm]# cat run

1

定期掃描相同頁,sleep_millisecs決定多長時間,pages_to_scan決定每次查看多少個

頁面,默認爲100,越大越好,超過2000無效,需要開啓兩個服務ksmtuned和tuned支持更多頁面

KSM會影響系統性能甚到高達10%-50%,以效率換空間,如果系統的內存很寬裕,則無

須開啓KSM,如果想儘可能多地並行運行KVM客戶機,則可以打開KSM。

對內存設置限制

如果有多個虛擬機,爲了防止某個虛擬機無節制的使用內存資源,導致其它虛擬機無法

正常使用,就需要對內存的使用進行限制。

查看當前虛擬機vm002內存的限制,單位爲KB

[root@kvm001 ksm]# virsh memtune vm002

hard_limit : 無限制

soft_limit : 無限制

swap_hard_limit: 無限制

調整內存的語法:

[root@kvm001 ksm]# virsh memtune --help

...................

OPTIONS

[--domain] <string> domain name, id or uuid

--hard-limit <number> Max memory, as scaled integer (default KiB)

--soft-limit <number> Memory during contention, as scaled integer

(default KiB)

--swap-hard-limit <number> Max memory plus swap, as scaled integer

(default KiB)

--min-guarantee <number> Min guaranteed memory, as scaled integer

(default KiB)

//保證最小內存

--config affect next boot //下次啓動生效

--live affect running domain //在線生效

--current affect current domain //只在當前生效

例如:設置vm002虛擬機強制最大內存1024M,並在線生效

[root@kvm001 ksm]# virsh memtune vm002 --hard-limit 1024000 --live大頁後端內存(Huge Page Backed Memory)

在邏輯地址向物理地址轉換時,CPU保持一個翻譯後備緩衝期TLB(Translation

Lookaside Buffer轉換檢測緩衝區),用來緩存轉換結果,而TLB容量很小,所以如果page很

小,TLB很容易就充滿,這樣就容易導致cache miss,相反page變大,TLB需要保存的緩存項

就變少,就會減少cache miss。通過爲客戶機提供大頁後端內存,就能減少客戶機消耗的內

存並提高TLB命中率,從而提高KVM性能。

Intel的x86 CPU通常使用4KB內存頁,但是經過配置,也能夠使用大頁(huge

page)

使用大頁,KVM的虛擬機的頁表將使用更少的內存,並且將提高CPU的效率。

查看大頁功能是否開啓,默認是開啓的

[root@kvm001 ksm]# cat /sys/kernel/mm/transparent_hugepage/enabled

[always] madvise never

默認情況下,大頁的數目爲0,通過下面的方式可以查看到:

[root@kvm001 ksm]# cat /proc/meminfo | grep -i hugepages

AnonHugePages: 790528 kB

HugePages_Total: 0

HugePages_Free: 0

HugePages_Rsvd: 0

HugePages_Surp: 0

設置系統的大頁數量,即大頁需要的內存頁面數,臨時生效

[root@kvm001 ksm]# echo 25000 > /proc/sys/vm/nr_hugepages

[root@kvm001 ksm]# cat /proc/meminfo | grep -i hugepages

AnonHugePages: 856064 kB

HugePages_Total: 766

HugePages_Free: 766 //現在沒有任何軟件在使用大頁

HugePages_Rsvd: 0

HugePages_Surp: 0

指定大頁需要的內存頁面數永久生效

[root@kvm001 ksm]# sysctl -w vm.nr_hugepages=25000

vm.nr_hugepages = 25000

或者在/etc/sysctl.conf中添加vm.nr_hugepages=25000來持久設定大頁文件系統

需要的內存頁面數。

注意:大頁文件系統需要的頁面數可以由客戶機需要的內存除以頁面大小大體估

算關閉虛擬機vm002

[root@kvm001 ksm]# virsh destroy vm002

setlocale: No such file or directory

Domain vm002 destroyed

編輯虛擬機的XML配置文件使用大頁來分配內存

[root@kvm001 ksm]# virsh edit vm002

<name>vm002</name>

<uuid>e144e9ba-a125-4a97-9cf1-1c571f58817a</uuid>

<memory unit='KiB'>1048576</memory>

<currentMemory unit='KiB'>1048576</currentMemory>

<memoryBacking><hugepages/></memoryBacking> //添加,使用大頁

掛載hugetlbfs文件系統

[root@kvm001 ksm]# mount -t hugetlbfs hugetlbfs /dev/hugepages/

重啓libvirtd服務

[root@kvm001 ksm]# systemctl restart libvirtd

啓動虛擬機vm002

[root@kvm001 ksm]# virsh start vm002

setlocale: No such file or directory

Domain vm002 started

[root@kvm001 ksm]# virsh list

setlocale: No such file or directory

Id Name State

1 vm002 running

查看使用情況

[root@kvm001 ksm]# cat /proc/meminfo |grep -i hugepage

AnonHugePages: 55296 kB

HugePages_Total: 1033

HugePages_Free: 513

HugePages_Rsvd: 0

HugePages_Surp: 0

Hugepagesize: 2048 kB

可以看到消耗了520個大頁(1033-513),每個頁面大小爲2M,正好是虛擬機vm002消耗

的內存。

讓系統開機自動掛載hugetlbfs文件系統,在/etc/fstab中添加:hugetlbfs /dev/hugepages hugetlbfs defaults 0 0

I/O的優化

在實際的生產環境中,爲了避免過度消耗磁盤資源而對其它的虛擬機造成影響,我

們希望每臺虛擬機對磁盤資源的消耗是可以控制的。比如多個虛擬機往硬盤中寫數據,誰可

以優先寫,就可以調整I/O的權重weight,權重越高寫入磁盤的優先級越高。

對磁盤的I/O控制有兩種方式:

1)在整體中的權重,範圍在100-1000

2)限制具體的I/O。

[root@kvm001 ~]# virsh blkiotune vm002

weight : 1000

device_weight :

device_read_iops_sec:

device_write_iops_sec:

device_read_bytes_sec:

device_write_bytes_sec:

設置權重爲500

[root@kvm001 ~]# virsh blkiotune vm002 --weight 500

[root@kvm001 ~]# virsh blkiotune vm002

weight : 500

device_weight :

device_read_iops_sec:

device_write_iops_sec:

device_read_bytes_sec:

device_write_bytes_sec:

編輯虛擬機的XML配置文件:

還可以使用blkdeviotune設置虛擬機的讀寫速度,語法如下:

[root@kvm001 ~]# virsh blkdeviotune --help

.........--total-bytes-sec <number> total throughput limit, as scaled integer

(default bytes)

--read-bytes-sec <number> read throughput limit, as scaled integer

(default bytes)

--write-bytes-sec <number> write throughput limit, as scaled integer

(default bytes)

--total-iops-sec <number> 以每秒字節數位單位的總 I/O 操作限制

--read-iops-sec <number> 以每秒字節數位單位的讀取 I/O 操作限制

--write-iops-sec <number> 以每秒字節數位單位的寫入 I/O 限制

--total-bytes-sec-max <number> total max, as scaled integer (default

bytes)

--read-bytes-sec-max <number> read max, as scaled integer (default

bytes)

--write-bytes-sec-max <number> write max, as scaled integer (default

bytes)

--total-iops-sec-max <number> total I/O operations max

--read-iops-sec-max <number> read I/O operations max

--write-iops-sec-max <number> write I/O operations max

--size-iops-sec <number> I/O size in bytes

--group-name <string> group name to share I/O quota between

multiple drives

--total-bytes-sec-max-length <number> duration in seconds to allow total

max bytes

--read-bytes-sec-max-length <number> duration in seconds to allow read

max bytes

--write-bytes-sec-max-length <number> duration in seconds to allow write max

bytes

--total-iops-sec-max-length <number> duration in seconds to allow total I/O

operations max

--read-iops-sec-max-length <number> duration in seconds to allow read I/O

operations max

--write-iops-sec-max-length <number> duration in seconds to allow write I/O

operations max

--config 影響下一次引導

--live 影響運行的域--current 影響當前域

系統調優工具tuned/tuned-adm

CentOS在6.3版本以後引入了一套新的 系統調優工具tuned/tuned-adm,其中,

tuned是服務端程序,用來監控和收集系統各個組件的數據,並依據數據提供的信息動態調

整系統設置,達到動態優化系統的目的;tuned-adm是客戶端程序,用來和tuned打交

道,用命令行的方式管理和配置tuned,tuned-adm提供了一些預先配置的優化方案可供

直接使用。當然不同的系統和應用場景有不同的優化方案,tuned-adm預先配置的優化策

略不是總能滿足要求,這時候就需要定製,tuned-adm允許用戶自己創建和定製新的調優

方案。

安裝tuned工具

[root@kvm001 ~]# yum install tuned -y

開機啓動並開啓tuned服務

[root@kvm001 ~]# systemctl start tuned

[root@kvm001 ~]# systemctl enable tuned

[root@kvm001 ~]# systemctl status tuned

● tuned.service - Dynamic System Tuning Daemon

Loaded: loaded (/usr/lib/systemd/system/tuned.service; enabled; vendor

preset: enabled)

Active: active (running) since 二 2017-10-17 08:36:52 CST; 5h 56min ago

Main PID: 1332 (tuned)

CGroup: /system.slice/tuned.service

└─

1332 /usr/bin/python -Es /usr/sbin/tuned -l -P

10月 17 08:36:52 kvm001 systemd[1]: Starting Dynamic System Tuning

Daemon...

10月 17 08:36:52 kvm001 systemd[1]: Started Dynamic System Tuning

Daemon.

查看當前優化方案

[root@kvm001 ~]# tuned-adm active

Current active profile: virtual-guest

查看預先設定好的優化方案

[root@kvm001 ~]# tuned-adm list

Available profiles:

- balanced - General non-specialized tuned profile

- desktop - Optmize for the desktop use-case- latency-performance - Optimize for deterministic performance at

the cost of increased power consumption \延遲性能調試的服務器配置,以提高功耗

爲代價優化確定性性能 - network-latency - Optimize for deterministic performance at the

cost of increased power consumption, focused on low latency network

performance - network-throughput - Optimize for streaming network throughput.

Generally only necessary on older CPUs or 40G+ networks. - powersave - Optimize for low power consumption

- throughput-performance - Broadly applicable tuning that provides

excellent performance across a variety of common server workloads. This is the

default profile for RHEL7.

//吞吐性能調整的服務器profile。如果系統沒有企業級存儲,則建議使用這個

profile - virtual-guest - Optimize for running inside a virtual guest.

\企業級服務器配置中使用這個profile,其中包括電池備份控制程序、緩存保護

及管理磁盤緩存 - virtual-host - Optimize for running KVM guests

\根據enterprise-storage配置,virtual-host還可減少可置換的虛擬內存,並啓

用更多集合髒頁寫回。同時推薦在虛擬化主機中使用這個配置,包括KVM和紅帽企業版

linux虛擬化主機

Current active profile: virtual-guest

修改優化方案爲virtual-host

[root@kvm001 ~]# tuned-adm profile virtual-host

[root@kvm001 ~]# tuned-adm active

Current active profile: virtual-host

如果預定的方案不是總能滿足要求,用戶可以爲自己的需求定製自己的優化方案。

自己定製很容易,只需切換到優化方案的配置目錄:/usr/lib/tuned/,不同的profile以目錄

的形式存在,拷貝其中一個例子,然後編輯裏面的相關參數就可以了,使用tuned-adm list

命令就能看到新創建的方案。

[root@kvm001 tuned]# pwd

/usr/lib/tuned

[root@kvm001 tuned]# cp -r virtual-host/ my-server

[root@kvm001 tuned]# lsbalanced functions my-server network-throughput

recommend.conf virtual-guest

desktop latency-performance network-latency powersave

throughput-performance virtual-host

編輯my-server目錄中的文件添加調優參數即可:

[root@kvm001 tuned]# tuned-adm list

Available profiles: - balanced - General non-specialized tuned profile

- desktop - Optmize for the desktop use-case

- latency-performance - Optimize for deterministic performance at

the cost of increased power consumption - my-server - Optimize for running KVM guests

- network-latency - Optimize for deterministic performance at the

cost of increased power consumption, focused on low latency network

performance - network-throughput - Optimize for streaming network throughput.

Generally only necessary on older CPUs or 40G+ networks. - powersave - Optimize for low power consumption

- throughput-performance - Broadly applicable tuning that provides

excellent performance across a variety of common server workloads. This is the

default profile for RHEL7. - virtual-guest - Optimize for running inside a virtual guest.

- virtual-host - Optimize for running KVM guests

Current active profile: virtual-host