1、Knime Analytics 安裝

從官方網站下載合適的版本 https://www.knime.com/downloads

將下載的安裝包在安裝路徑解壓 https://www.knime.com/installation-0

下圖是knime啓動後的歡迎頁面

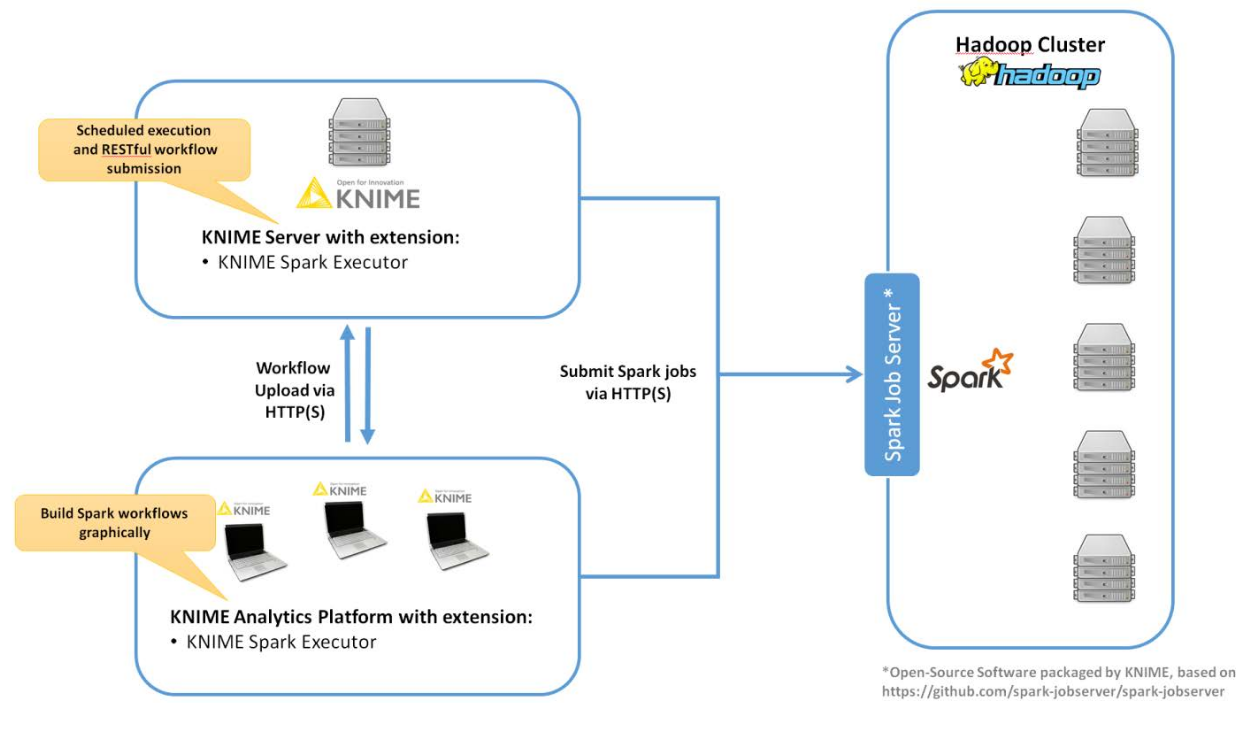

要與spark集×××互,需要在Knime中安裝KNIME® Extension for Apache Spark。並在Hadoop集羣邊界節點或能夠執行spark-submit的節點安裝Spark Job Server。架構圖如下:

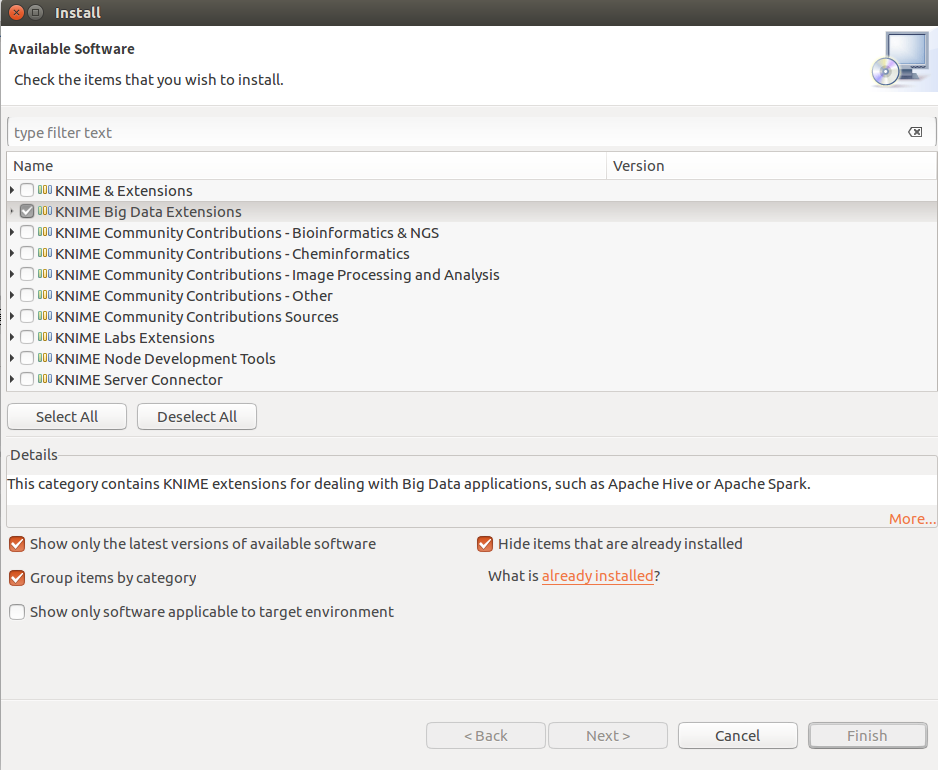

2、KNIME® Extension for Apache Spark 安裝

在KNIME Analytics 中點擊File->Install KNIME extensions選中KNIME Big Data Extensions,點擊Next安裝。

3、SPARK JOB SERVER安裝

以下步驟以Centos 6.5 + CDH 5.7 爲例

3.1 下載spark job server

$ wget http://download.knime.org/store/3.5/spark-job-server-0.6.2.3-KNIME_cdh-5.7.tar.gz

3.2 login as root or su root

3.3 安裝

3.4 開機啓動

3.5 編輯environment.conf

設置master,例如

master = "spark://ifrebdplatform1:7077"

設置Default settings for Spark contexts: context-settings

3.6 編輯設置settings.sh

設置SPARK_HOME,本例默認正確,不做改變

設置LOG_DIR,如果不用默認設置的目錄的話

3.7 根據喜好編輯log4j-server.properties

3.8 啓動spark job server

/etc/init.d/${LINKNAME} start

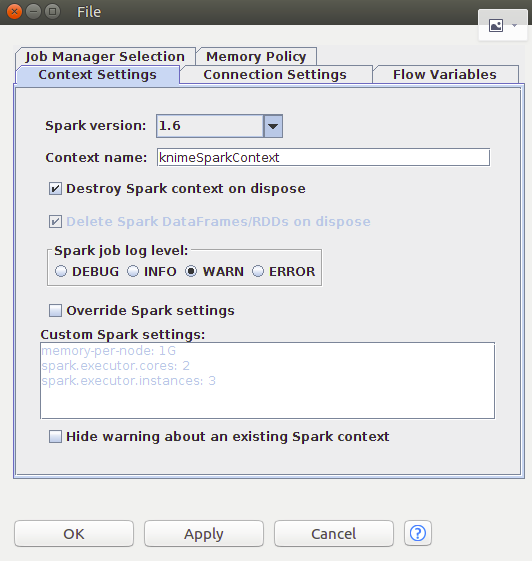

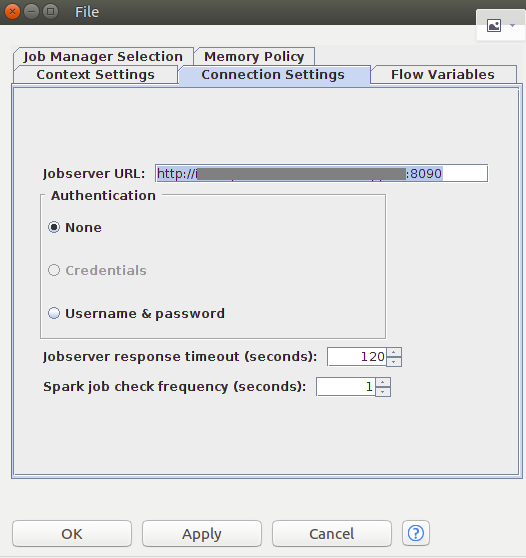

3.9 在knime 添加create spark context 節點測試鏈接

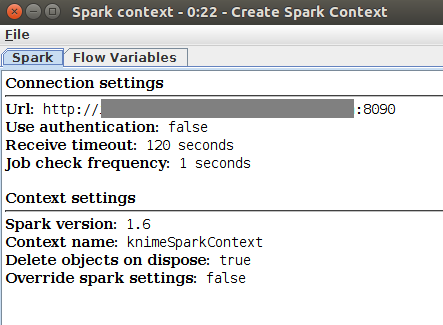

右擊create spark context 節點,點擊Execute執行

右擊create spark context 節點,點擊Spark Context,查看結果

未完待續......