original link:http://blog.fens.me/hadoop-mahout-maven-eclipse/

用Maven構建Mahout項目

Hadoop家族系列文章,主要介紹Hadoop家族產品,常用的項目包括Hadoop, Hive, Pig, HBase, Sqoop, Mahout, Zookeeper, Avro, Ambari, Chukwa,新增加的項目包括,YARN, Hcatalog, Oozie, Cassandra, Hama, Whirr, Flume, Bigtop, Crunch, Hue等。

從2011年開始,中國進入大數據風起雲涌的時代,以Hadoop爲代表的家族軟件,佔據了大數據處理的廣闊地盤。開源界及廠商,所有數據軟件,無一不向Hadoop靠攏。Hadoop也從小衆的高富帥領域,變成了大數據開發的標準。在Hadoop原有技術基礎之上,出現了Hadoop家族產品,通過“大數據”概念不斷創新,推出科技進步。

作爲IT界的開發人員,我們也要跟上節奏,抓住機遇,跟着Hadoop一起雄起!

前言

基於Hadoop的項目,不管是MapReduce開發,還是Mahout的開發都是在一個複雜的編程環境中開發。Java的環境問題,是困擾着每個程序員的噩夢。Java程序員,不僅要會寫Java程序,還要會調linux,會配hadoop,啓動hadoop,還要會自己運維。所以,新手想玩起Hadoop真不是件簡單的事。

不過,我們可以儘可能的簡化環境問題,讓程序員只關注於寫程序。特別是像算法程序員,把精力投入在算法設計上,要比花時間解決環境問題有價值的多。

目錄

Maven介紹和安裝

Mahout單機開發環境介紹

用Maven構建Mahout開發環境

用Mahout實現協同過濾userCF

用Mahout實現kmeans

模板項目上傳github

1. Maven介紹和安裝

請參考文章:用Maven構建Hadoop項目

開發環境

Win7 64bit

Java 1.6.0_45

Maven 3

Eclipse Juno Service Release 2

Mahout 0.6

這裏要說明一下mahout的運行版本。

mahout-0.5, mahout-0.6, mahout-0.7,是基於hadoop-0.20.2x的。

mahout-0.8, mahout-0.9,是基於hadoop-1.1.x的。

mahout-0.7,有一次重大升級,去掉了多個算法的單機內存運行,並且了部分API不向前兼容。

注:本文關注於“用Maven構建Mahout的開發環境”,文中的 2個例子都是基於單機的內存實現,因此選擇0.6版本。Mahout在Hadoop集羣中運行會在下一篇文章介紹。

2. Mahout單機開發環境介紹

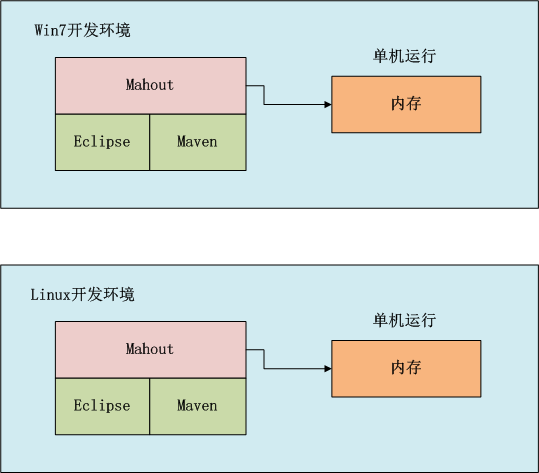

如上圖所示,我們可以選擇在win中開發,也可以在linux中開發,開發過程我們可以在本地環境進行調試,標配的工具都是Maven和Eclipse。

3. 用Maven構建Mahout開發環境

1. 用Maven創建一個標準化的Java項目

2. 導入項目到eclipse

3. 增加mahout依賴,修改pom.xml

4. 下載依賴

1). 用Maven創建一個標準化的Java項目

~ D:\workspace\java>mvn archetype:generate -DarchetypeGroupId=org.apache.maven.archetypes -DgroupId=org.conan.mymahout -DartifactId=myMahout -DpackageName=org.conan.mymahout -Dversion=1.0-SNAPSHOT -DinteractiveMode=false

進入項目,執行mvn命令

~ D:\workspace\java>cd myMahout ~ D:\workspace\java\myMahout>mvn clean install

2). 導入項目到eclipse

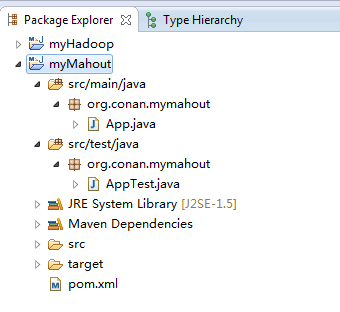

我們創建好了一個基本的maven項目,然後導入到eclipse中。 這裏我們最好已安裝好了Maven的插件。

3). 增加mahout依賴,修改pom.xml

這裏我使用hadoop-0.6版本,同時去掉對junit的依賴,修改文件:pom.xml

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/maven-v4_0_0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>org.conan.mymahout</groupId>

<artifactId>myMahout</artifactId>

<packaging>jar</packaging>

<version>1.0-SNAPSHOT</version>

<name>myMahout</name>

<url>http://maven.apache.org</url>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<mahout.version>0.6</mahout.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.mahout</groupId>

<artifactId>mahout-core</artifactId>

<version>${mahout.version}</version>

</dependency>

<dependency>

<groupId>org.apache.mahout</groupId>

<artifactId>mahout-integration</artifactId>

<version>${mahout.version}</version>

<exclusions>

<exclusion>

<groupId>org.mortbay.jetty</groupId>

<artifactId>jetty</artifactId>

</exclusion>

<exclusion>

<groupId>org.apache.cassandra</groupId>

<artifactId>cassandra-all</artifactId>

</exclusion>

<exclusion>

<groupId>me.prettyprint</groupId>

<artifactId>hector-core</artifactId>

</exclusion>

</exclusions>

</dependency>

</dependencies>

</project>4). 下載依賴

~ mvn clean install

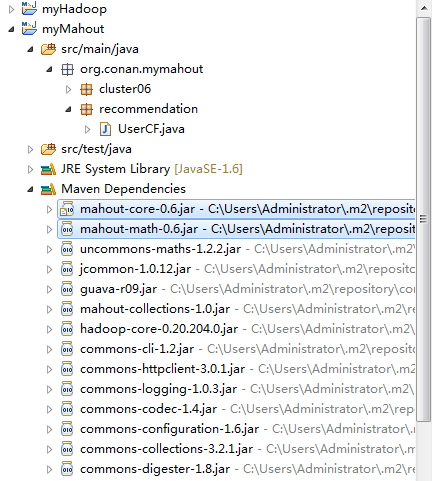

在eclipse中刷新項目:

項目的依賴程序,被自動加載的庫路徑下面。

4. 用Mahout實現協同過濾userCF

Mahout協同過濾UserCF深度算法剖析,請參考文章:用R解析Mahout用戶推薦協同過濾算法(UserCF)

實現步驟:

1. 準備數據文件: item.csv

2. Java程序:UserCF.java

3. 運行程序

4. 推薦結果解讀

1). 新建數據文件: item.csv

~ mkdir datafile ~ vi datafile/item.csv 1,101,5.0 1,102,3.0 1,103,2.5 2,101,2.0 2,102,2.5 2,103,5.0 2,104,2.0 3,101,2.5 3,104,4.0 3,105,4.5 3,107,5.0 4,101,5.0 4,103,3.0 4,104,4.5 4,106,4.0 5,101,4.0 5,102,3.0 5,103,2.0 5,104,4.0 5,105,3.5 5,106,4.0

數據解釋:每一行有三列,第一列是用戶ID,第二列是物品ID,第三列是用戶對物品的打分。

2). Java程序:UserCF.java

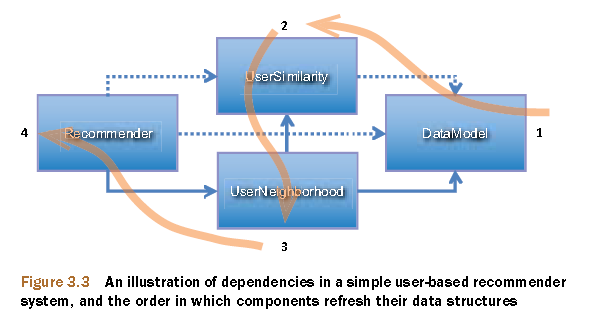

Mahout協同過濾的數據流,調用過程。

上圖摘自:Mahout in Action

新建JAVA類:org.conan.mymahout.recommendation.UserCF.java

package org.conan.mymahout.recommendation;

import java.io.File;

import java.io.IOException;

import java.util.List;

import org.apache.mahout.cf.taste.common.TasteException;

import org.apache.mahout.cf.taste.impl.common.LongPrimitiveIterator;

import org.apache.mahout.cf.taste.impl.model.file.FileDataModel;

import org.apache.mahout.cf.taste.impl.neighborhood.NearestNUserNeighborhood;

import org.apache.mahout.cf.taste.impl.recommender.GenericUserBasedRecommender;

import org.apache.mahout.cf.taste.impl.similarity.EuclideanDistanceSimilarity;

import org.apache.mahout.cf.taste.model.DataModel;

import org.apache.mahout.cf.taste.recommender.RecommendedItem;

import org.apache.mahout.cf.taste.recommender.Recommender;

import org.apache.mahout.cf.taste.similarity.UserSimilarity;

public class UserCF {

final static int NEIGHBORHOOD_NUM = 2;

final static int RECOMMENDER_NUM = 3;

public static void main(String[] args) throws IOException, TasteException {

String file = "datafile/item.csv";

DataModel model = new FileDataModel(new File(file));

UserSimilarity user = new EuclideanDistanceSimilarity(model);

NearestNUserNeighborhood neighbor = new NearestNUserNeighborhood(NEIGHBORHOOD_NUM, user, model);

Recommender r = new GenericUserBasedRecommender(model, neighbor, user);

LongPrimitiveIterator iter = model.getUserIDs();

while (iter.hasNext()) {

long uid = iter.nextLong();

List list = r.recommend(uid, RECOMMENDER_NUM);

System.out.printf("uid:%s", uid);

for (RecommendedItem ritem : list) {

System.out.printf("(%s,%f)", ritem.getItemID(), ritem.getValue());

}

System.out.println();

}

}

}3). 運行程序

控制檯輸出:

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder". SLF4J: Defaulting to no-operation (NOP) logger implementation SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details. uid:1(104,4.274336)(106,4.000000) uid:2(105,4.055916) uid:3(103,3.360987)(102,2.773169) uid:4(102,3.000000) uid:5

4). 推薦結果解讀

向用戶ID1,推薦前二個最相關的物品, 104和106

向用戶ID2,推薦前二個最相關的物品, 但只有一個105

向用戶ID3,推薦前二個最相關的物品, 103和102

向用戶ID4,推薦前二個最相關的物品, 但只有一個102

向用戶ID5,推薦前二個最相關的物品, 沒有符合的

5. 用Mahout實現kmeans

1. 準備數據文件: randomData.csv

2. Java程序:Kmeans.java

3. 運行Java程序

4. mahout結果解讀

5. 用R語言實現Kmeans算法

6. 比較Mahout和R的結果

1). 準備數據文件: randomData.csv

~ vi datafile/randomData.csv -0.883033363823402,-3.31967192630249 -2.39312626419456,3.34726861118871 2.66976353341256,1.85144276077058 -1.09922906899594,-6.06261735207489 -4.36361936997216,1.90509905380532 -0.00351835125495037,-0.610105996559153 -2.9962958796338,-3.60959839525735 -3.27529418132066,0.0230099799641799 2.17665594420569,6.77290756817957 -2.47862038335637,2.53431833167278 5.53654901906814,2.65089785582474 5.66257474538338,6.86783609641077 -0.558946883114376,1.22332819416237 5.11728525486132,3.74663871584768 1.91240516693351,2.95874731384062 -2.49747101306535,2.05006504756875 3.98781883213459,1.00780938946366

這裏只截取了一部分,更多的數據請查看源代碼。

注:我是通過R語言生成的randomData.csv

x1<-cbind(x=rnorm(400,1,3),y=rnorm(400,1,3)) x2<-cbind(x=rnorm(300,1,0.5),y=rnorm(300,0,0.5)) x3<-cbind(x=rnorm(300,0,0.1),y=rnorm(300,2,0.2)) x<-rbind(x1,x2,x3) write.table(x,file="randomData.csv",sep=",",row.names=FALSE,col.names=FALSE)

2). Java程序:Kmeans.java

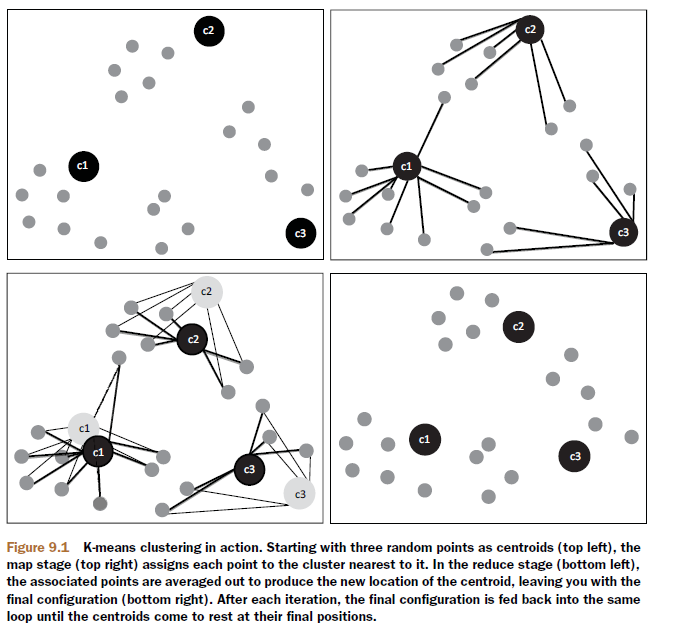

Mahout中kmeans方法的算法實現過程。

上圖摘自:Mahout in Action

新建JAVA類:org.conan.mymahout.cluster06.Kmeans.java

package org.conan.mymahout.cluster06;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

import org.apache.mahout.clustering.kmeans.Cluster;

import org.apache.mahout.clustering.kmeans.KMeansClusterer;

import org.apache.mahout.common.distance.EuclideanDistanceMeasure;

import org.apache.mahout.math.Vector;

public class Kmeans {

public static void main(String[] args) throws IOException {

List sampleData = MathUtil.readFileToVector("datafile/randomData.csv");

int k = 3;

double threshold = 0.01;

List randomPoints = MathUtil.chooseRandomPoints(sampleData, k);

for (Vector vector : randomPoints) {

System.out.println("Init Point center: " + vector);

}

List clusters = new ArrayList();

for (int i = 0; i < k; i++) {

clusters.add(new Cluster(randomPoints.get(i), i, new EuclideanDistanceMeasure()));

}

List<List> finalClusters = KMeansClusterer.clusterPoints(sampleData, clusters, new EuclideanDistanceMeasure(), k, threshold);

for (Cluster cluster : finalClusters.get(finalClusters.size() - 1)) {

System.out.println("Cluster id: " + cluster.getId() + " center: " + cluster.getCenter().asFormatString());

}

}

}3). 運行Java程序

控制檯輸出:

Init Point center: {0:-0.162693685149196,1:2.19951550286862}

Init Point center: {0:-0.0409782183083317,1:2.09376666042057}

Init Point center: {0:0.158401778474687,1:2.37208412905273}

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder".

SLF4J: Defaulting to no-operation (NOP) logger implementation

SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details.

Cluster id: 0 center: {0:-2.686856800552941,1:1.8939462954763795}

Cluster id: 1 center: {0:0.6334255423230666,1:0.49472852972602105}

Cluster id: 2 center: {0:3.334520309711998,1:3.2758355898247653}4). mahout結果解讀

1. Init Point center表示,kmeans算法初始時的設置的3箇中心點

2. Cluster center表示,聚類後找到3箇中心點

5). 用R語言實現Kmeans算法

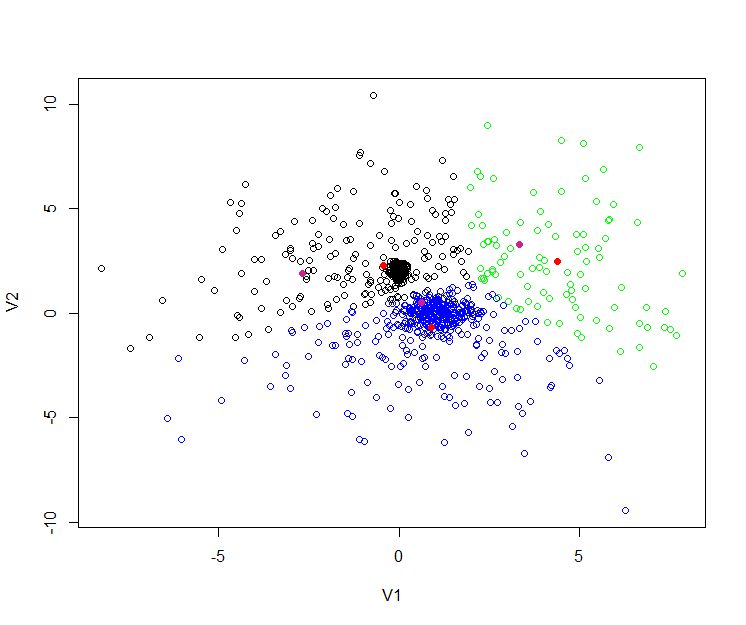

接下來爲了讓結果更直觀,我們再用R語言,進行kmeans實驗,操作相同的數據。

R語言代碼:

> y<-read.csv(file="randomData.csv",sep=",",header=FALSE)

> cl<-kmeans(y,3,iter.max = 10, nstart = 25)

> cl$centers

V1 V2

1 -0.4323971 2.2852949

2 0.9023786 -0.7011153

3 4.3725463 2.4622609

# 生成聚類中心的圖形

> plot(y, col=c("black","blue","green")[cl$cluster])

> points(cl$centers, col="red", pch = 19)

# 畫出Mahout聚類的中心

> mahout<-matrix(c(-2.686856800552941,1.8939462954763795,0.6334255423230666,0.49472852972602105,3.334520309711998,3.2758355898247653),ncol=2,byrow=TRUE)

> points(mahout, col="violetred", pch = 19)6). 比較Mahout和R的結果

從上圖中,我們看到有 黑,藍,綠,三種顏色的空心點,這些點就是原始的數據。

3個紅色實點,是R語言kmeans後生成的3箇中心。

3個紫色實點,是Mahout的kmeans後生成的3箇中心。

R語言和Mahout生成的點,並不是重合的,原因有幾點:

1. 距離算法不一樣:

Mahout中,我們用的 “歐氏距離(EuclideanDistanceMeasure)”

R語言中,默認是”Hartigan and Wong”2. 初始化的中心是不一樣的。

3. 最大迭代次數是不一樣的。

4. 點合併時,判斷的”閾值(threshold)”是不一樣的。

6. 模板項目上傳github

https://github.com/bsspirit/maven_mahout_template/tree/mahout-0.6

大家可以下載這個項目,做爲開發的起點。

~ git clone https://github.com/bsspirit/maven_mahout_template ~ git checkout mahout-0.6

我們完成了第一步,下面就將正式進入mahout算法的開發實踐,並且應用到hadoop集羣的環境中。