隨着移動互聯、雲計算及大數據等新技術與應用的飛速增長,金融機構對於數據中心的依賴程度也在日益加強,7*24全天業務連續運營已經成爲核心關鍵業務的最基本需求之一。同時隨着國家法規的不斷健全,同城災備、兩地三中心以及多數據中心正在成爲銀行的標配。正常情況下,主中心和備中心各司其職,發生災難時,主數據中心宕機、備份數據中心可以快速恢復數據和應用,從而減輕因災難給用戶帶來的損失。但是,災備中心建設的投資巨大及每年高昂的運維成本,加之其災備的角色,往往成爲了企業的閒置資源,進而變成了“空轉”數據中心。

另一方面,隨着微博、微信等互聯網公司紛紛拿到國家支付牌照。支付寶的金融產品也已在年輕用戶間取得了極大的進展……互聯網金融化正在以其雄厚的IT技術與多樣化的應用不斷的向傳統金融業***。如何盤活閒置資源,如何更好、更高效的發揮先有數據中心,使其不僅在必要時進行災備,同時可以在閒時提升企業核心應用的效率,成爲了每個金融業CIO共同關心的話題。

作爲應用交付領域的長期領導者,F5於日前推出了其革命性基於軟件定應用服務(SDAS)的新融合架構(Synthesis) ,旨在促進數據中心、雲和混合環境中應用服務的交付和協調。通過部署F5的解決方案,用戶的基礎架構將具備全面的設備靈活性和彈性,可智能分配資源,支持在物理和虛擬解決方案之間按需擴展系統。與其他方式不同,F5可向特定應用、服務或實例分配專用資源,能夠支持企業動態管理資源。因此,IT 管理員可自由地部署高度靈活的系統,根據應用要求將資源擴展至任何雲或數據中心,並在不需要時快速回收這些資源。與此同時,用戶將能夠根據業務策略智能地利用資源,並可將應用交付服務與新興 SDN、雲及網絡虛擬化計劃相結合。通過這種方式,採用雙活數據中心,甚至兩地三中心網絡架構的用戶,不僅可以更高效的盤活資源提高投資回報率,更可以在容災備份時,真正達到分鐘級的全面切換、甚至是“一鍵切換”,使應用真正的安全、快速、高可用。

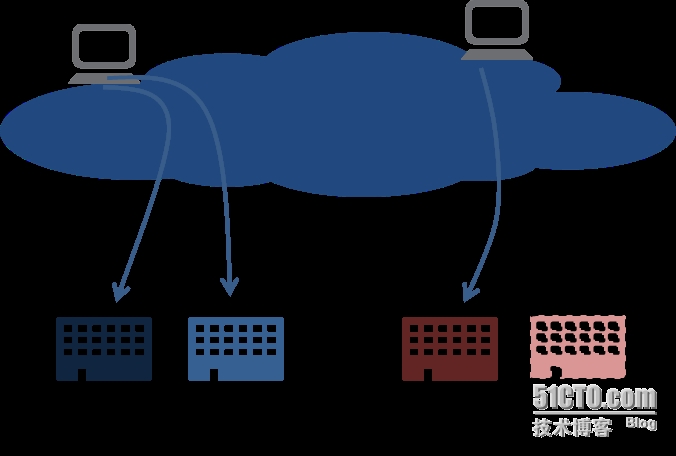

雙活數據中心區別於傳統主備數據中心,前者是兩個數據中心都處於運行當中、都有實時交易的業務,且互爲備份,所以稱爲“雙活”;後者是一個數據中心投入運行,另外一個數據中心處於非工作狀態,只有當災難發生時,生產數據中心癱瘓,災備中心纔會啓動。

雙活數據中心有二個最大的特點。一是有效利用資源,避免了一個數據中心長期處於閒置狀態而造成浪費。通過資源整合與有效負載,雙活數據中心的服務能力遠遠高於單活數據中心。二是在一個數據中心發生故障時,另外一個數據中心還在運行,對用戶提供不間斷的業務,保證用戶體驗與業務持續性。而一個災備中心的模式,如果生產數據中心癱瘓,需要半個小時、兩個小時、甚至更長時間才能啓動災備中心,在啓動災備中心的時間裏,用戶交易會嚴重受損。

在國內的商業銀行當中,部署了雙活數據中心的銀行還爲數甚少,光大銀行是最早開始這方面探索的銀行之一。光大銀行災備體系是典型的“兩地三中心”模式,目前在北京有兩個規模相當的雙活中心,在武漢有一個異地災備中心。

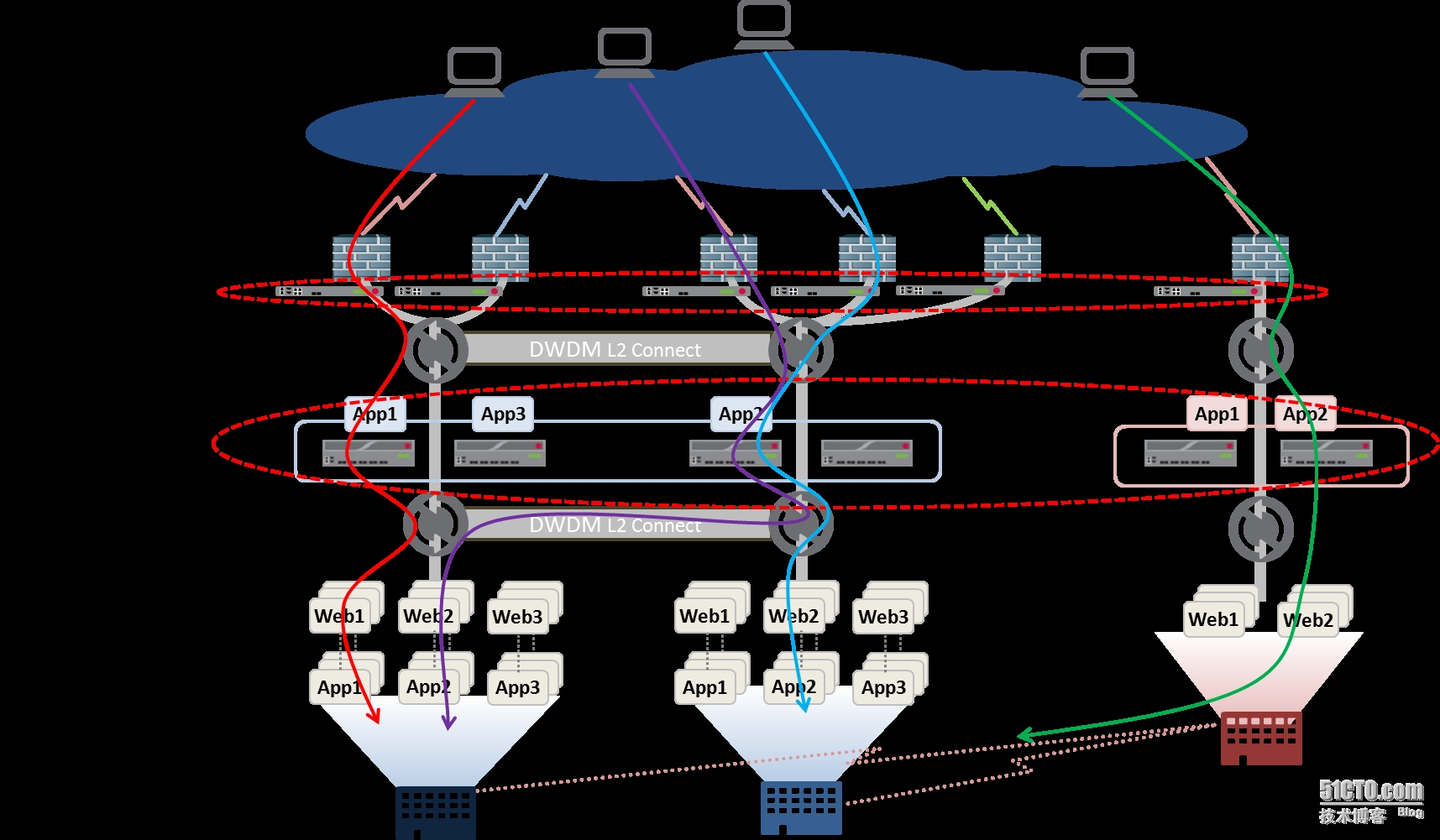

光大銀行的雙活數據中心的模式始建於2002年。當時還沒有出現雲計算的概念,但是這個思路和今天雲計算的思路不謀而合。“雲”的目的就是把數據中心的所有資源整合成一個資源,成爲一朵雲。雙活數據中心的效果也是一樣的。而在這種數據中心雙活的模式下,對網絡的靈活性要求就會更高:如何實現數據中心間的流量負載與業務的冗餘?怎麼將用戶定位到最近、響應最快的數據中心?如何實現雙活數據中心業務的靈活切換?這些問題成爲基礎網絡架構面臨的主要問題。在此,我們只針對雙活數據中心使用F5 GTM與LTM實現應用交付進行介紹,包括雙活數據中心互聯網業務負載均衡與雙活數據中內部應用跨中心的負載均衡。

雙活數據中心互聯網業務負載均衡與冗餘的設計

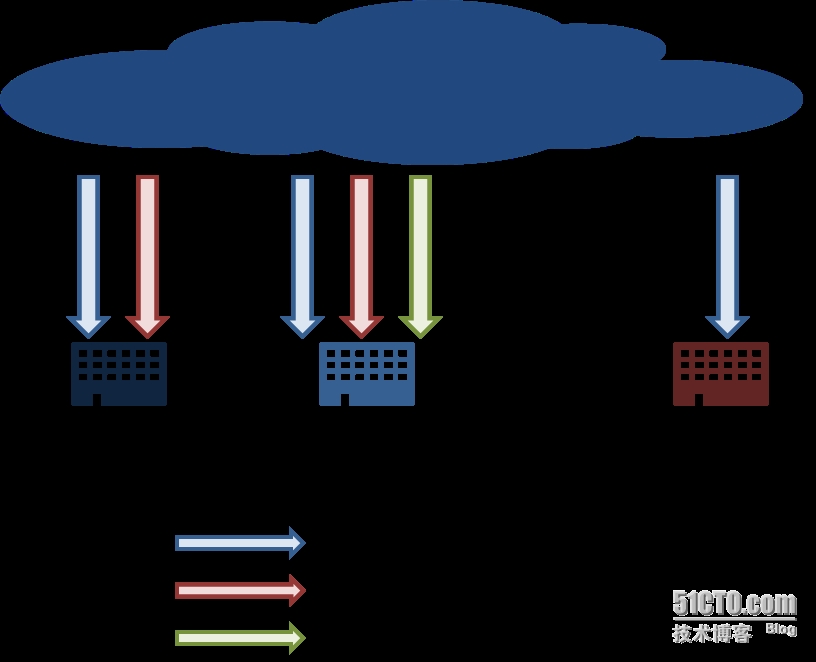

互聯網的負載均衡目前比較成熟的方式是DNS智能解析和路由注入,在此主要討論第一種方式即通過F5 GTM的DNS智能解析在數據中心之間如何實現流量負載與冗餘。DNS智能解析的思路是在DNS服務器中動態維持幾個後臺數據中心的出口IP地址,針對用戶請求按照算法返回最適合的出口IP。如果其中一個數據中心出口出現問題,DNS服務器便將其對應的IP地址暫停使用,並將後續的用戶DNS請求引導到其他仍在正常工作的數據中心出口,從在廣域網上實現後臺資源的負載均衡。

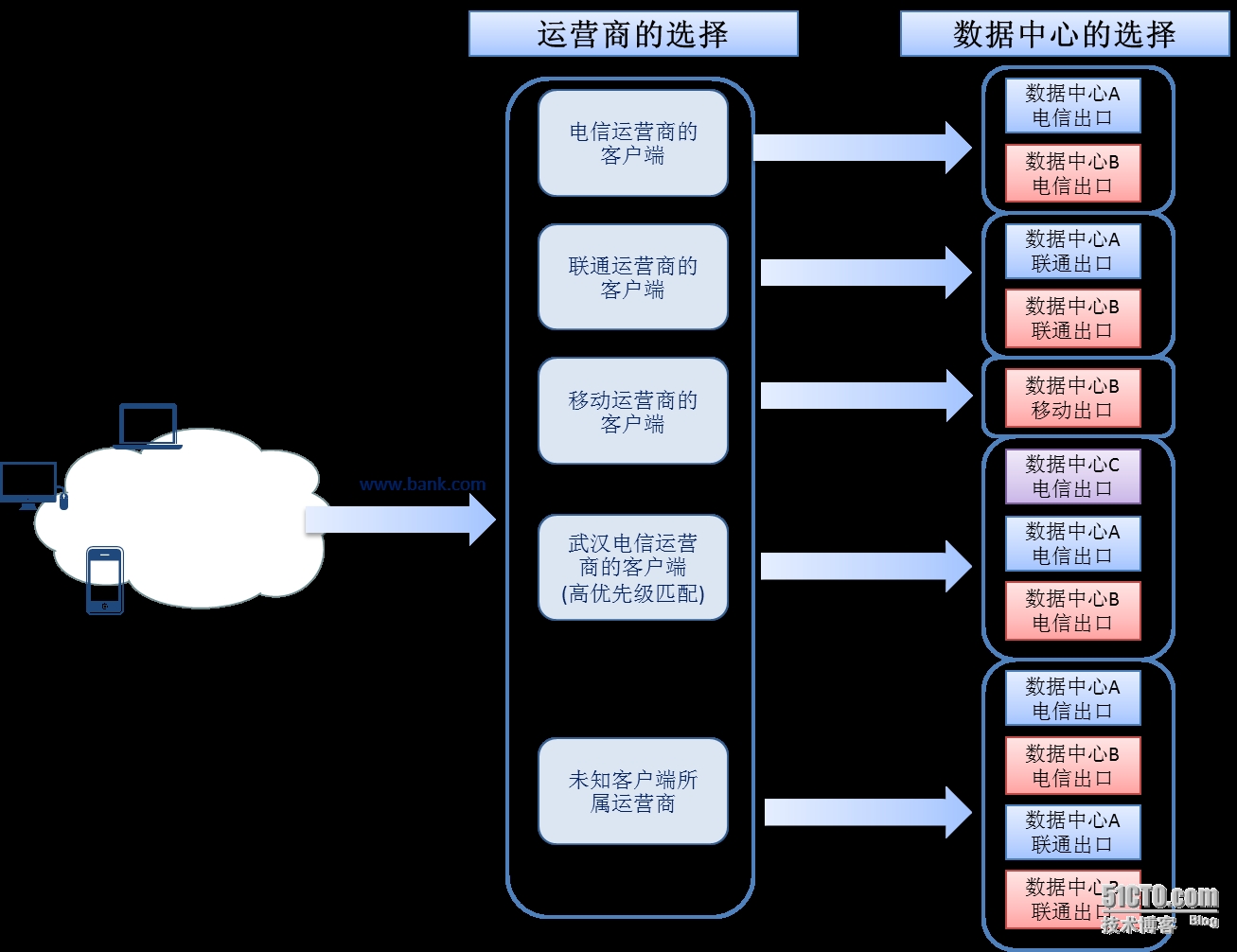

在金融行業的“兩地三中心”數據中心模式下,每個數據中心爲互聯網業務提供多個互聯網接口,北京數據中心A包含電信出口與聯通出口;北京數據中心B包含電信出口、聯通出口和移動出口;武漢數據中心C包含電信出口。北京數據中心A與北京數據中心B爲同城雙活數據中心,武漢數據中心爲災備數據中心,同時武漢數據中心C也發佈部分互聯網業務。

在DNS智能解析選擇出口時,不僅需要考慮哪個數據中心距離用戶較近,還要考慮跨運營商網絡限制的問題,目前國內主要的電信運營商有電信、網通、移動三大運營商,跨運營商的訪問往往很慢,最好的方式是將客戶流量定向到與客戶端相同運營商的數據中心。

同時考慮地域就近性原則,將南方電信客戶定向到武漢數據中心電信出口。將北方電信客戶定向到北京數據中心電信出口;同運營商的兩個數據中心的選擇依據是RTT(Round Trip Time)算法:在每個數據中心對客戶端進行反向探測,根據探測響應結果進行選擇。

最終形成兩層邏輯算法的DNS智能解析方式:首先根據互聯網客戶端所屬運營商選擇滿足條件的數據中心,再根據客戶端與數據中心間網絡鏈路質量選擇數據中心鏈路,從而將客戶端端定向到最合適的數據中心出口。

雙活數據中心內部應用跨中心的負載均衡與冗餘設計

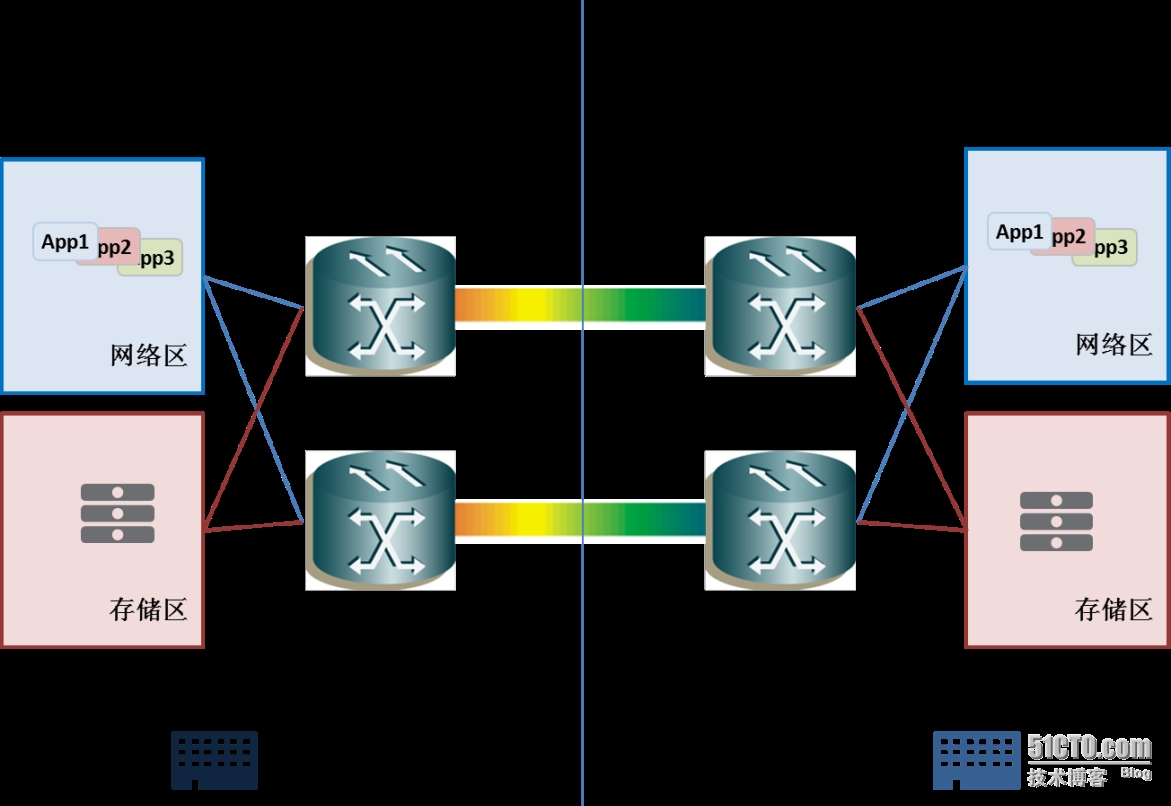

數據中心的雙活通過Cisco DWDM(密集波分多路複用)設備之間的連接實現,對兩個數據中心之間的互連設備而言,DWDM是透明的,等同於使用光纖直接連接。利用DWDM設備,實現了兩個數據中心間同網段二層vlan互通,緊密結合了目前雲計算中的“大二層”的概念。

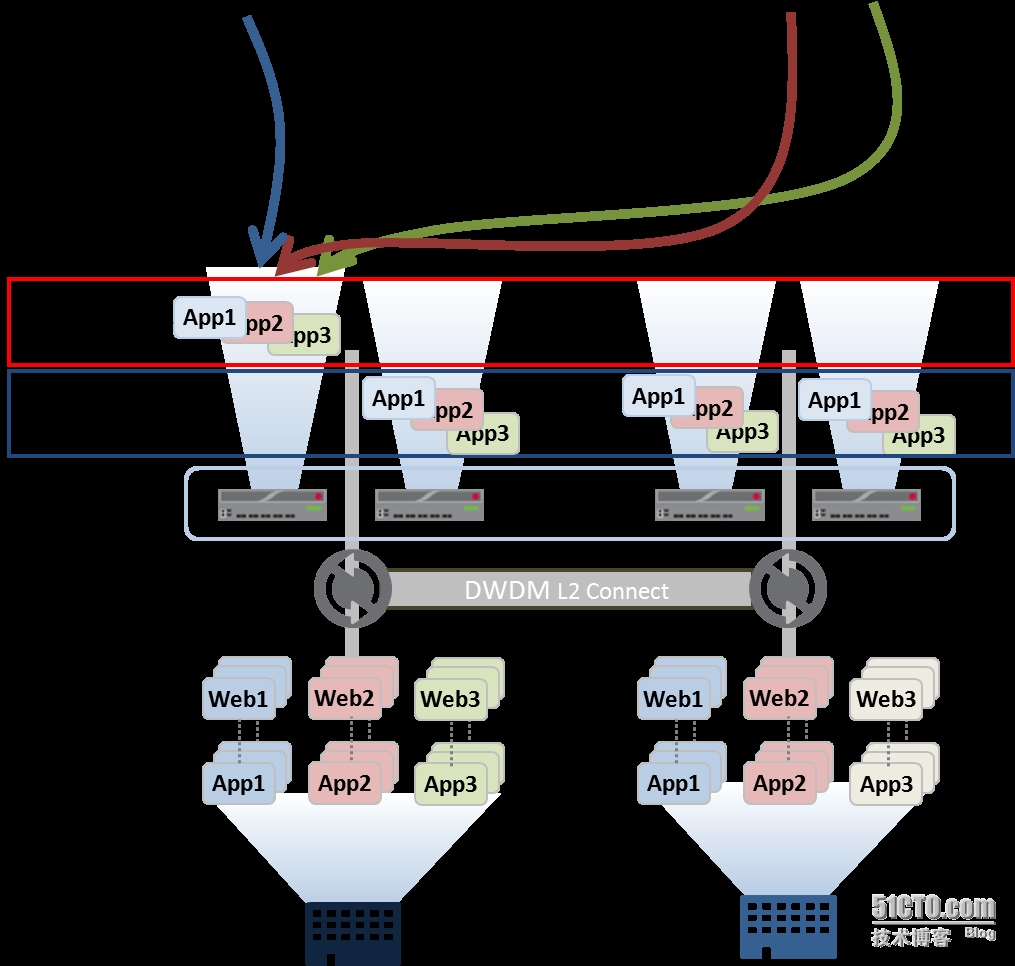

每個應用系統的服務器可以按需部署在兩個的數據中心內,而且不必關心所處的物理位置。通過負載均衡設備,對分佈在兩個數據中心的系統進行流量負載,在某臺系統服務器產生故障時,負載均衡設備可以將客戶流量轉發至其他服務器上。但在這種模式下,雖然業務系統分佈在兩個數據中心,但由於負載均衡設備的主備模式,業務流量還需要匯聚到主負載均衡設備上再轉發至兩個數據中心的服務器上,同時服務器的回覆流量也需要匯聚至主負載均衡設備上再轉回給客戶端,這樣不僅增加了業務數據流的複雜度與風險集中化。同時在主設備發生故障需要切換時候,業務數據流會跟隨負載均衡系統一同切換至另外的數據中心。爲了避免上述問題帶來的影響,產生了負載均衡設備的“2+2結構”:即同中心兩臺負載均衡設備爲主備模式,另外數據中心爲冷備的A。這種情況下,當一臺設備產生故障優先在本中心內部主備切換,當兩臺設備都有問題的情況下才會切換至第二數據中心。

但不論上述那種方式,真正發佈服務的只有一臺設備,這樣導致即使是雙活數據中心,數據仍需要匯聚至Active設備上,加劇了風險集中。同時設備利用率低,處於冷備的Active+Standy兩臺設備切換也需要人爲干預,不能在設備或者業務出現問題時候自動切換。

F5負載均衡系統的新版本支持N+M Cluster多活的架構,在同一個Group中的負載均衡設備可以自由分配“Active”與“Standby”比例,且可以指定Group中多臺負載均衡設備的接管順序,這種模式完全解決了2+2模式下冷備的兩臺設備利用率低的問題。同時可以將應用發佈在不同的Active的設備上,在設備出現故障的時候指定同數據中心的負載均衡設備優先接管,帶來的好處是雙活數據中心業務不再集中化,不必將所有業務流量都匯聚至一個數據中心再分發。避免了風險集中同時均衡兩個數據中心間的業務流量。

通過F5 GTM與LTM實現的應用交付網絡,在數據中心之間實現靈活的流量負載與無縫切換,在數據中心內部實現智能的流量管理與分配。GTM的雙層邏輯算法,不僅爲客戶選擇用戶體驗最佳的數據中心互聯網接口,也同時對互聯網流量進行負載均衡至多個數據中心。當某個數據中心互聯網接口故障時候,能夠立即將客戶流量引導至次優的數據中心互聯網接口。在數據中心內部,利用LTM對應用系統進行智能流量分配與管理,新的“N+M”clustr架構不僅解決了應用集中風險問題,同時提供靈活應用部署與無縫的業務切換,爲雙活數據中心的應用交付網絡再添活力。

在F5看來,任何IT資產的閒置,不僅是企業的巨大浪費,同時也會對其商業模式的發展與轉換產生制約,數據中心尤其如此。雙活、多活數據中心不僅可以盤活企業閒置資源,同時可以幫助金融機構在業內與業外的雙重競爭壓力下,不斷髮展更多優良的業務,吸引用戶。開源與節流的雙管齊下,才能使得傳統金融行業在金融網絡化的道路上越走越遠。