如果你看了我的上一篇文章,那此時你對hadoop已經有了一個大概的瞭解,那接下來這篇文章就教大家怎麼安裝hadoop環境,只要你用心,仔細的跟着文章中講到的做,肯定能正確安裝。

安裝hadoop環境

由於大家在學習hadoop時候,主要以Hadoop 1.0環境爲主學習就可以,所以這主要介紹如何搭建Hadoop 1.0分佈式環境。

整個分佈式環境運行在帶有linux操作系統的虛擬機上,至於虛擬機和linux系統的安裝這裏暫不做過多介紹。

安裝Hadoop分佈式環境:

1) 下載Hadoop安裝包:

在本站下載地址 http://down.51cto.com/data/2290706 中可以找到hadoop-1.2.1-bin.tar.gz文件

使用securtCRT的rz功能上傳hadoop-1.2.1-bin.tar.gz這個文件到虛擬機的系統中。

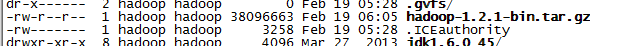

同樣在securtcrt中ll時,能得到

2) 安裝Hadoop安裝包:

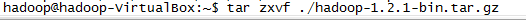

l 首先將安裝包解壓縮:

l Linux終端執行cd進入相應目錄:

l 新增tmp目錄,mkdir /home/hadoop/hadoop-1.2.1/tmp

3) 配置Hadoop:

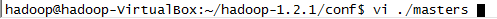

l 使用vim修改master文件內容:

將localhost修改成master:

最後保存退出。

l 修改slaves文件

注意,這裏準備設置幾臺slave機器,就寫幾個,因爲當前分佈式環境有四個虛擬機,一臺做master,三臺做slave,所以這裏寫成了三個slave

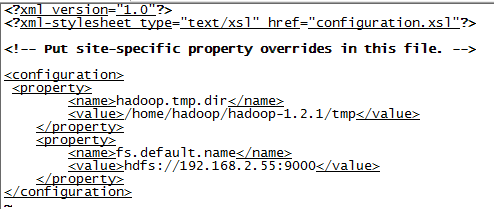

l 修改core-site.xml文件:

【注意】中間的ip地址,不要輸入192.168.2.55,根據自己的情況設置。

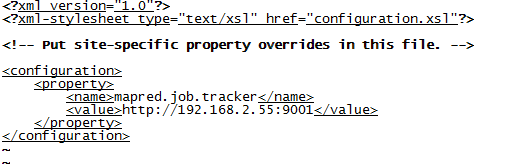

l 修改mapred-site.xml文件:

【注意】記得value的內容要以http開頭。

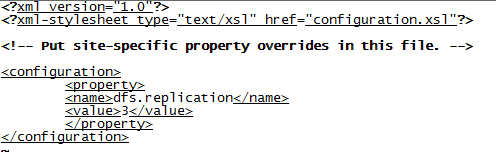

l 修改hdfs-site.xml文件:

其中,<value>3</value>視情況修改,如果有三臺slave機器,這裏設置成3,如果只有1臺或2臺,修改成對應的值即可。

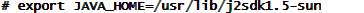

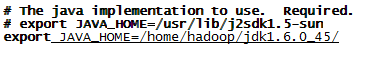

l 修改hadoo-env.sh文件

下新增export JAVA_HOME=/home/hadoop/jdk1.6.0_45/

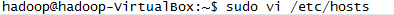

l 修改本地網絡配置:編輯/etc/hosts文件

【注意】Ip地址根據具體的情況要進行修改。

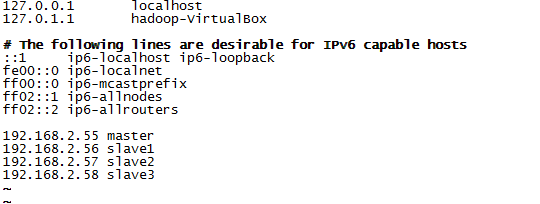

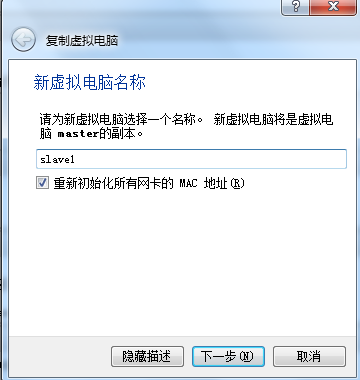

4) 複製虛擬機

l 關閉當前虛擬機,並複製多份

【注意】要選擇初始化所有網卡的mac地址

根據自己需求,複製2到3臺虛擬機作爲slave,同樣要確認網絡連接方式爲橋接。

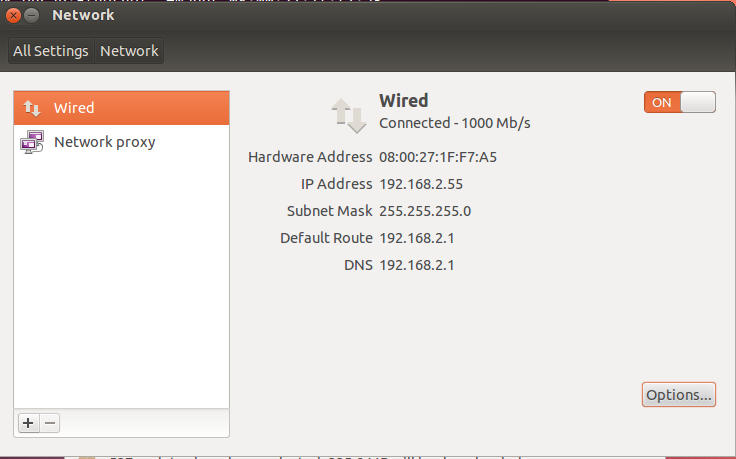

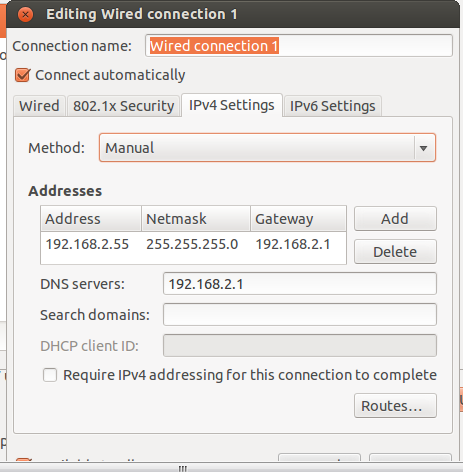

l 設置所有機器的IP地址

分別啓動虛擬機,修改機器的ip 地址,在虛擬機的圖形界面裏,選擇設置

打開

【注意】具體的ip地址,根據實際的情況來設置,因爲培訓教室裏都是192.168.2.x的網段,所以我這裏設置成了192.168.2.x,每個人選擇自己的一個ip地址範圍,注意不要和其它人衝突了。

5) 建立互信關係

l 生成公私鑰,在master機器的虛擬機命令行下輸入ssh-keygen,一路回車,全默認

l 複製公鑰

複製一份master的公鑰文件,cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

同樣,在所有的slave機器上,也在命令行中輸入ssh-keygen,一路回車,全默認

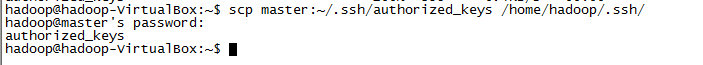

在所有的salve機器上,從master機器上覆制master的公鑰文件:

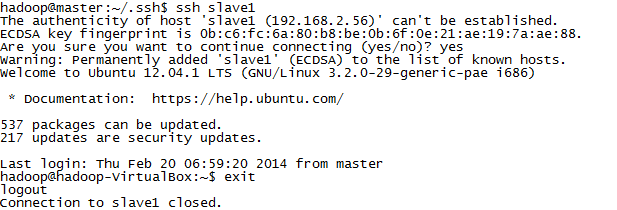

l 測試連接

在master機器上分別向所有的slave機器發起聯接請求:

如:ssh slave1

【注意】記得一旦聯接上,所有的操作,就視同在對應的slave上操作,所以一定要記得使用exit退出聯接。

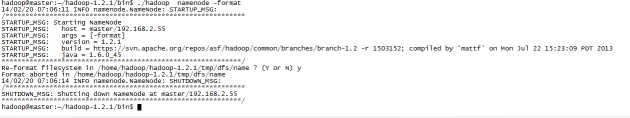

6) 啓動Hadoop:

l 初始化:在master機器上,進入/home/hadoop/hadoop-1.2.1/bin目錄

在安裝包根目錄下運行./hadoop namenode –format來初始化hadoop的文件系統。

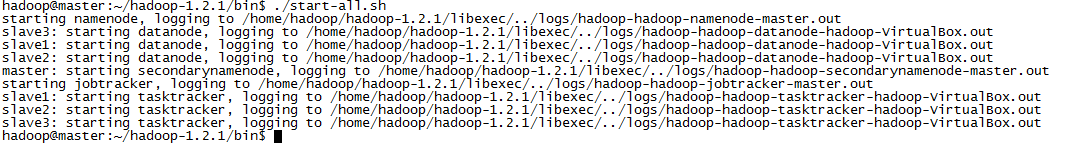

l 啓動

執行./start-all.sh,如果中間過程提示要判斷是否,需要輸入yes

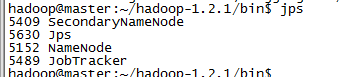

輸入jps,查看進程是否都正常啓動。

如果一切正常,應當有如上的一些進程存在。

7) 測試系統

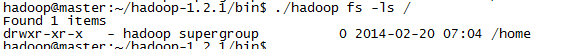

輸入./hadoop fs –ls /

能正常顯示文件系統。

如此,hadoop系統搭建完成。否則,可以去/home/hadoop/hadoop-1.2.1/logs目錄下,查看缺少的進程中,對應的出錯日誌。

此時,你已經把hadoop環境搭建好了,下一篇文章將給大家介紹什麼是HDFS文件系統,HDFS又能做什麼呢?

如何用4個月學會Hadoop開發並找到年薪25萬工作?

免費分享一套17年最新Hadoop大數據教程和100道Hadoop大數據必會面試題。

因爲鏈接經常被和諧,需要的朋友請加微信 ganshiyun666 來獲取最新下載鏈接,註明“51CTO”

教程已幫助300+人成功轉型Hadoop開發,90%起薪超過20K,工資比之前翻了一倍。

內容包括0基礎入門、Hadoop生態系統、真實商業項目實戰3大部分。其中商業案例可以讓你接觸真實的生產環境,訓練自己的開發能力。