Original url:

http://blog.csdn.net/zhangjunhit/article/details/78249184

Attention in Neural Networks and How to Use It

http://akosiorek.github.io/ml/2017/10/14/visual-attention.html

這篇博文主要介紹神經網絡中的注意力機制,代碼實現了兩個 soft visual attention

What is Attention? 首先來看看 注意力機制是什麼?

在非形式化上,神經注意機制賦予神經網絡關注其輸入(或特徵)子集的能力:它選擇特定的輸入。

注意力機制可以讓一個神經網絡能夠只關注其輸入的一部分信息,它能夠選擇特定的輸入。

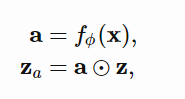

attention is implemented as

f 是一個 attention network,其生成一個 attention vector a, 再講 a 與輸入 x 的 特徵向量 z 相乘,這個 a 取值範圍是 【0,1】,當我們說 soft attention 時,其取值是 0 到 1,當我們說 hard attention 其取值就只有 0 或 1。

爲什麼 attention 是重要的了?我們還有從 neural network 的本質說起, neural network 本質上就是一個 函數擬合器 function approximator,它的結構決定其可以擬合什麼類型的函數,通常情況下輸入向量彼此的作用方式只能是相加。典型的神經網絡是由矩陣乘法和元素非線性構成的,其中輸入或特徵向量的元素僅通過加法相互作用。

但是 注意力機制可以讓輸入向量之間的作用方式是相乘 ,注意機制計算一個用於多重特徵的掩碼。

神經網絡是一種通用的函數逼近器,可以對任意函數進行任意精度的逼近,但只能在無限個隱藏單元的極限內進行逼近。在任何實際的設置中,情況都不是這樣:我們受到可以使用的隱藏單元數量的限制。注意力引入的 multiplicative interactions 可以讓我們擬合更復雜的函數模型。

該模型在生成描述該部分的單詞時,學習關注圖像的特定部分

注意力機制擴展了神經網絡的功能:它們允許逼近更復雜的函數,或者用更直觀的術語來說,它們允許專注於輸入的特定部分。